Ученые из Беркли учат ИИ понимать, что такое плохо

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2016-09-02 16:26

Калифорнийский университет в Беркли запустил центр, который займется обучением искусственного разума распознаванию человеческих ценностей, сообщает Popular Science.

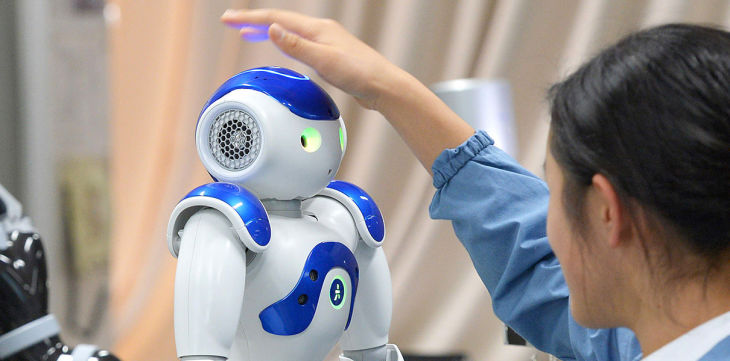

The Center for Human-Compatible Artificial Intelligence (Центр «человеко-совметимого» искусственного интеллекта) возглавит профессор информатики и пионер в области ИИ Стюарт Рассел. Он с коллегами займется разработкой роботов, которые с помощью наблюдений смогут разобраться и понять, что для человека является ценностью. Машина понимающая, что важно, а что нет, будет максимально дружелюбна к человеку. Если все получится, сценарий восстания машин будет невозможен, считают основатели центра.

«Сегодняшние разработчики закладывают в роботов числа и значения, вместо того, чтобы дать им возможность наблюдать и учиться у людей - это может привести к катастрофе» - говорит Рассел.

Искусственный интеллект научился распознавать боль

Пока искусственный интеллект не сильно интегрирован в нашу жизнь, факт того, что компьютеры не думают о человеческих чувствах, не является большой проблемой, но это не надолго, объясняет ученый: «Как только искусственный интеллект окончательно переместится в реальный мир посредством самоуправляющихся автомобилей, цифровых помощников, как только он начнет делать покупки от вашего имени, играть на бирже - встанет необходимость встраивания роботов в систему общечеловеческих ценностей. Тогда и потребуется, чтобы роботы разбирались в том, что хорошо, а что плохо.»

Центр начал работу на этой неделе. Он получил финансирование от Open Philanthropy Project в размере $5,5 миллиона.

Источник: hightech.fm