Системы распознавания лиц «спасовали» перед большим объемом данных

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2016-06-28 17:41

Программы по распознаванию лиц могут быть не так эффективны, как полагают их создатели. Несмотря на то, что успешность их работы оценивается с помощью баз данных, содержащих десятки тысяч фотографий, когда количество изображений превышает полмиллиона, все алгоритмы справляются с заданием значительно хуже. Исследование будет представлено на Конференции IEEE по компьютерному зрению и распознаванию образов на этой неделе.

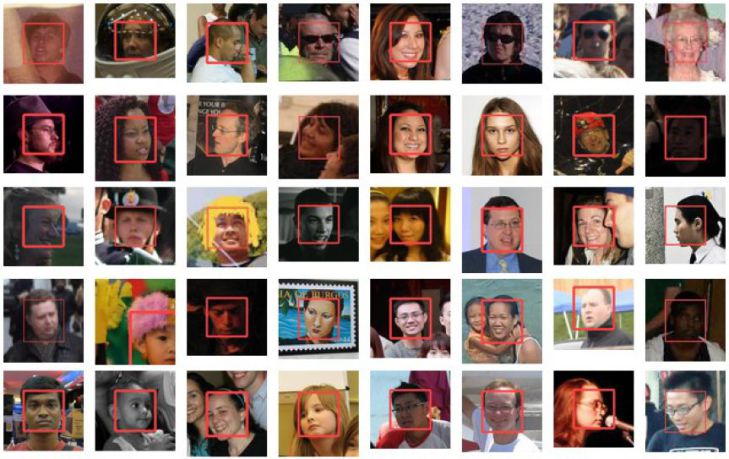

Ученые из Вашингтонского университета провели соревнование под названием MegaFace Challenge и оценили работу систем распознавания лиц с помощью больших баз данных. Они начали свою работу с того, что взяли два существующих набора изображений - один из них состоял из фотографий знаменитостей, сделанных с разных ракурсов (100 тысяч изображений 530 знаменитостей), а другой - из фотографий людей разных возрастов (975 изображений 82 человек). Затем они добавили к этим наборам «отвлекающие» фотографии пользователей Flickr, на которых было запечатлено более 690 тысяч человек.

Авторы работы предложили участникам MegaFace Challenge скачать базы данных и посмотреть, насколько хорошо их алгоритмы смогут найти среди всех лиц два одинаковых. Также программы должны были обнаружить совпадения с загруженной фотографией в базе данных.

Оказалось, что абсолютно все алгоритмы хуже справляются с задачей, когда количество «отвлекающих» данных увеличивается. В тесте, где за основу была взята база изображений людей разных возрастов, лучше всего показал себя алгоритм Google FaceNet, чья точность распознавания лиц упала только до 75 процентов, когда в набор фотографий был добавлен миллион «отвлекающих» изображений. Другой тест успешнее всех прошел алгоритм российской команды из лаборатории NTechLab, ухудшив свой результат до 73 процентов.

Количество «отвлекающих» факторов начиналось с 10 и достигало миллиона

University of Washington

Точность распознавания лиц остальных программ упала значительно сильнее - в некоторых случаях до 33 процентов. Исследователи объясняют это тем, что наиболее эффективные алгоритмы были обучены с помощью большого объема данных (например, для обучения FaceNet использовалось более 500 миллионов фотографий 10 миллионов людей).

В конце лета команда ученых планирует создать базу данных, в которой будут собраны по несколько фотографий полумиллиона людей, для того, чтобы разработчики могли использовать ее в обучении своих программ. Это позволит проверить работу алгоритмов в более равных условиях, так как большинство компаний не имеет доступа к таким большим коллекциям изображений, как Google.

Источник: oko-planet.su