Учёные задействовали 50 тыс. GPU в «облаках» для астрофизического эксперимента

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2019-12-02 21:39

Облачные вычислительные платформы вполне могут составить конкуренцию традиционным суперкомпьютерам. Это доказал эксперимент, поставленный совместно Суперкомпьютерным центром Сан Диего и Нейтринной обсерваторией Ice Cube.

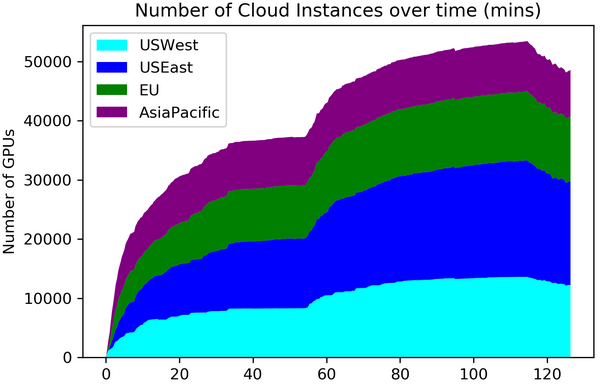

В эксперименте было задействовано свыше 50 тысяч доступных ускорителей, располагавшихся в облачных платформах Amazon Web Services, Microsoft Azure и Google Cloud Platform в 28 регионах трёх континентов ? Северной Америки, Европы и Азии.

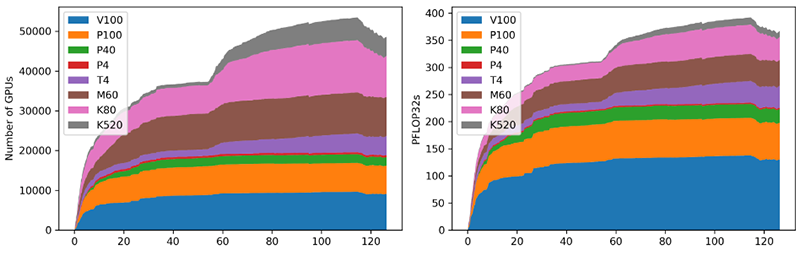

Статистика эксперимента: типы GPU и динамика нарастания производительности

Всего в облаках сейчас имеет примерно 80 тысяч NVIDIA Tesla V100. Фактически же для опыта задействовался весь доступный на тот момент для аренды массив разнородных ускорителей ? 51500 единиц. Он был объединён в единый комплекс с помощью ПО HTCondor.

Эксперимент начался 16 ноября и длился порядка 200 минут. Он преследовал три основных цели: выяснить, насколько серьёзные мощности можно задействовать таким образом; выявить реальные масштабы использования ГП в облаках; и, наконец, решить реальную научную задачу.На графике хорошо видно, как нарастала мощность «облачного суперкомпьютера»; она достигла максимума примерно к 110 минуте и составила приблизительно 350 Пфлопс (FP32). Для сравнения, лидер списка TOP500, суперкомпьютер Summit, развивает порядка 400 Пфлопс на вычислениях такой же точности.

Все сегменты общей задачи были оптимизированы с учётом особенностей каждой из восьми моделей доступных ускорителей NVIDA. Время работы сегментов не превышало 15?30 минут для минимизации риска отключения от сервиса из-за внезапно возникшего спроса. Примерная оценка затрат: от $120 до $150 тысяч в первый день вычислений. То есть около половины выделенного на описываемый проект гранта EAGER.

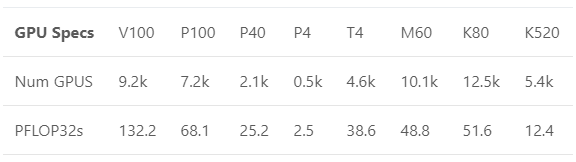

Вклад различных моделей GPU в общее дело

Для расчётов использовались данные, полученные нейтринной обсерваторией IceCube. Это крупнейший в мире детектор нейтрино, размещённый на антарктической станции Амундсен-Скотт. Он имеет массив из 5160 высокочувствительных оптических детекторов, размещённых в специальных скважинах на глубинах от 1450 до 2450 метров.

В 2017 году с помощью нового массива удалось впервые зафиксировать космические нейтрино сверхвысоких энергий и отследить их источник. За час эксперимента удалось провести симуляцию такого объема данных с детекторов IceCube, который в обычных условиях потребовал бы месяца.

Доля разных регионов в проекте

В настоящее время активно развивается так называемая «многоканальная астрономия» (multi-messenger astronomy). Её суть заключается в комплексном исследовании всего, что могут испускать астрономические объекты, от электромагнитного излучения до гравитационных волн и элементарных частиц. Но такая астрономия требует обработки гигантских массивов данных.

Проведённый эксперимент показал, что «облачные системы» подходят для подобных целей и позволяют развёртывать серьёзные мощности весьма оперативно, в течение небольшого промежутка времени, что крайне важно для проектов с жёсткими сроками.

Лаборатория IceCube

Хотя добиться запланированных изначально 80 тысяч ускорителей NVIDIA Tesla V100 и не удалось, но был получен бесценный опыт, который в перспективе должен проложить дорогу широкому использованию облачных сервисов с ГП-ускорителями и для других научных проектов. В ближайшем будущем бума облачных супервычислений не ожидается, ведь если они станут широко популярными, то стоимость такого предприятия неизбежно вырастет.

Следует также отметить, что «виртуальный суперкомпьютер» подходит для решения далеко не всех научных задач, связанных с супервычислениями. Некоторые из таких задач критичны к пропускной способности межсоединений, а это не самая сильная сторона подобного рода решений. Поставщики облачных услуг это понимают; в частности, на выставке SC19 Microsoft представила новые облачные серверы Azure, использующие внутреннюю сеть на базе InfiniBand HDR со скоростью 200 Гбит/с и поддержкой RDMA.

Источник:

Источник: servernews.ru