Как запустить DeepSeek R1 на Raspberry Pi 5: Пошаговая инструкция

МЕНЮ

Главная страница

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Искусственный интеллект

Слежка за людьми

Угроза ИИ

ИИ теория

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Психология ИИ

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Промпты. Генеративные запросы

Распознавание лиц

Распознавание образов

Распознавание речи

Творчество ИИ

Техническое зрение

Чат-боты

Авторизация

2025-11-15 11:17

Новейшая китайская нейросеть DeepSeek стала горячей темой на всемирной сцене. Как мощная открытая большая языковая модель (LLM), предназначенная для различных ИИ-приложений, от обработки естественного языка до генерации контента, она существует в моделях с разными размерами, что делает ее адаптируемой ко многим вычислительным средам.

В то время, как DeepSeek-R1 обычно работает на высокопроизводительном оборудовании, она также может быть запущена на Raspberry Pi 5 с надлежащей оптимизацией. Это руководство проведет вас через настройку совместимого окружения и установку необходимых инструментов до запуска DeepSeek-R1 на Raspberry Pi 5 с использованием платформы Ollama. Смотрите ли вы в сторону легкой модели с быстрыми ответами или на продвинутую версия с улучшенной точностью, эта статья поможет вам начать.

Четыре шага для запуска DeepSeek R1 на Raspberry Pi 5

Шаг 1: Настройка виртуального окружения

С целью избежания возможных конфликтов с исходными настройками системы, лучше создать виртульное окружение для развертывания модели. В дальнейшем это гарантирует, что любые изменения, сделанные для DeepSeek, не повлияют на другие приложения.

Создание директории проекта и виртуального окружения

Откройте окно терминала и выполните следующие команды

mkdir /home/pi/my_project cd /home/pi/my_project/ python -m venv /home/pi/my_project/Активация виртуального окружения

После создания виртуального окружения активируйте его

source /home/pi/my_project/bin/activateДеактивация

Для деактивации виртуального окружения используйте

deactivateОбязательно выполните все шаги настройки модели в этом виртуальном окружении.

Шаг 2: Установка платформы Ollama

DeepSeek-R1 может быть запущена с помощью фреймворка Ollama, который поддерживает файлы GGUF-форматной модели. Если вы выберите модель формата safetensors, вам нужно конвертировать ее в GGUF используя llama.cpp.

Проверка совместимости системы

Перед продолжением убедитесь, что система вашей Raspberry Pi 64-разрядная, выполнив команду

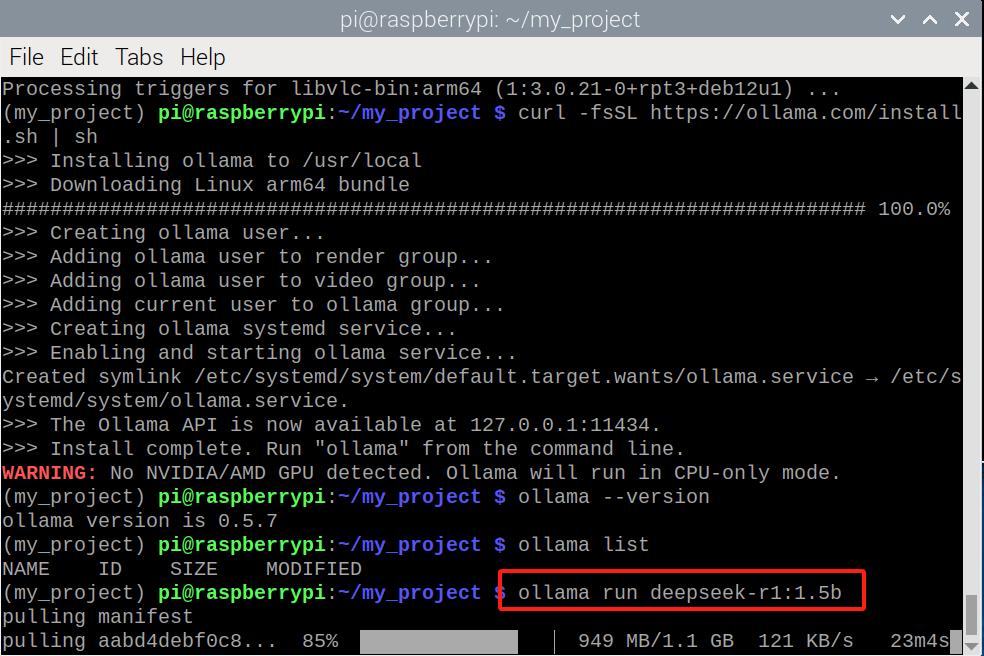

uname -mУстановка Ollama

Прежде всего, обновите ОС вашей Raspberry Pi

sudo apt update sudo apt upgrade -yЗатем, установите curl (требуется для скачивания Ollama)

sudo apt install curlТеперь скачайте и установите платформу Ollama

curl -fsSL https://ollama.com/install.sh | shПроверка установки

Убедитесь в том, что Ollama установлена успешно

ollama –versionТеперь, когда Ollama готова, переходите к скачиванию модели DeepSeek-R1

Шаг 3: Запуск DeepSeek-R1 на Ollama

Существует два пути получения модели DeepSeek-R1:

- Скачивание и запуск напрямую из Ollama

- Скачивание модели из HuggingFace с последующим импортом её в Ollama

Ollama требуется независимо от метода.

Метод 1: Скачивание и запуск напрямую из Ollama

Ollama предоставляет предварительно сконфигурированные модели, тем самым упрощая начальный путь.

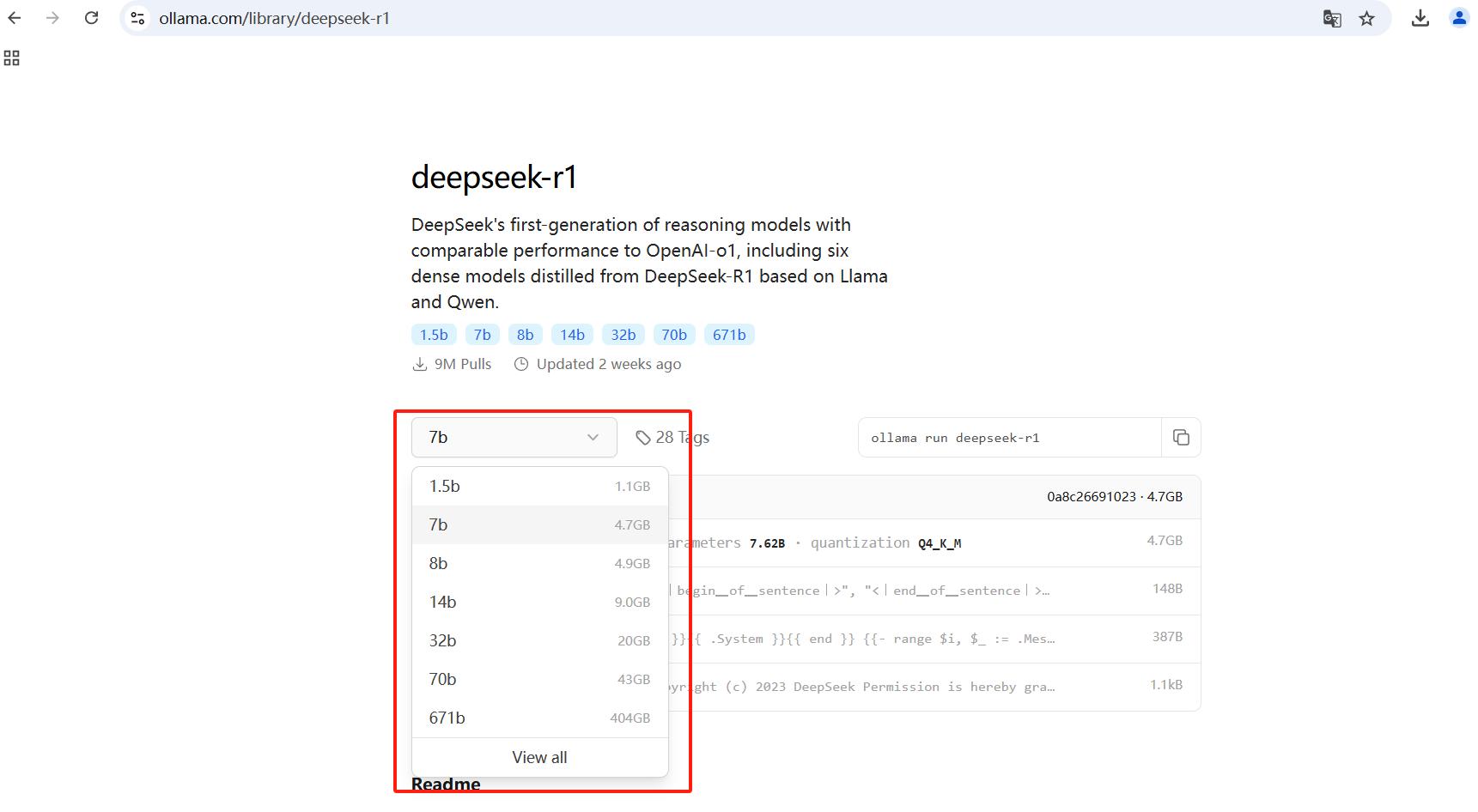

Найдите DeepSeek-R1 на веб-сайте Ollama и подберите модель подходящего размера.

Для запуска модели 1.5B:

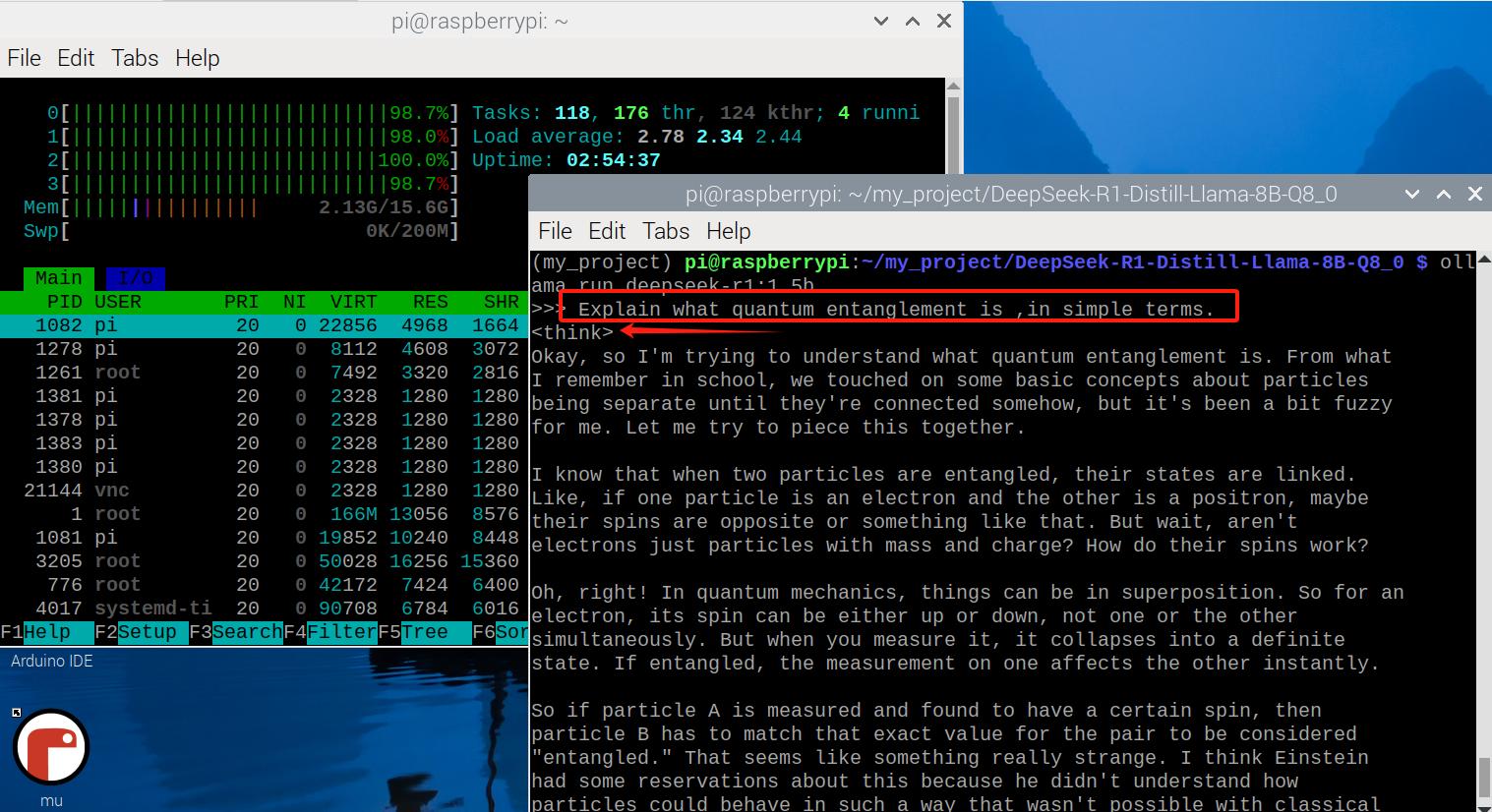

ollama run deepseek-r1:1.5bЗадайте ИИ-модели вопрос наподобие: Explain whate quantum entanglement is, in simple terms (Объясни простыми терминами, что такое квантовая запутанность). Она сразу же ответит, также отобразив свой мыслительный процесс.

Метод 2: Скачивание модели из HuggingFace

Загрузка из HuggingFace позволяет вам выбрать конкретный размер модели. Польза возможности выбора в том, что Raspbetty Pi 5, даже с 16ГБ оперативной памяти, не способна эффективно справиться с крупными моделями.

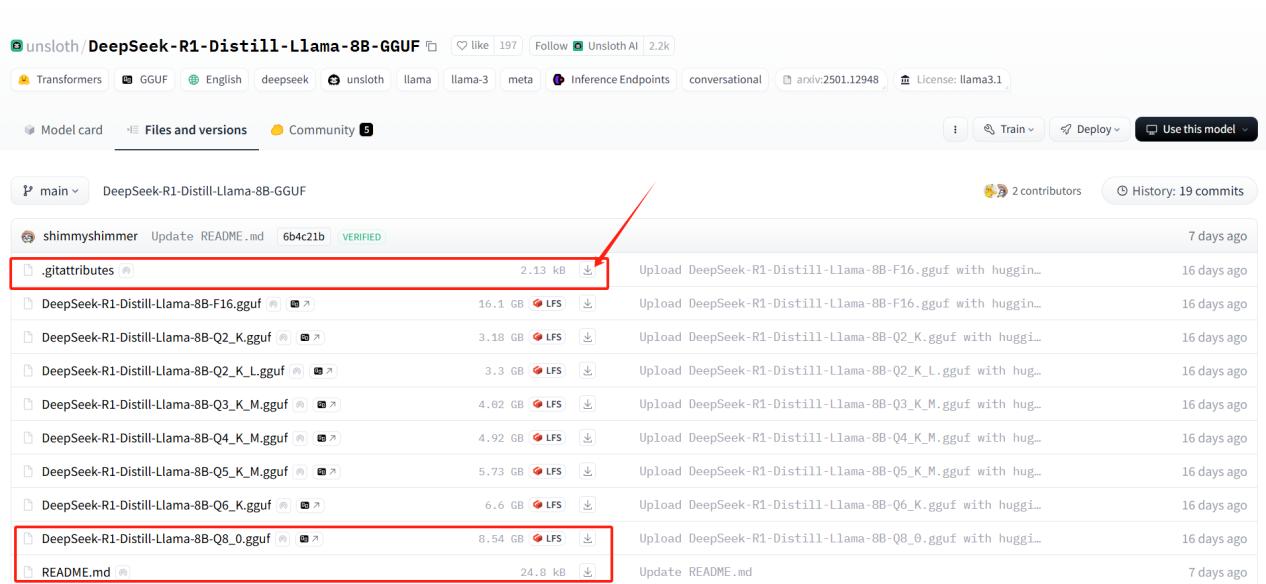

Выбор модели из HuggingFace

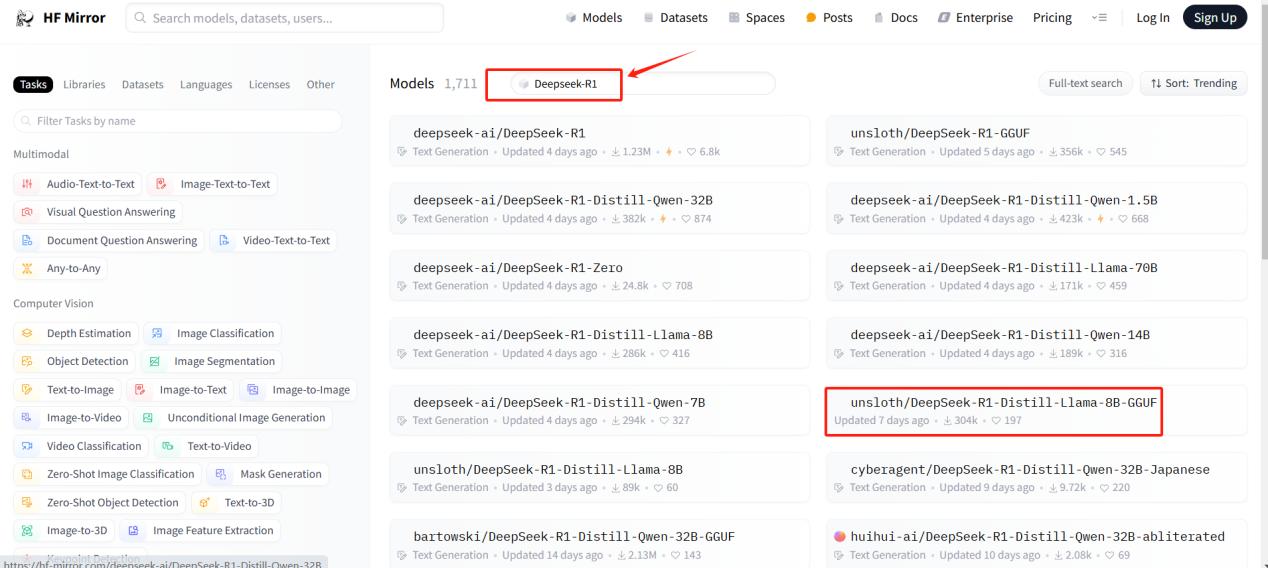

- Посетите HuggingFace и найдите DeepSeek-R1.

- Выберите меньшую дистиллированную версию, подходящую для Raspberry Pi 5

- В этом руководстве мы будем использовать модель DeepSeek-R1-Distill-Llama-8B-GGUF, которая имеет 8 миллиардов параметров и оптимизирована на производительность.

- Скачайте файл модели Q8_0 (~8.54ГБ), така как она сбалансирована между качеством и эффективностью.

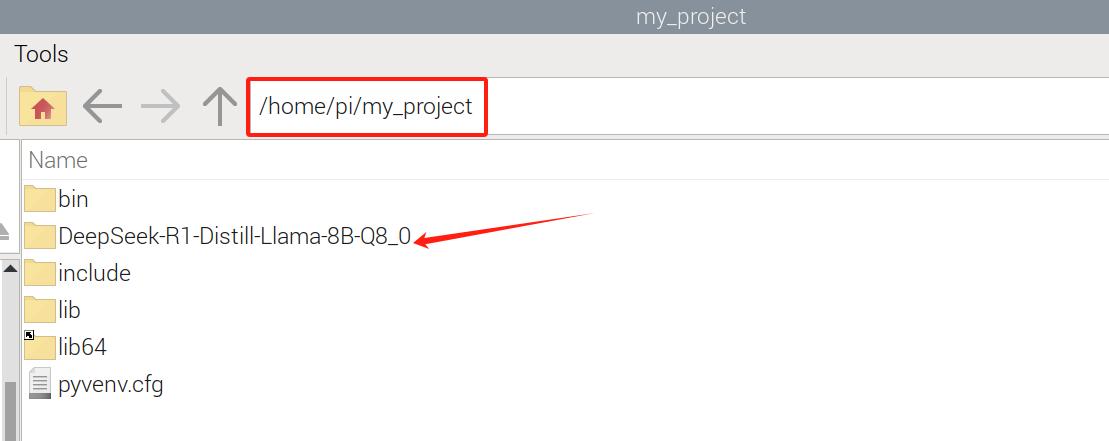

Передача файлов модели в Raspberry Pi

После скачивания трех фалов, переместите их в вашу Raspberry Pi при помощи FileZilla или другого приложения для перемещения файлов.

Шаг 4: Импорт GGUF-модели в Ollama

После того, как файлы модели окажутся в Raspberry Pi, нам нужно импортировать их в Ollama

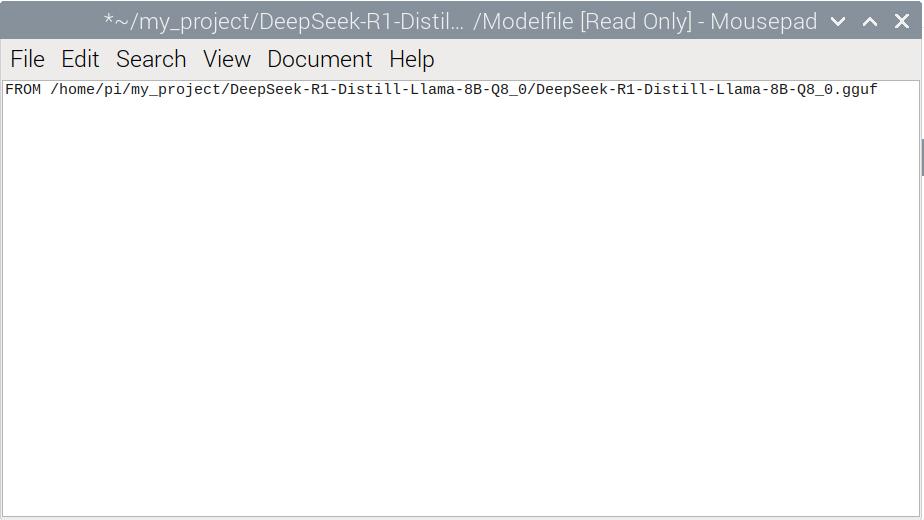

Создание Modelfile

Сначала создайте файл с именем Modelfile в папке модели и предоставьте полные права доступа:

sudo touch /home/pi/my_project/DeepSeek-R1-Distill-Llama-8B-Q8_0/Modelfile sudo chmod 777 /home/pi/my_project/DeepSeek-R1-Distill-Llama-8B-Q8_0/ModelfileДобавление конфигурации модели

Откройте Modelfile и добавьте в него строку

FROM /home/pi/my_project/DeepSeek-R1-Distill-Llama-8B-Q8_0/DeepSeek-R1-Distill-Llama-8B-Q8_0.gguf

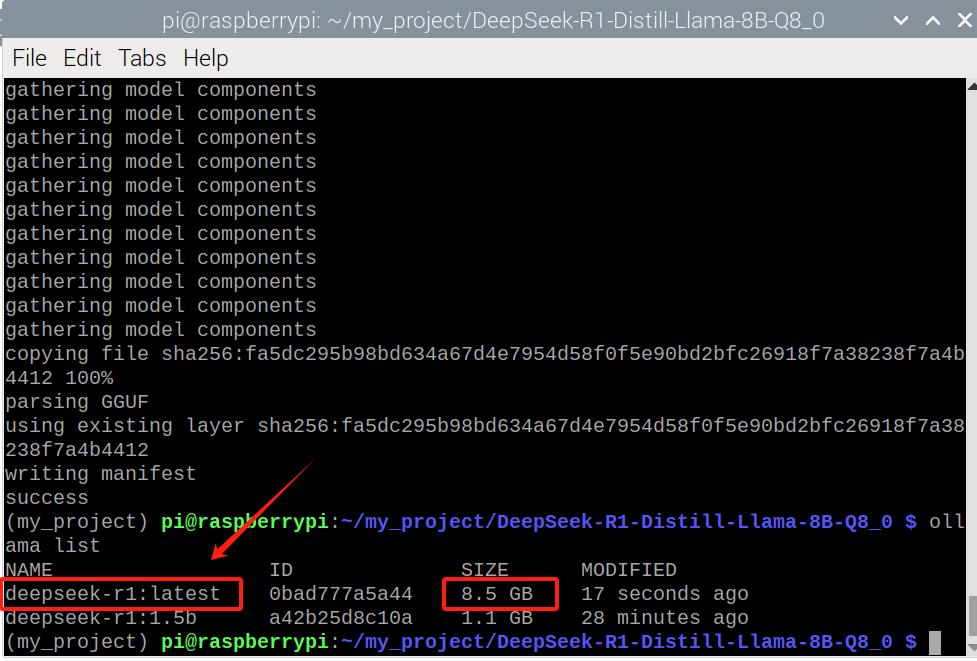

Теперь создайте модель в Ollama:

ollama create DeepSeek-R1 -f ModelfileПроверьте доступность созданной модели

ollama listОбратите внимание на полное название созданной модели. Любые действия с этой моделью (запуск, остановка, удаление...) возможны с указанием ее полного имени.

И наконец запустите модель:

ollama run deepseek-r1:latestЗадавайте DeepSeek-R1 вопросы и наблюдайте ее ответы.

Сравнение параметров модели

Мы протестировали две версии DeepSeek-R1:

- DeepSeek-R1-1.5B (загруженный напрямую из Ollama)

- DeepSeek-R1-Distill-Llama-85B (скачанный из HuggingFace)

Отличия производительности

| Модель | Размер | Качество ответа | Скорость | Использование памяти |

| 1.5B (Ollama) | Малый | Приличное | Быстрая | Низкое |

| 8B (HuggingFace) | Большой | Лучшее | Медленная | Высокое |

Если у вас в приоритете быстрый ответ, используйте DeepSeek-R1-1.5B. Если вам нужен высококачественный ответ, используйте DeepSeek-R1-8B, но помните про ограничения памяти.

Заключение

Следуя этой инструкции, вы сможете успешно запустить DeepSeek-R1 на Raspberry Pi 5 с использованием платформы Ollama. Если вас интересует легкая настройка, лучше воспользоваться прямой загрузкой ИИ-модели из Ollama. Однако, HuggingFace предоставляет большую гибкость в выборе ИИ-модели конкретного размера.

Экспериментируйте c вашей моделью и смотрите, на что она способна!

Источник: compacttool.ru