"Люди больше не нужны". Искусственный разум выводят на новый уровень

МЕНЮ

Главная страница

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Искусственный интеллект

Слежка за людьми

Угроза ИИ

ИИ теория

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Психология ИИ

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Промпты. Генеративные запросы

Распознавание лиц

Распознавание образов

Распознавание речи

Творчество ИИ

Техническое зрение

Чат-боты

Авторизация

2025-04-27 15:09

ChatGPT устарел

“Если вы студент, заинтересованный в создании систем искусственного интеллекта следующего поколения, не работайте над большими языковыми моделями. Вам нужно заняться тем, что преодолеет ограничения LLM”, — заявил ранее информатик Ян Лекун, один из пионеров разработки ИИ, а ныне — главный специалист по этой теме в компании Meta*.

По его мнению, чат-боты ChatGPT, DeepSeek, Grok, Gemini устареют в ближайшие пять лет. Непреодолимые барьеры заложены в самой их концепции.

В 2010-х существовало два основных направления развития ИИ. Первое олицетворяет собой программа AlphaGo (от компании DeepMind, подразделение Google), которая в 2015-м впервые выиграла у чемпиона по игре в го. Принципиальная особенность системы в том, что она училась хитроумным комбинациям самостоятельно — соревнуясь сама с собой, а не с людьми. И это принесло успех.

Логотипы DeepSeek и ChatGPT

Однако в начале 2020-х возобладало другое направление — обучение нейросетей на человеческом материале. Появились большие языковые модели (LLM): машина усвоила, как устроен язык, и обработала огромное количество примеров его реального использования. В результате получились чаты, которые способны поддерживать полноценную беседу с человеком и составлять по запросу качественный текст на самые разные темы — от юриспруденции до медицины.

Теперь оказалось, что это было самое простое для ИИ. Несмотря на огромные вычислительные мощности и энергозатраты, требующиеся для генерации текста и картинок, ChatGPT так и не стал умнее домашней кошки — и, видимо, никогда не станет, объясняет Лекун в апрельском интервью Newsweek.

Не разум, а ловкие трюки

"У нас есть эти языковые системы, способные сдать экзамен на адвоката, умеющие решать уравнения, вычислять интегралы, но где наш домашний робот? — спрашивает Лекун. — Где робот, который так же хорош, как кошка в физическом мире? Задачи, посильные для кошки, не воспринимаются нами как умные, но на самом деле это так".

Он упоминает парадокс Моравека: ИИ легче научить навыкам более высокого порядка, например игре в шахматы или го, чем вроде бы базовым человеческим способностям, таким как перемещение в пространстве. Видимо, предполагают авторы концепции, за миллиарды лет эволюции наше умение ориентироваться и передвигаться стало автоматическим. Тогда как действия, которые требуют рассуждения, возникли гораздо позже и требуют более осознанных когнитивных усилий. У машин же все наоборот.

Другой минус больших языковых моделей отмечает робототехник и исследователь искусственного интеллекта Родни Брукс.

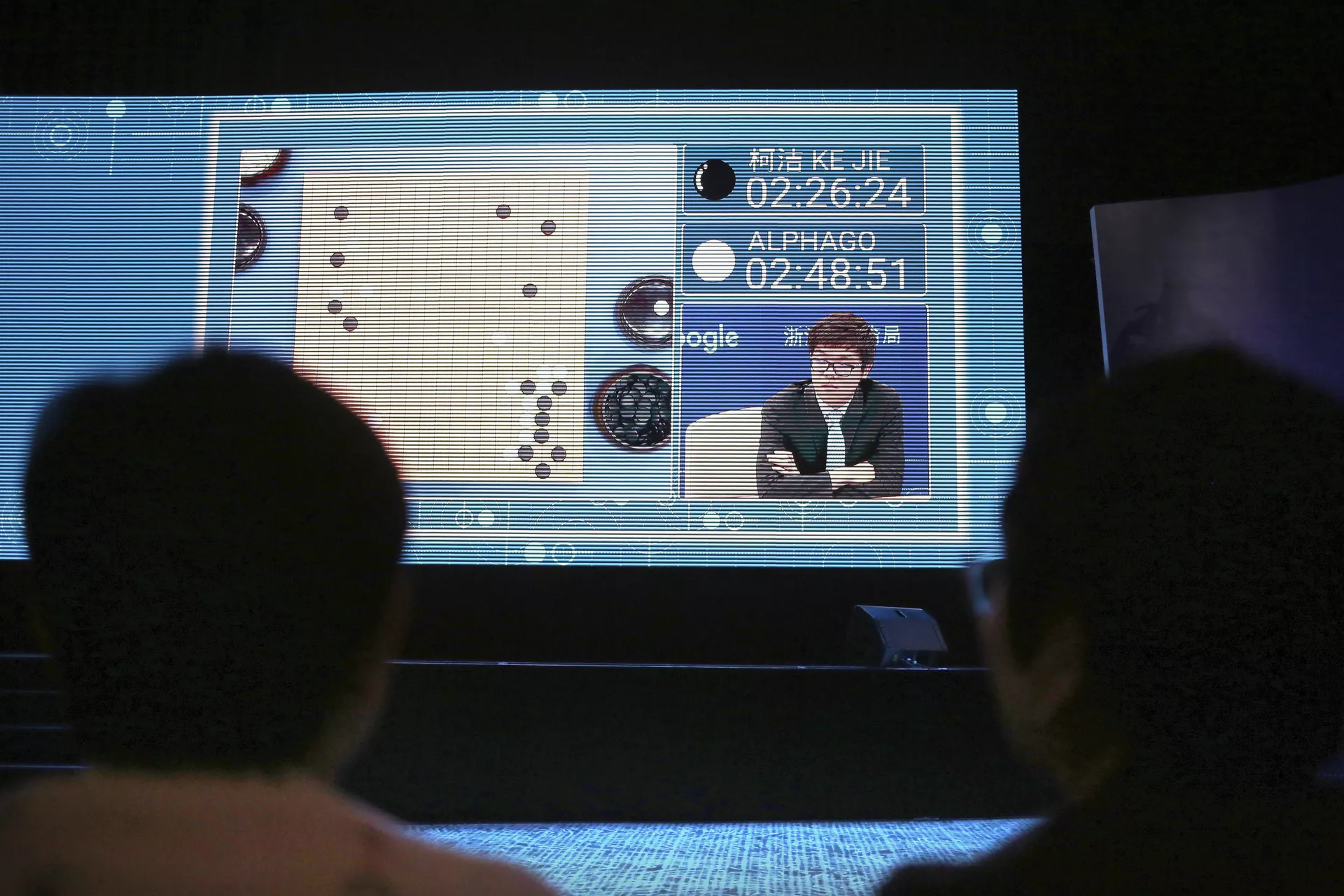

Зрители наблюдают за игрой Ke Jie против программы искусственного интеллекта AlphaGo во время саммита в Китае. 23 мая 2017

"LLM не знают, что является правдой, — говорит он. — Они лишь умеют складывать слова и прочитали все, что когда-либо было написано или оцифровано, поэтому способны на всевозможные трюки с языком".

Это одна из причин того, почему ChatGPT и аналоги порой “галлюционируют” — составляют складный текст, представляющий собой полную чушь.

Вопрос в том, как сделать, чтобы ИИ мог самостоятельно отделять правду от лжи и быть хотя бы не глупее кошки. Ведущие разработчики DeepMind Дэвид Сильвер и Ричард Саттон предлагают ответ в своей недавней статье.

Технология, о которой идет речь, "откроет беспрецедентные возможности", и это приведет к "будущему, кардинально отличающемуся от всего, что мы видели раньше".

"Могут нанести ущерб"

Следующее поколение нейросетей должно, подобно AlphaGo, учиться самостоятельно — получать опыт напрямую из физического мира, считают Сильвер и Саттон. Причем без каких-либо ограничений, будь то отдельная игра, человеческий язык или даже само человеческое сознание.

Современные инструменты, основанные на LLM, — это в основном короткие эпизоды взаимодействия. Пользователь задает вопрос — чат-бот отвечает. Из одного эпизода в другой информация практически не переносится. У новых же ИИ-агентов поток получения и освоения опыта должен быть непрерывным, как у людей и других животных. Это позволит исправлять ошибки и повышать свою эффективность.

Кроме того, такой ИИ сможет самостоятельно выбирать наиболее оптимальные действия для достижения целей — по своему разумению, а не на основе человеческих предпочтений, говорится в статье. Например, пользователь ставит перед агентом задачу “улучши мое здоровье” или “обучи меня новому языку” — и машинный разум перебирает способы, как это сделать, включая собственные.

Общая схема подхода, применявшегося при обучении ChatGPT

Важное условие обучения — система вознаграждений. ИИ должен каким-то образом понимать, правильны ли его действия. До сих пор это так или иначе определялось человеком-экспертом, а люди могли недооценить успешность стратегий, выбранных алгоритмом. Теперь наградой для ИИ могут стать не только оценки пользователя или специалиста, но и объективные показатели, взятые из реального мира. Скажем, при обучении языку — результаты экзамена, улучшении здоровья — снижение веса.

Еще одно важное отличие: если существующие системы немедленно отвечают на запросы человека, не задумываясь о последствиях, то ИИ будущего станет оценивать собственные решения — помогают они реализовать планы или наоборот.

“В каждом случае агент предпринимает последовательность шагов, направленных на максимизацию долгосрочного успеха. Отдельный шаг может не принести никакой немедленной пользы или даже нанести ущерб в краткосрочной перспективе, но, тем не менее, служит достижению главной цели”, — пишут разработчики DeepMind.

Многослойная нейросеть распознает лицо

Такой ИИ существует автономно, самостоятельно общаясь не только с людьми, но и с другими компьютерами, добавляют авторы статьи. Но здесь, по их собственному признанию, таятся основные риски технологии — и потеря рабочих мест не самый страшный.

Агенты, "автономно взаимодействующие с миром в течение длительных периодов времени для достижения долгосрочных целей", повышают вероятность того, что сократятся возможности человека "вмешиваться в их действия”, уточняют Сильвер и Саттон. То есть неясно, какой степени автономности подобная система способна достичь — равно как и то, что за методы для решения своих задач она выберет.

Здесь в полный рост встает вопрос о базовых ценностях, которые заложат в системы ИИ.

"Сентиментальная чушь"

В середине ХХ века писатель-фантаст российского происхождения Айзек Азимов сформулировал законы робототехники, запрещающие механизмам так или иначе вредить человеку. С тех пор многое изменилось: по мнению некоторых лидеров американских бигтех-корпораций, жизни людей и даже существование человечества больше не являются высшей ценностью.

Биограф инноваторов Уолтер Айзексон в одной из своих книг описывает разговор между предпринимателем Илоном Маском и сооснователем Google Ларри Пейджем (именно Google принадлежит DeepMind). Беседа состоялась в 2013-м на вечеринке по случаю дня рождения Илона.

Глава Tesla и SpaceX утверждал: если не предпринять вовремя необходимые меры, то господство ИИ приведет к исчезновению человечества — "одинокой свечи во Вселенной". Пейдж, по выражению Айзексона, счел это "сентиментальной чепухой" и обвинил Маска в "видизме" — ангажированности в пользу своего биологического вида: если сознание можно воссоздать в машине, почему не ценить его в той же мере? Это просто поднимет нас на новую ступень эволюции.

Кроме того, Маск обвиняет конкурентов из Google и OpenAI (компания-создатель ChatGPT) в том, что их ИИ подчинен леволиберальной идеологии так называемого вокеизма, суть которого передает аббревиатура DEI (diversity, equity and inclusion — разнообразие, равенство и инклюзивность). Эти ценности, считает Маск, для сторонников вокеизма важнее всего, в том числе даже человеческой жизни.

"Если ИИ запрограммирован на то, чтобы любой ценой добиваться разнообразия, то он сделает все возможное для достижения результата, потенциально даже убивая людей", — бьет тревогу Маск.

Другие эксперты не согласны: ограничения, которые физический мир накладывает на системы искусственного интеллекта, в обозримом будущем останутся достаточно существенными, чтобы машины не смогли стать для людей экзистенциальной угрозой. Однако и технооптимисты, и алармисты согласны в одном: под влиянием ИИ мир сильно и необратимо изменится — и это произойдет быстрее, чем нам кажется.

* Деятельность Meta (соцсети Facebook и Instagram) запрещена в России как экстремистская.

Источник: ria.ru