Бенчмарк MLPerf показал, что ускорители AMD Instinct не уступают NVIDIA H200

МЕНЮ

Главная страница

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Искусственный интеллект

Слежка за людьми

Угроза ИИ

ИИ теория

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Психология ИИ

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Промпты. Генеративные запросы

Распознавание лиц

Распознавание образов

Распознавание речи

Творчество ИИ

Техническое зрение

Чат-боты

Авторизация

2025-04-04 11:39

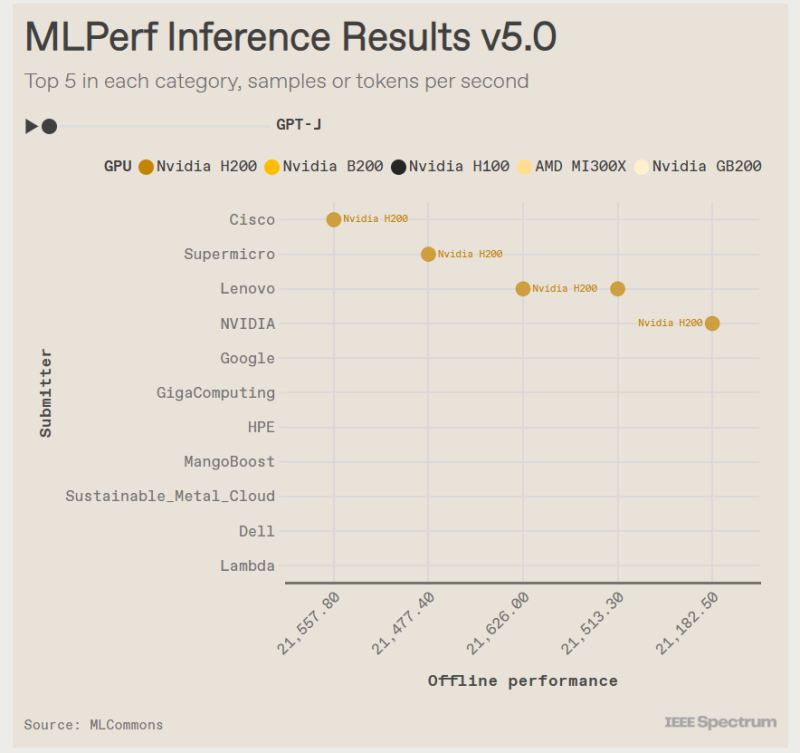

Консорциум MLCommons опубликовал результаты тестирования различных аппаратных решений в бенчмарке MLPerf для машинного обучения (МО), о чём сообщил ресурс IEEE Spectrum. Он отметил, что ускорители NVIDIA с архитектурой Blackwell превзошли все остальные чипы, но последняя версия ускорителей Instinct от AMD — Instinct MI325X — оказалась на уровне конкурирующего решения NVIDIA H200. Сопоставимые результаты были получены в основном в тестах одной из маломасштабных больших языковых моделей (LLM) — Llama2 70B. Чтобы лучше отражать особенности развития МО, консорциум добавил три новых теста MLPerf.

MLPerf запустил бенчмаркинг для систем МО, чтобы обеспечить сравнение компьютерных систем по принципу «яблоки с яблоками». Авторы используют собственное ПО и оборудование, но базовые нейронные сети должны быть одинаковыми. Сейчас существует 11 бенчмарков для серверов с учётом трёх добавленных в этом году.

Миро Ходак (Miro Hodak), сопредседатель MLPerf Inference, отметил, что отрасль ИИ развивается стремительными темпами, и чтобы соответствовать, им пришлось «ускорить темпы внедрения новых бенчмарков в эту область».

Добавлены два теста для LLM. Популярная и относительно компактная Llama2 70B уже является устоявшимся эталоном MLPerf, но консорциум решил включить тест, имитирующий скорость реагирования, ожидаемую пользователями от чат-ботов. Поэтому был добавлен новый эталон Llama2-70B Interactive, который ужесточает требования к оборудованию: компьютеры должны выдавать не менее 25 токенов в секунду при задержке на ответ не более 450 мс.

С учётом роста популярности «агентного ИИ» MLPerf решил добавить тестирование LLM с характеристиками, необходимыми для таких задач. В итоге была выбрана Llama3.1 405B. Эта модель имеет широкое контекстное окно — 128 000 токенов, что в 30 раз больше, чем у Llama2 70B.

Третий новый бенчмарк — RGAT — представляет собой графовую сеть внимания. Он классифицирует информацию в сети. Например, набор данных для тестирования RGAT состоит из научных статей, связанных между собой авторами, учреждениями и областями исследований, что составляет 2 Тбайта данных. RGAT должен классифицировать статьи по почти 3000 темам.

В этот раз поступили заявки на тестирование поступили от NVIDIA и 15 компаний-партнёров, включая Dell, Google и Supermicro. Оба ускорителя NVIDIA с архитектурой Hopper первого и второго поколения — H100 и H200 — показали хорошие результаты. «Мы смогли добавить ещё 60 % производительности за последний год, — у Hopper, которая была запущена в производство в 2022 году, сообщил Дэйв Сальватор (Dave Salvator), директор по ускоренным вычислительным продуктам в NVIDIA. — У неё всё ещё есть некоторый запас производительности». Тем не менее лидером оказался B200 с архитектурой Blackwell. «Единственное, что быстрее Hopper, — это Blackwell», — говорит Сальватор. B200 содержит на 36 % больше памяти HBM, чем у H200, но, что ещё важнее, он может выполнять ключевые математические операции МО, используя числа с точностью всего 4 бита вместо 8 бит у Hopper. Вычислительные блоки с более низкой точностью имеют меньше размеры, поэтому лучше размещаются на GPU, позволяя ускорить ИИ-вычисления.

В тесте Llama3.1 405B система от Supermicro с восемью B200 выдала почти в четыре раза больше токенов в секунду, чем система с восемью H200 от Cisco. И та же система Supermicro была в три раза быстрее самого быстрого компьютера на H200 в интерактивной версии Llama2 70B.

NVIDIA использовала суперчип GB200 — сочетание ускорителей Blackwell и процессоров Grace — чтобы продемонстрировать, как её каналы передачи данных NVL72 могут интегрировать несколько серверов в стойку, работая как один гигантский графический процессор. В непроверенном результате, которым компания поделилась с журналистами, полная стойка компьютеров на базе GB200 NVL72 выдавала 869 200 токенов в секунду в Llama2 70B. Самая быстрая система текущего раунда MLPerf — сервер NVIDIA B200 — показала 98 443 токена в секунду.

Ускоритель Instinct MI325X позиционируется AMD как конкурент H200. Он имеет ту же архитектуру, что и предшественник MI300, но оснащён увеличенным объёмом памяти HBM и более высокой пропускной способностью — 256 Гбайт и 6 Тбайт/с (рост на 33 % и 13 % соответственно). AMD оптимизировала ПО, что позволило увеличить скорость инференса DeepSeek-R1 в 8 раз.

В тесте Llama2 70B компьютеры с восемью MI325X отставали от аналогичных систем на базе H200 всего на 3–7 %. В задачах генерации изображений система MI325X показала результат в пределах 10 % от системы на H200.

Также сообщается, что партнёр AMD, компания Mangoboost, продемонстрировала почти четырёхкратное увеличение производительности в тесте Llama2 70B, запустив вычисления на четырёх компьютерах.

Intel традиционно использует в тестах только процессорные системы, чтобы показать, что для некоторых рабочих нагрузок GPU не требуются. В этот раз были представлены первые данные по чипам Intel Xeon 6 (ранее Granite Rapids), выпускаемым по 3-нм техпроцессу Intel. Компьютер с двумя Xeon 6 показал 40 285 образцов в секунду, что составляет около одной трети производительности системы Cisco с двумя NVIDIA H100.

По сравнению с результатами Xeon 5 в октябре 2024 года новый процессор демонстрирует прирост в 80 % в данном тесте и ещё большее ускорение в задачах обнаружения объектов и медицинской визуализации. С 2021 года, когда Intel начала представлять результаты Xeon (с Xeon 3), её процессоры достигли 11-кратного прироста производительности в тесте ResNet.

Intel отказалась от участия в категории ускорителей: её конкурент для H100 — Gaudi 3 — не появился ни в текущих результатах MLPerf, ни в версии 4.1, выпущенной в октябре 2024 года.

Чип Google TPU v6e также продемонстрировал свои возможности, хотя результаты были ограничены задачей генерации изображений. При 5,48 запроса в секунду система с четырьмя TPU показала прирост в 2,5 раза по сравнению с аналогичным компьютером, использующим TPU v5e, в результатах за октябрь 2024 года. Тем не менее 5,48 запроса в секунду — это примерно те же показатели, что и у аналогичного по размеру компьютера Lenovo с NVIDIA H100.

Источник: servernews.ru