NVIDIA выпустила собственную ИИ-модель NVLM 1.0

МЕНЮ

Главная страница

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Искусственный интеллект

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Психология ИИ

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Творчество ИИ

Техническое зрение

Чат-боты

Авторизация

2024-09-23 11:10

Компания NVIDIA выпустила собственную мультимодальную большую языковую модель NVLM 1.0 (NVIDIA Vision Language Model). Новая нейросеть содержит в себе до 72 миллиардов параметров. Разработчик выпустил ИИ-модель в трёх версиях:

- NVLM-D (Decoder-Only Model) — использует предобученный энкодер для генерации картинок и более экономна относительно количества параметров;

- NVLM-X (X-attention Model) — оптимизирована для работы с изображениями в высоком разрешении;

- NVLM-H (Hybrid Model) — гибридная модель, которая сочетает в себе черты двух предыдущих моделей.

Лучше, чем GPT-4o

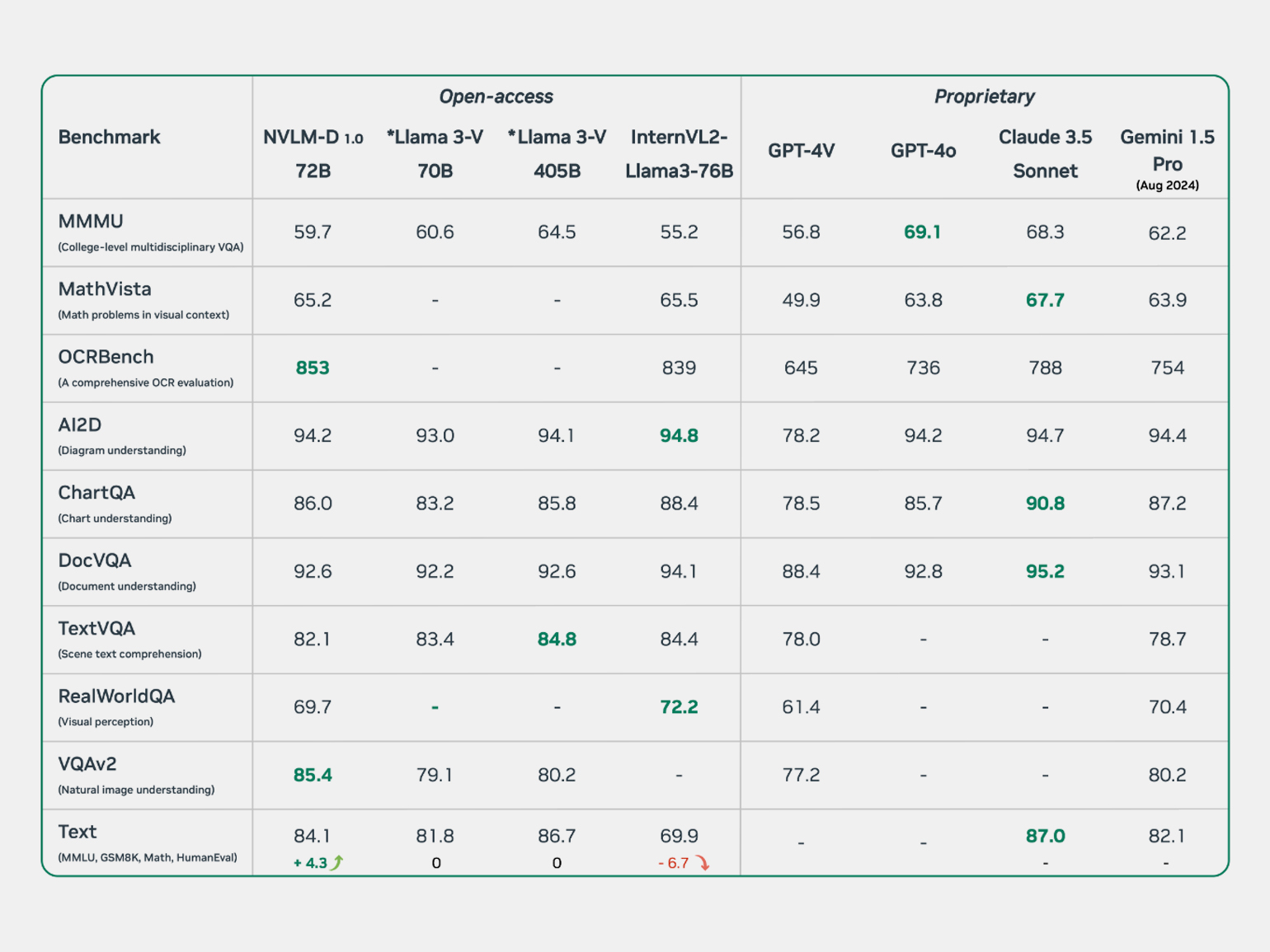

NVLM 1.0 очень хорошо показывает себя в визуальных задачах. Это продемонстрировал тест OCRBench, который проверяет способность модели считывать текст с картинки. Так, в ходе бенчмарка модель NVLM-D обогнала GPT?4o — последнюю на сегодняшний день мультимодальную модель от OpenAI.

Стоит также отметить, что нейросеть от NVIDIA способна понимать мемы, разбирать человеческий почерк, а ещё она хорошо отвечает на вопросы, связанные с точным расположением объектов на картинке.

Кроме того, NVLM 1.0 хорошо показывает себя и в математических задачах. Так, бенчмарк MathVista показал, что ИИ-модель от NVIDIA опережает нейросеть Gemini 1.5 Pro от Google и всего на пару пунктов отстаёт от модели Claude 3.5 от стартапа Anthropic.

Читайте также:

OpenAI выпустила превью ИИ?модели o1

Различия между версиями

Все три версии модели NVLM 1.0 имеют схожую архитектуру, но у каждой из них есть свои особенности, в частности это касается механизма обработки изображений. Так, модель NVLM?D использует для картинок предобученный энкодер, который соединён с обычным двухслойным перцептроном. Версия NVLM?Х для обработки изображений использует механизм cross-attention.

У каждого из этих механизмов обработки есть свои недостатки и преимущества. Например, NVLM-D использует меньшее количество параметров, однако потребляет больше ресурсов графического процессора и хуже, чем NVLM?X, обрабатывает картинки с высоким разрешением. В свою очередь версия модели NVLM?H стала золотой серединой между эффективной и быстрой NVLM?D и более точной NVLM?Х.

Модель NVLM 1.0 можно скачать на GitHub, данные о весовых коэффициентах каждой из версий ИИ?модели будут в скором времени доступны на Hugging Face.

Читайте также:

- Meta* выпустила ИИ-модель Llama 3.1 с 405 миллиардами параметров

- Сэм Альтман обозначил ключевые меры для развития ИИ

- NVIDIA стала самой дорогой компанией в мире

* Решением суда запрещена «деятельность компании Meta Platforms Inc. по реализации продуктов — социальных сетей Facebook и Instagram на территории Российской Федерации по основаниям осуществления экстремистской деятельности».

Перцептрон — математическая или компьютерная модель восприятия информации мозгом, предложенная Фрэнком Розенблаттом в 1957 году и впервые воплощённая в виде электронной машины «Марк-1» в 1960 году. Перцептрон стал одной из первых ИИ-моделей в мире.

Источник: skillbox.ru