Информация

МЕНЮ

Главная страница

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Искусственный интеллект

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Психология ИИ

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Творчество ИИ

Техническое зрение

Чат-боты

Авторизация

2024-08-20 14:38

Title: The Information

Abstract: In this work, based on the analysis of speech models, the basic properties of information are determined, which are subsequently extended to the construction of a theory of Information. The Information model itself can be applied not only to the humanities, but also to the natural sciences.

One Sentence Summary: A New Approach to the Concept of Information

Слово «информация» используется для обозначения множества вещей и эта одновременная нечеткость и многозначность служит источником путаницы, как в обычной речи, так и в науке. Однако информации, как несомненно важному явлению нашего мира, в науке отведено место на затворках. Попытаемся понять как информация проявляется в физическом мире, как и в какой мере она подчиняется “материальным” законам нашего мира, как участвует во всевозможных взаимодействиях, как трансформируется и какие принимает формы.

Но для начала рассмотрим энергию. Удивительно, но термин энергия, не смотря на его повсеместное использование, определен в естествознании весьма условно, а именно, через свои свойства, например: энергия это мера движения. Или энергия это мера силы перехода движения материи из одних форм в другие для приведения её в состояние покоя. Достаточно сложно и не понятно Сложности с базовыми определениями элементарных единиц в любой научной повсеместны и это больше философская и гносеологическая проблема. Например, в основаниях математики наблюдается схожая картина, достаточно вспомнить пятый постулат Евклида.

С информацией, как и с энергией, прослеживается сходная ситуация, поэтому будем определять Информацию (с прописной буквы) опираясь на ее свойства.

Попытаемся сформировать понимание термина Информация используя лингвистику. Буквы, передают добавочную Информацию, нежели набор кривых и прямых линий их изображающих. Слова передают добавочную Информацию, нежели Информация от суммы входящих в них букв. Слова в предложении не передают всего того объема Информации, который передает все предложение и наоборот предложение передает более значительные объемы Информации, нежели Информация от всех слов в отдельности. Абзац как Сложное Синтаксическое Целое передает гораздо больше Информации, нежели составляющие его предложения в отдельности, и дело не столько в количестве предложений, важно их сочетание, композиция, порядок. И сам текст, и контекст, и подтекст, выступают как потоки Информации и взаимодействуют между собой.

Мы видим, что Информация имеем тенденцию «увеличиваться» взаимодействуя с Информацией более «низкого» уровня – буква-слово-предложение-текст, проявляя одно из своих свойств: емкость, сложность и насыщенность Информации повышается с уровнем ее структуризации. В этом плане Информация выступает как сложная динамическая структура со своим набором взаимодействующих систем.

Для выяснения других законов и свойств Информации снова вернемся языку. Безусловно, язык это инструмент коммуникации, он как ничто другое приспособлен для манипуляций с Информацией и лингвистический анализ демонстрирует основные свойства Информации в целом. Одно из свойств – это непрерывность потока Информации. Текст, как «носитель» Информации, укладывается в понятие непрерывного потока и обладает типичными свойствами потока. Если в потоке воды непрерывность обеспечивается соответствующими триплетами и синглетами (определенные пространственные формы молекул, цепляющиеся друг за друга), то в лингвистике существуют свои механизмы для обеспечения непрерывности текста на различных уровнях. Например, в знаменитом стихотворении «Дом, который построил Джек» непрерывность потока поддерживается с помощью цепочной конструкции.

Вот дом,

Который построил Джек.

А это пшеница,

Которая в тёмном чулане хранится

В доме,

Который построил Джек.

А это весёлая птица-синица,

Которая часто ворует пшеницу,

Которая в тёмном чулане хранится

В доме,

Который построил Джек…

Свойство непрерывности потока Информации позволяет ей быть в активном состоянии. В таком состоянии она появляется когда мы размышляем, слушаем речь, используем зрение или другие органы чувств.

Что бы понять смысл понятия непрерывности потока Информации можно воспользоваться аналогией с вычислением. Пока что то вычисляется это «непрерывный» процесс, как только акт вычисления закончен и получен результат процесс останавливается.

Информация имеет некоторое сходство с энергией, она характеризуется непрерывной фазой в своем активном состоянии, так же как и кинетическая энергия, и способностью «пребывать» в неактивной фазе (сохраняться) как и потенциальная энергия. Но в отличии от Закона сохранения энергии, Информация может рождаться, деградировать и теряться.

Способность Информации сохраняться подразумевает наличие носителей и определяет новые ключевые термины необходимые для ее существования: Память и Наблюдатель. Память это носитель, хранящий программу - набор инструкций, указаний, корреляций с помощью которых Информация может быть воспроизведена.

Примерами носителей Информации могут служить книги, произведения искусств (картины, музыка, скульптуры), флешки, электромагнитные излучения, поля и вообще любые объекты.

Наблюдатель один из ключевых аспектов функционирования информации. Наблюдатель, используя носители, считывает программу и с ее помощью воспроизводит ( создает ) Информацию, переводя ее в активное состояние взаимодействует с ней и сохраняет на носителях. Наблюдателями могут быть любые системы нашего мира, участвующие во взаимодействиях.

Информация может быть сохранена путем копирования в виде данных на носители. Предлагается считать разными понятиями Информацию и ее образы, хранимые на носителях. К примеру, мы отождествляем кинетическую и потенциальная энергию как две формы, они переходят одна в другую и равноправно участвуют в законах сохранения, однако точное восстановление Информации по ее образу на носителе не всегда возможно и это говорит о неэквивалентности этих понятий - «Мысль изреченная есть ложь». В мире науки на этот счет существуют специальные теоремы о невозможности «полного» клонирования.

Приведем некоторые пояснительные примеры. Допустим, в ящике вашего шкафа хранятся носки. Если вы вытащили из шкафа правый носок, то он фактически может передать Вам данные о своем левом партнере, который остался в ящике. На вашем правом носке не написано, что в ящике остался левый носок, но тем не менее, Вы как наблюдатель с его свойствами , с помощью данных полученных по зрительному каналу, используя корреляции, переведете Информацию в активную форму, заставите ее взаимодействовать с активной Информацией вашей нейронной сети, создадите релевантную Информацию и произведете предсказание о левом носке в ящике.

Термин «корреляция» можно условно понимать как «код» или соответствие с помощью которого можно восстанавливать Информацию о различных взаимодействиях. Термин корреляция связан с опорными множествами, позволяющими генерировать Информацию. Под релевантной Информацией понимается Информация:

1. которую мы получили о данной системе в ходе прошлых взаимодействий

2. позволяющая предсказывать, что мы получим в результате будущих взаимодействий с этой системой.

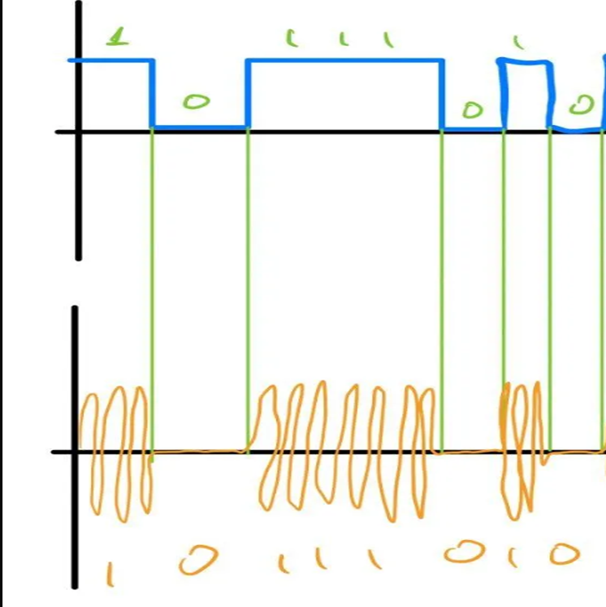

На рисунке ниже приведен пример передачи данных о символе и генерация Информации из модулированной электромагнитной волны .

Учитывая опорные множества ( положительные меандры опорной волны и коды букв ASCII) получим символ “] “.

В живой природе Информация рождается в результате функционирования нейронных сетей, в окружающем нас физическом мире она появляется в ходе различных взаимодействий систем, энергий или полей. Например, наука считает, что все в нашем мире это взаимодействия ковариантных квантовых полей.

Еще одной особенностью Информации является ее избыточность. Избыточность дополнительно обеспечивает непрерывность потока Информации. Например, любой текст избыточен. Если вы примените архиватор к любому тексту, то получите файл ужатый на 70-90%. Обратное разархивирование 100% восстанавливает исходный текст, что доказывает избыточность. Избыточность языка это явные статистические закономерности в появлении букв, пар последовательных букв, троек и т. д. ( цепи Маркова). С другой стороны, избыточность является проявлением энтропии данного текста. Энтропия в данном случае это размытость, неопределенность, повторяемость, и белый шум в Информации.

Резюмируя : Информация сохраняется как Память о взаимодействиях на материальных или энергетических носителях. Информация появляется в ходе различных взаимодействий. Информация в активном состоянии существует только в непрерывном потоке. Информация обладает свойствами избыточности и многослойной структурированности. Выходя из потока или при исчезновении потока Информация теряется. Информация содержит энтропию. Информация предается ( распространяется, движется) путем копирования. Это главный способ перемещения Информации в физическом мире.

Рассмотрим более подробно «движение» Информации, опять же на примере лингвистики. Возьмем слово «человек». Есть ли в этом слове информация. На первый взгляд ответ да кажется очевидным. Ведь читая это слово, мы получаем «достоверную» Информацию. Но как мы ее получаем? Слово представляется набором символов, а еще точнее кусочками кривых линии. В них есть закономерности, формы, порядок – то есть набор определенных корреляций, по-другому кодов. Человек считывает слово, это последовательная передача различных корреляций через разных Наблюдателей и последовательное сохранение различной Информации на соответствующих носителях. Очень приближенно последовательность носителей следующая: слово на бумаге? отраженная от бумаги световая волна с кодами в виде модуляций определенной частоты ? сетчатка ? глазное дно ? колбочки ? нервные окончание ? клетки мозга ? нейронная сеть головного мозга. В процессе движения "слова человек" каждый Наблюдатель по своему восстанавливает (рождает) Информацию от взаимных корреляций с предыдущим Наблюдателем, и записывает ее «своими словами» то есть своим кодом. И лишь на последнем этапе в нас (а мы тоже Наблюдатели) Информация создается в виде мыслеформы -человек.

Так была ли Информация в слове «человек»? Безусловно, что слово «человек» написал некий Наблюдатель и он имел намерение передать этим словом информацию о человеке. Он написал код с помощью букв, то есть корреляцию (программу), с помощью которой можно «восстановить» Информацию. И написанное – это набор инструкций.

Так почему же слово это инструкции, почему написанное слово не сама Информация

Допустим на песке ветер случайно намел слово men…и что ? Внезапно ниоткуда появилась Информация? Ветер положил эту Информацию? А он откуда то знает про человека?? Или написано закодированное азбукой Морзе слово "человек". От человека там нет ничего, но Наблюдатель зная азбуку с легкостью восстановит Информацию о человеке.

Информация существует только в непрерывном потоке Наблюдателя, поэтому на носителях может существовать лишь образ Информации в виде различных корреляций. В связи с вышеизложенным, можно заключить о существовании только опосредованной связи между активной Информацией и Памятью на носителях.

В целом же можно сказать, что информация это описание взаимодействий между системами.

( Мы привыкли использовать слово информация. Это собирательный образ, он расплывчатый, он многозначен, он строго не определен. Но именно поэтому его удобно использовать, в разных случаях наделяя разным смыслом. Отождествлять слово информация с введенным понятием Информация вряд ли целесообразно. Но иногда смысл этих терминов пересекается и даже совпадает )

Научное понятие информации и информационной модели впервые было введено Клодом Шенноном. Испытывая затруднения с точным определением информации, Шеннон ввел понятие энтропии и определял информацию как убывание энтропии.

В его определении, информация как величина обратная энтропии (стоит знак минус) была сужена до набора альтернатив N и определялась формулой:

Где I – количество информации (которое в среднем приходится на одну альтернативу), а Pi вероятности появления соответствующей альтернативы. Основание два у логарифма выбирается как минимальное число альтернатив, то есть выбор между двумя возможностями, что определяет бит информации. В случае равноправности альтернатив формула приобретает вид

То есть информация по Шеннону, это двоичная энтропия, взятая с обратным знаком. Выше было показано, как энтропия связана со свойством избыточности, поэтому пользоваться формулами Шеннона при взаимодействии сложных систем не представляется возможным. Во Вселенной энтропия изменяется не по логарифмическому, а по экспоненциальному закону,

что так же не укладывается в теорию Шеннона.

Не смотря на однобокость и узкую направленность теории Шеннона, опирающуюся на передачу сигналов по линиям связи, некоторые идеи были успешно воплощены Фон Нейманом в первой архитектуре компьютеров. Для решения задач он смог «восстановить» активное состояние Информации, создав непрерывный поток и функционирование активной Информации, с помощью набора команд (программы) в парадигме основного алгоритма и двумя операторами «if» и «go to», фактически создав одноконтурный аналог нейронной сети. :

1. Взятие команды по адресу из счетчика команд CK=1;

2. Увеличение счетчика команд для перехода к следующей команде CK=CK+4; (5)

3. Исполнение команды complete;

4. Переход по счетчику команд go to 5;

5 ...

n. Stop

шаги 1 ... n обеспечивают непрерывный поток.

Рассматривая ограниченность понятия информации по Шеннону (устранение энтропии как путь ведет к лучшему "пониманию " и накапливанию информации) важно заметить детерминированность этого подхода. А именно, имеется конечный, определенный набор альтернатив и оценивая альтернативы (как да или нет) уточняется и "возрастает" информация.

Не вызывает никакого удивления квантовость нашей реальности. В научном мире давно ведутся исследования серьезно подтверждающие квантовость нашего мышления. (Понятие квантового мышления впервые использовал эксперт в области криптографии и компьютерный ученый Ник Сабо , отсылаем интересующимся этими вопросами к его работам). Квантовое мышление это способность видеть проблему со всех сторон, одновременно соглашаться и не соглашаться с аргументами, держаться в мире вероятностей, а не нулей и единиц (упомянутые выше как да и нет). Квантовое мышление помогает избежать категоричности, туннельного зрения и принятия решений, основанных на когнитивных искажениях .

Физик Роджер Пенроуз предположил, что активность происходящих в мозге процессов является квантовой, и выдвинул гипотезу: квантовая наука наглядно демонстрирует, что такое человеческое сознание. Он объясняет эту концепцию в книге «Новый ум короля». Профессор Дирк Мейер поддерживает его гипотезы, утверждая, что сознание ведет себя как квантовая частица.

Убеждения, а впоследствии и решения людей зачастую иррациональны. Бывает, что они не вписываются ни в какую логику. Тогда как квантовый уровень поведение человека может предсказать точнее. Так, китайские ученые в одном из исследований установили, что логические ошибки, которые допускают люди в процессе мышления, возможно описать с помощью формул квантовой теории вероятностей. А другое открытие демонстрирует, что математический аппарат квантовой неопределенности помогает объяснить непредсказуемость в человеческом поведении.

Косвенным доказательством квантового мышления, то есть квантовость в функционирующей нейросети в мозгу, служат микротрубочки — белковые внутриклеточные структуры, входящие в состав цитоскелета. Микротрубочки представляют собой полые цилиндры и обусловливают форму и движение клетки, а также ее деление. В парадигме нашей теории об Информации микротрубочки с их симметрией и решетчатым строением — это Носитель квантового сознания.

Согласно теории оркестрованной объектной редукции (Orch-OR) Хамероффа — Пенроуза, микротрубочки обусловливают сознание благодаря своей способности хранить и обрабатывать Информацию и воспоминания.

Итак, свойство квантовости присуще введенной нами Информации и тем самым присуще явлениям реальности, в той или иной мере работающих в парадигме описанной нами Информации.

Законы квантового мира не детерминированы и используют квантовую Информацию. Современное представление в физике ( David Deutsch, Chiara Marletto - Constructor theory of information) это попытка постулировать квантовую информацию в терминах возможности или не возможности преобразований физических систем на фундаменте теории множеств (что созвучно с идеями Шеннона и Больцмана). Авторы используют сходные идеи о корреляции и наблюдателе (Трансформеры и Агенты ) и Вычисление - для обеспечения непрерывного потока Информации.

Информация может существенно изменять поведение различных систем, в той или иной мере меняя привычные законы их взаимодействий. Программа, записанная на контролерах, может управлять поведением космических объектов или роботов. Нейросеть человека, работая с Информацией, создает новые знания, способные кардинальным образом изменить окружающий нас мир.

Не подлежит сомнению, что в будущем произойдет передача всей накопленной человечеством информации в глобальную систему Искусственного Интеллекта, который будет в состоянии манипулировать и преобразовывать эту информацию.

Резюмируя вышесказанное, можно сделать следующие выводы:

- В физическом мире между взаимодействующими системами существует информационная связь в виде корреляций, которые опосредованно создают релевантную информацию.

- Релевантная информация конечна.

- Движение информации происходит в кодированном виде с помощью копирования.

Возвращаясь к физическому миру, можно заметить, что при взаимодействии любых систем в них рождается Информация. В конечном итоге именно эта Информация определяет порядок, функционирование и вообще все законы нашей Вселенной. Информация по своей сути и свойствам «несовершенна», она обладает избыточностью, ее составной частью является энтропия. Поэтому и законы нашего мира не совсем совершенны, и в результате любых взаимодействий рождается энтропия.

С другой стороны, энтропия, хотя и в неполном и своеобразном виде несет информацию о всех взаимодействиях и является Памятью Вселенной.

Литература

-

David Deutsch, Chiara Marletto - Constructor theory of information,

Published:08 February 2015 , https://doi.org/10.1098/rspa.2014.0540 -

А.Ю.Богданов,Ю.И.Богданов, К.А. Валиев, ИНФОРМАЦИЯ ШМИДТА И ЗАПУТАННОСТЬ КВАНТОВЫХ СИСТЕМ, ВЕСТН.МОСК. УН-ТА. СЕР. 15. ВЫЧИСЛ.МАТЕМ.И КИБЕРН. 2007. №1

-

А.Д. Урсул, Природа информации, 2-е изд. Челяб. гос. акад. культуры и искусств, 2010. – 231 с.

Источник: habr.com