Обзор RLHF: как научиться PPO, обрисовать влияние RLHF, ретроспектива RewardBench и конкурс моделей вознаграждений

МЕНЮ

Главная страница

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Искусственный интеллект

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Психология ИИ

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Творчество ИИ

Техническое зрение

Чат-боты

Авторизация

2024-07-13 14:33

Открытое пространство выравнивания в основном продвигается рывками. Последний крупный прорыв произошел прошлой осенью с группой моделей, обученных с помощью прямой оптимизации предпочтений (DPO) . С тех пор ситуация кардинально не изменилась — создаются новые базы кода, выпущено (несколько) новых наборов данных, а статьи продолжают поступать, но состояние дел в целом остается прежним. Все говорят об использовании вариантов «онлайн-DPO», но это не воплотилось в существенно лучшие модели.

Недавно я выступил с докладом об этом состоянии игры под названием « Жизнь после ДПО », в котором подробно описал, какую работу необходимо провести, чтобы этот темп прогресса ощущался быстрее. В любой новой академической области ожидается, что прогресс будет горизонтальным и экспансивным, а не направленным вперед, потому что все больше людей присоединяются и вносят свой первый вклад в эту область. Это ожидаемо.

Менее ожидаемо то, что некоторые видные друзья, которые у меня есть в этой области, в основном считают, что «все инструменты с открытым исходным кодом» для масштабного RLHF в значительной степени не работают. Инженерный стек, который мы, люди, обучающие открытым моделям, используем, чрезвычайно непостоянен и не связан с методами, которые использует промышленность.

Один из самых популярных инструментов (который я немного помогал создавать, работая в HuggingFace), TRL, теперь имеет 7 различных функций потерь только для тренера DPO , и их будет еще больше. Разница между вариантами алгоритмов обычно меньше, чем разница между популярными наборами данных, используемыми для выравнивания. Это был один из промежуточных выводов нашей недавней статьи « Распаковка DPO и PPO: распутывание лучших практик обучения на основе обратной связи о предпочтениях» .

Цель статьи — попытаться выяснить, сможем ли мы заставить проксимальную оптимизацию политики (PPO) работать более или менее «так, как говорит отрасль». Многие неофициальные разговоры показали мне, что PPO может превзойти DPO «в среднем более чем на 5%». Что не учитывается во всех этих ярких разговорах, так это то, с каким пакетом оценок проводятся сравнения, поэтому мы хотели убедиться, что не удерживаем себя от прилипания к DPO. После нескольких коротких недель аспирантуры1, у нас была работающая реализация PPO в Jax и машины, чтобы разобраться в сути вещей.

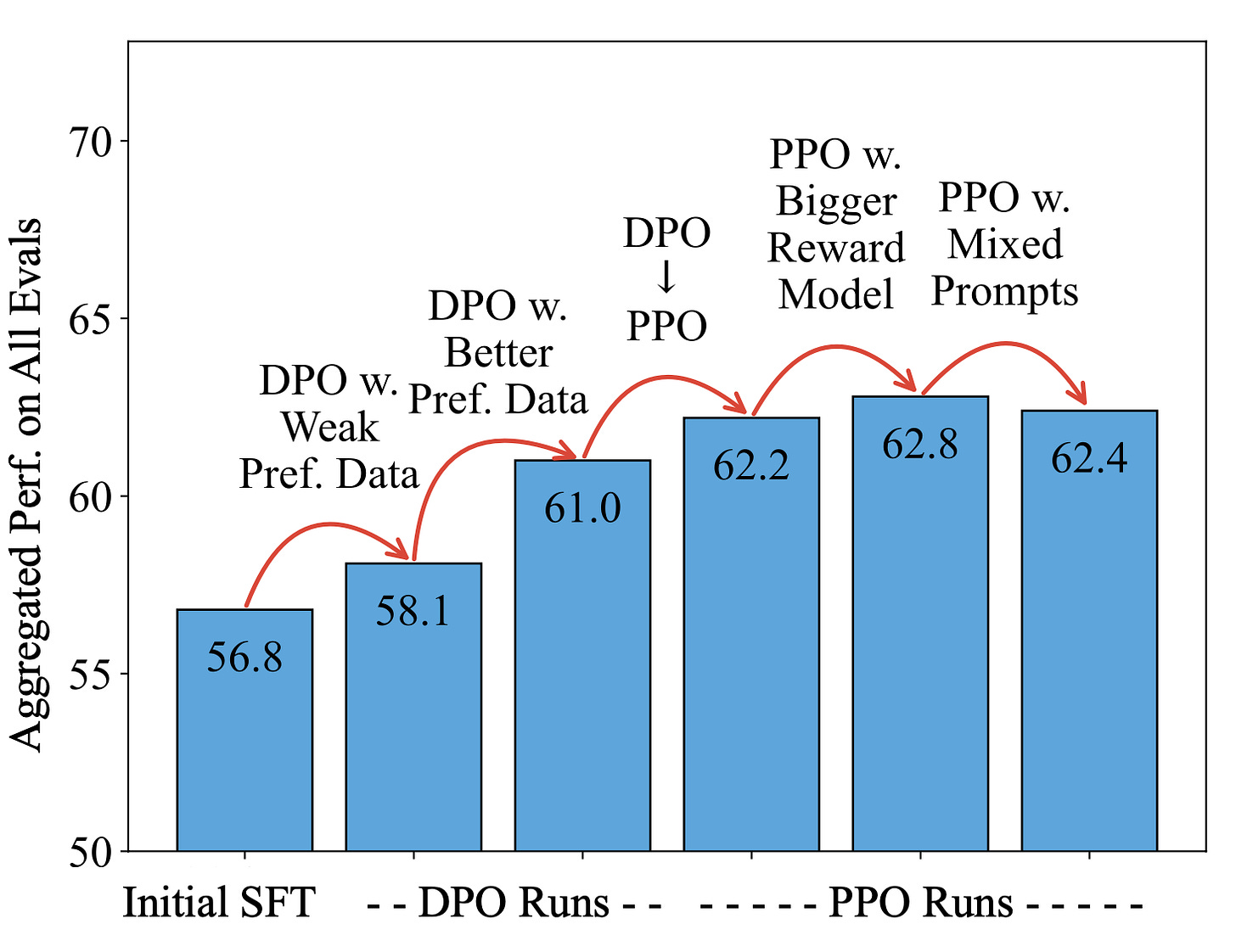

Сноска: Краткое изложение статьи о Llama 2 13B приведено ниже с помощью пакета open-instruction . Во-первых, мы показываем базовую производительность DPO по сравнению с вариантом, настроенным на инструкции, с более шумным набором данных, в данном случае классическими антропными полезными и безвредными данными , плюс балл 1,3. В основном это для сравнения с «лучшими» данными, которыми в данном случае является набор данных UltraFeedback, который я обсуждал на прошлой неделе в своем посте о синтетических данных , плюс оценка 2,9. Затем мы сохранили данные и перешли на новую реализацию PPO с оценкой 1,2. После этого мы не смогли надежно добиться большей производительности от двух идей, которые неоднократно слышали:

Используйте более крупную модель вознаграждения, чтобы внести в политику более глубокие знания — в данном случае модель вознаграждения с 70B параметрами и политикой 13B. Это увеличило некоторые показатели, но не повысило другие, и ненадежно.

Добавление дополнительных подсказок к рассуждению для улучшения задач рассуждения, учитывая все обсуждение RLHF и связанных с ним методов, помогающих с кодом и рассуждениями.

Эти модели PPO, несмотря на высокие оценки по контролируемой длине AlpacaEval, по-прежнему чрезвычайно вялые и немного расстроенные, как модели предыдущих поколений. Они являются отличным примером того, почему нельзя слепо доверять оценкам AlpacaEval.

Эти общие оценочные цифры выглядят довольно скудными, если сравнивать их с моделями Llama 3, для которых мы также включили контрольные точки, обученные DPO. Некоторые ранние опыты перехода PPO на другие базовые модели, что неудивительно, заключаются в том, что мы не добились такого же успеха, как с базовыми моделями Llama 2. Эти модели, особенно с параметрами 70B, все еще значительно ниже модели Llama-3-Instruct от Meta. Некоторые статьи начали показывать превосходство Llama-3-Instruct по шкале 8B (и не только по игровым тестам, таким как AlpacaEval), но я подозреваю, что все еще существует надежный способ достичь шкалы 70B с состоянием распределенной точной настройки. библиотеки.

Это первые достойные модели, выпущенные за долгое время (возможно, начиная с Stable Vicuna в апреле прошлого года), которые были обучены с помощью PPO и находятся на уровне современных технологий. Если мы серьезно настроены на создание более совершенных открытых моделей, необходимо продолжать углубляться в меньшем количестве алгоритмов и наборов данных . Работа с наборами данных будет заключаться в том, как лучшие ученые и участники открытого исходного кода выделяются из шума.

Llama-3-Instruct 70B — хорошая цель для лабораторий открытой настройки, чтобы они могли надежно победить, поскольку он был проверен на ChatBotArena, Meta.ai и многих других тестах. Единственная причина, по которой я с оптимизмом смотрю на то, чтобы наверстать упущенное, заключается в том, что мы можем с большей готовностью использовать синтетические данные без угрозы серьезных судебных разбирательств со стороны OpenAI или другого поставщика передовых моделей . Для получения дополнительной информации об этих моделях или методах вы можете получить доступ к набору моделей Tulu 2.5 (база Llama 2), начальным моделям Tulu Llama 3 или коду PPO для статьи .

Interconnects — это издание, поддерживаемое читателями. Подумайте о том, чтобы стать подписчиком.

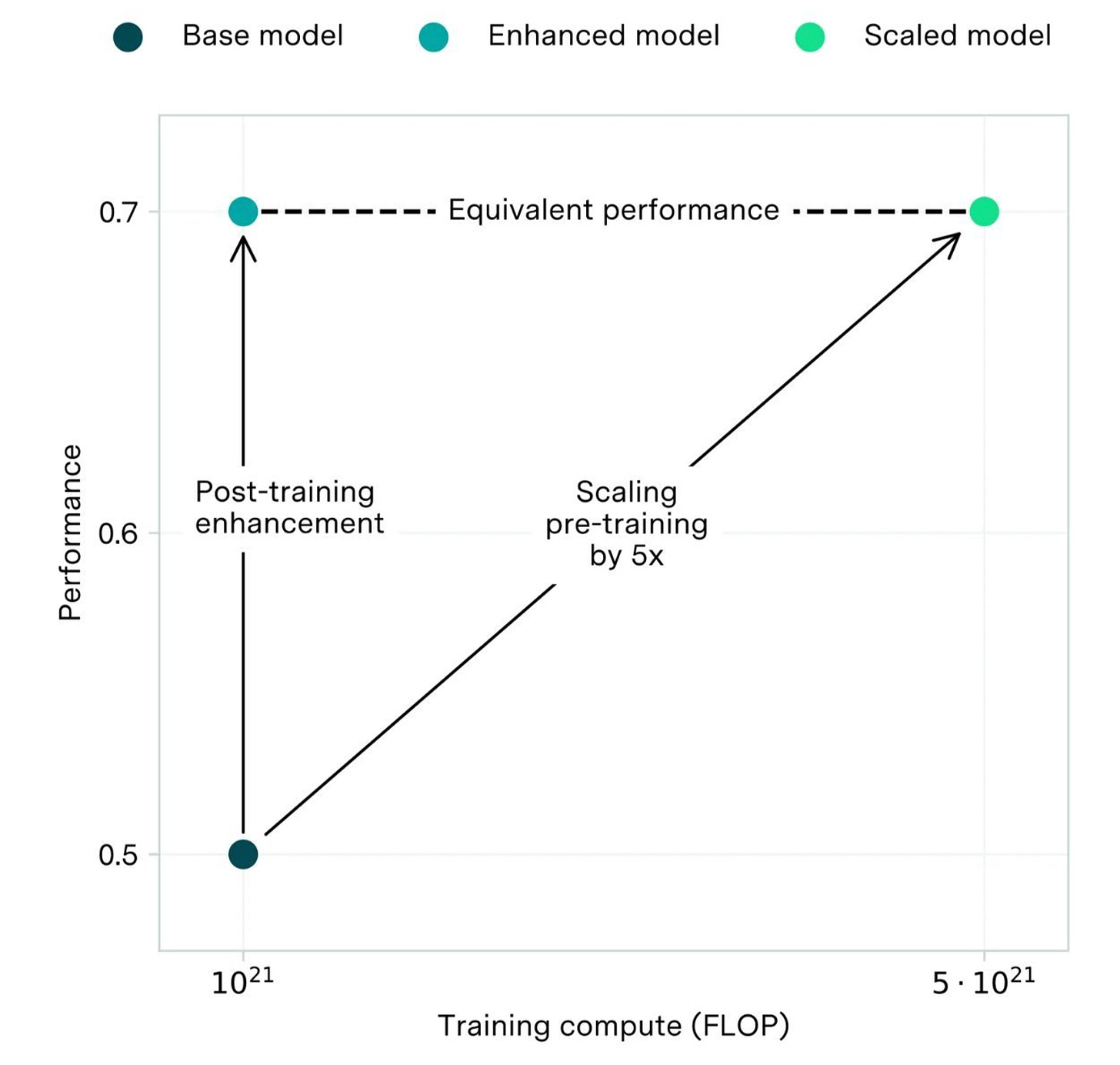

Насколько велико влияние RLHF по сравнению с предварительной тренировкой?

Вот интересный график от Epoch AI , который пытается проиллюстрировать, насколько улучшены методы постобучения по сравнению с масштабированием, где основным инструментом является обучение с подкреплением на основе обратной связи с человеком (RLHF). График довольно элементарный, с оценками изменения шкалы предварительного обучения между поколениями и агрегированными оценками по оси Y. Он утверждает, что RLHF может создать что-то вроде недавней модели GPT 3.5, которая будет примерно эквивалентна исходной GPT-4, которая была обучена в основном в 2022 году. С такими измерениями, как ChatBotArena , тот факт, что они иллюстрируют, не соответствует действительности, но история все еще держится.

Большой успех в передовых моделях достигается после обучения. Llama 3 Instruct даже улучшает такие показатели, как MMLU, почти на 2,5 балла, что в основном рассматривается как показатель перед обучением. Есть много других примеров, которые передаются как слухи. RLHF — это место, где происходит большая часть тонкой настройки «того, что нужно пользователям».

По этой причине рассматривать RLHF как улучшение по сравнению с предыдущей базовой моделью не имеет смысла. RLHF — это извлечение производительности из базовой модели. Тем не менее, хорошее выполнение RLHF — это чрезвычайно трудоемкий и сложный процесс. Сначала нужно получить базовую модель качества GPT-4, а затем с помощью RLHF они смогут добиться гораздо большей производительности. Вот почему в большинстве пограничных лабораторий на период постобучения выделяется около 50% вычислительных ресурсов команд предварительного обучения. Это дорого, но оно того стоит.

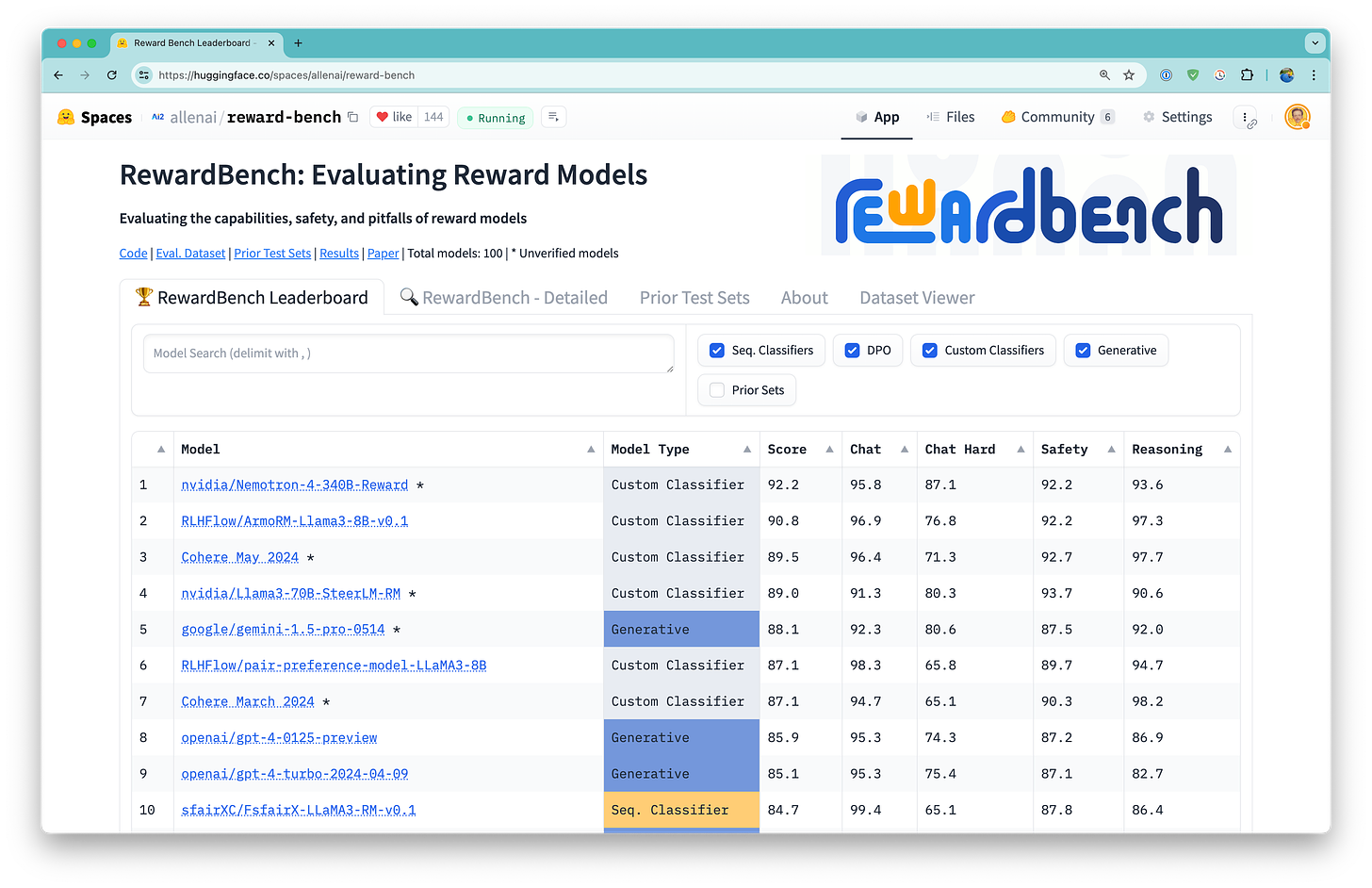

Ретроспектива RewardBench после 100 моделей и максимальной точности 90 %

С момента выпуска RewardBench , первого универсального инструмента оценки моделей вознаграждения, используемого для обучения языковых моделей с помощью RLHF, я разговаривал со многими людьми о том, как прорваться в мейнстрим оценки языковых моделей. У нас есть подтверждение того, что люди использовали RewardBench в Apple, Google, Databricks, Perplexity, Nvidia и Cohere. Другие, вероятно, рассказали нам об этом, но нам этого не сказали. Основными причинами, по которым его так быстро подобрали, были:

Это было очень конкретно.

Он заполнил совершенно пустую нишу.

Код был простым и предназначен для этого варианта использования.

Без всего этого быстрое внедрение нового инструмента оценки будет непростой задачей. Есть еще множество вещей, которые люди хотели бы измерить в языковых моделях, но оценок не существует.

На момент выпуска лучшие модели имели рейтинг в основном в диапазоне от 60 до 70%, а у одной модели этот показатель превышал 80%. Сегодня таблица лидеров гораздо лучше распределена по широкому спектру моделей: производительность лучших моделей превышает 90%. Понятно, что уже необходима вторая версия оценки, которая продлится немного дольше. Первоначальный инструмент оценки был направлен на выработку более четких представлений о том, как люди могут проводить оценку, последующие действия касаются инструментов, которые люди могут использовать в течение многих лет или даже десятилетий.

Определенно есть ошибки в наборе данных RewardBench и возникают вопросы относительно того, коррелируют ли данные с производительностью последующих этапов во время RLHF, но на протяжении всего тестового набора наблюдается явная тенденция к увеличению количества лучших моделей.

Для меня наиболее интересные дополнительные вопросы к RewardBench:

Как мы оцениваем модели вознаграждения, как это делает промышленность? Я слышал, что большая часть этого основана на согласовании модели вознаграждения с чисто человеческими данными в областях, аналогичных обучению.

Могут ли модели вознаграждения заменить LLM в качестве судьи? В таблице лидеров моделями вознаграждения являются «классификаторы» и «LLM как судья», иначе говоря, «генеративная» модель вознаграждения.

Позвольте мне рассказать об этом подробнее. В ходе нашего тестирования модели вознаграждения, прогнозирующие скалярные оценки непосредственно для двух чатов и ранжирующие их, работают намного лучше, чем вопрос о генеративной языковой модели, какой ответ был лучше. Этот факт имеет множество дополнительных фактов (и обсуждался в недавнем отчете Nvidia Nemotron 340B ). Модели вознаграждения более специализированы, чем большинство генеративных моделей, которые люди используют для оценки и которые обучены как в целом полезные агенты.

Модели вознаграждения должны предсказать только один токен, чтобы оценить фрагмент текста, обучаясь в качестве классификатора. Чтобы оценить эти ответы с помощью генеративной языковой модели (той, которую мы обычно используем, например ChatGPT), модели необходимо сгенерировать набор токенов, а затем вернуть рейтинг или оценку. Это крайне неэффективно по сравнению с моделью вознаграждения.

Если эта тенденция модели вознаграждения в качестве судьи продолжит преобладать над LLM в качестве судьи, многие инструменты оценки (например, MT Bench, AlpacaEval, Arena-Hard,…) и конвейеры наборов синтетических предпочтений станут порядками на порядок дешевле.

Каков наилучший сценарий для RewardBench и новых оценок?

Сейчас оценка имеет много уровней успеха, и все они имеют огромные преимущества. Самая низкая планка успеха оценок заключается в том, что они будут использоваться в каждой научной статье, например AlpacaEval и MT Bench. Средний уровень — это вещи, которые врываются в общий разговор, например ChatBotArena. Высшим уровнем полезных оценок являются инструменты, которые в ближайшие несколько лет будут закреплены в механизмах регулирования или надзора.

С разными уровнями успеха в оценке приходит разный набор заинтересованных игроков. Учитывая, что обучение с подкреплением на основе отзывов людей связано с безопасностью, конечными ориентирами для лучших оценок для тонкой настройки могут стать показатели таких мест, как Институты безопасности Великобритании или США, в 2025 году (спасибо Джеку Кларку, что заставил меня расширить мои ориентиры). Чтобы попасть в эту планку, оценка должна показать что-то очень конкретное и действенное. RewardBench в настоящее время там нет, но это указывает на наборы данных и отношения, которые нам необходимо курировать, если у нас есть амбициозные цели.

Воспроизводимость RewardBench

Мне пришлось пройти через длинную кроличью нору, чтобы изучить источники случайности в моделях вознаграждения, которые мы постоянно используем. Здесь я подробно описал все технические моменты, которые вызывают потенциальные проблемы при использовании RewardBench:

Конкурс моделирования вознаграждений LMSYS

LMSYS объединилась с Kaggle, чтобы организовать соревнование с некоторыми данными, полученными из ChatBotArena. В широком смысле задача состоит в том, чтобы предсказать, какой ответ модели победит при задании конкретного вопроса. Из LMSYS:

LMSYS и Kaggle запускают конкурс по предсказанию человеческих предпочтений! Вам предстоит предсказать, какие ответы предпочтут пользователи в схватках между моделями большого языка (LLM). Вы будете работать с набором данных из Chatbot Arena , содержащим разговоры и предпочтения пользователей в различных LLM. Разработав модель, которая точно прогнозирует предпочтения человека, вы внесете вклад в повышение производительности чат-бота и его соответствие ожиданиям пользователей. Набор обучающих данных включает более 55 000 реальных разговоров пользователей и LLM, а также пользовательские предпочтения, при этом личная информация удалена. Представленное вами решение будет проверено на скрытом тестовом наборе из 25 000 образцов. Набор данных включает в себя реальные разговоры с более чем 70 современными LLM, такими как модели GPT-4, Claude 2, Llama 2, Gemini и Mistral.

Учитывая все, что обсуждалось выше с ChatBotArena, я ожидаю, что эта задача будет чрезвычайно сложной. Просмотр подсказок в наборе данных показывает чрезвычайное разнообразие. Такое разнообразие просто добавляет шум в тестовый набор и снижает максимально возможную точность.

Это отличная инициатива для академического прогресса, когда задачу обучения предпочтениям можно протестировать на реальных данных с дополнительной платой, которая обычно не используется в процессе обучения с подкреплением на основе обратной связи человека (RLHF) — добавлением связей. Задача состоит в том, чтобы предсказать вероятность победы модели или ничьей. Простым решением адаптации модели вознаграждения к этому было бы просто увеличить вероятность ничьей, если вероятности ответа A и ответа B высоки, поскольку цель обучения для моделей вознаграждения спроектирована таким образом, чтобы выдаваемое вознаграждение было пропорционально вероятности выбирая этот отдельный фрагмент текста.

Добавление связей делает модели вознаграждения, выходящие из этой конкуренции, гораздо сложнее использовать для согласования последующих этапов в качестве дополнения «включай и работай». Однако способность надежно обрабатывать связи и выводить несколько классов при конкретном завершении будет иметь решающее значение для наличия более калиброванных моделей предпочтений. Калибровка в сообществе ML — это изучение распределений вероятностей, которые на самом деле являются гладкими и в сумме дают единицу, а не вывод чисел, пропорциональных вероятностям и часто требующих дальнейшего сглаживания в дальнейшем. Калибровка результатов моделей вознаграждения значительно облегчит уверенное сравнение различных убеждений и принципов, заложенных в модели вознаграждения.

В целом, да, это конкурс моделей с наградами, и это очень интересно! Я ожидаю, что решение будет основано на LLM, возможно, из Llama 3. Конкурс продлится до июля.

Уборка номеров

Аудио этого поста будет доступно (скоро) в форме подкаста (или предыдущих постов на YouTube , новое поколение я приостановил).

Мой настоящий подкаст находится на retortai.com .

Платный доступ к Discord для подписчиков в нижнем колонтитуле электронной почты.

Рефералы -> платная подписка: используйте таблицу лидеров Interconnects .

Скидки для студентов на странице «О программе» .

Источник: www.interconnects.ai