В основе всех архитектур глубокого обучения, в том числе систем компьютерного зрения и больших языковых моделей, лежит многослойный перцептрон (MLP). У него есть веса и нейроны, в которых расположены функции активации. В 2024 г. исследователи представили альтернативу MLP – новую архитектуру нейронной сети, получившую название Kolmogorov-Arnold Networks (KAN) на основании трудов Андрея Колмогорова и Владимира Арнольда. Это может значительно повлиять на развитие технологий искусственного интеллекта (ИИ) в ближайшем будущем.

Новая архитектура

Ученые из Массачусетского технологического института, Калифорнийского технологического института и Институт ИИ и фундаментальных взаимодействий представили новую архитектуру нейронной сети Kolmogorov-Arnold Networks (KAN) в качестве перспективной альтернативы многослойным перцептронам (MLP).

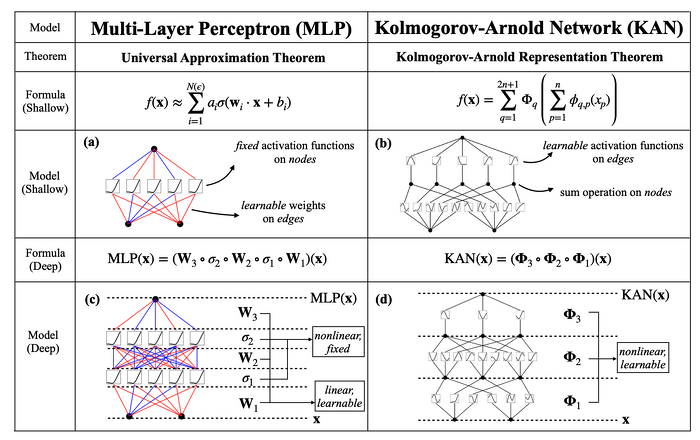

В то время как MLP имеют фиксированные функции активации на узлах «нейронах», KAN имеют обучаемые функции активации на ребрах «веса». В KAN вообще нет линейных весов – каждый параметр веса заменяется одномерной функцией, параметризованной как сплайн. Как рассказал ведущий автор исследования Цзымин Лю (Ziming Liu), в то время как MLP имеют детерминированные функции активации в нейронах, в KAN они перемещены непосредственно на веса внутри сети и становятся объектами обучения. В работе подчеркивается, что идея KAN основана на глубоких математических принципах, а именно на теореме об аппроксимации Колмогорова-Арнольда или же теорема суперпозиции.

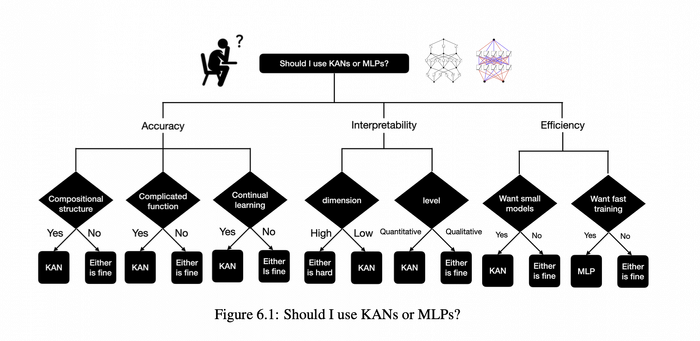

По словам исследователей, благодаря этому, казалось бы, простому изменению KAN превосходят MLP по точности и интерпретируемости. Что касается точности, то гораздо меньшие KAN могут достигать сравнимой или лучшей точности, чем более крупные MLP при подгонке данных и решении задач. Теоретически и эмпирически KAN обладают более быстрыми законами нейронного масштабирования, чем MLP.Теорема Колмогорова - Арнольда

Андрей Колмогоров - великий советский ученый, один из крупнейших мировых математиков. Один из основоположников современной теории вероятностей, им получены основополагающие результаты в топологии, геометрии, математической логике, классической механике, теории турбулентности, теории сложности алгоритмов, теории информации, теории функций, теории тригонометрических рядов. В 1994 г. Российская академия наук установила премию имени самого А. Н. Колмогорова, вручаемую «за выдающиеся результаты в области математики».

Владимир Арнольд - один из самых известных математиков в мире - родился 12 июня 1937 г. в Одессе. Уже в 28 лет он стал доктором наук, в 1984 г. - членом-корреспондентом Отделения математики АН СССР, с 1990 гг. - академиком. Много лет Арнольд являлся научным сотрудником Математического института им. Стеклова. Владимир Арнольд учился у Андрея Колмогорова - одного из великих ученых, оказавших влияние не только на развитие своей дисциплины, но и на всю науку в целом.

Наибольшую известность ученый получил в качестве соавтора теоремы Колмогорова-Арнольда-Мозера о стабильности интегрируемых гамильтоновых систем. За свою почти полувековую карьеру он внес важный вклад в развитие целого ряда областей математики, включая теорию динамических систем, теорию катастроф, топологию, алгебраическую геометрию, классическую механику и теорию сингулярностей. Многие из написанных им учебников оказали впоследствии серьезное влияние на развитие новых областей математики.

Трудами Андрея Колмогорова и Владимира Арнольда установлено, что если f - это многомерная непрерывная функция, то f можно записать в виде конечной композиции непрерывных функций одной переменной и бинарной операции сложения. Теорема решает в более общем виде тринадцатую проблему Давида Гильберта (David Gilbert), которая была мотивирована в 1900 г. применением методов номографии к вычислению корней уравнений высоких степеней, и касалась представимости функций нескольких переменных. В частности, решения уравнения седьмой степени как функции от коэффициентов, в виде суперпозиции нескольких непрерывных функций двух переменных.

В 2007 г. Владимир Арнольд был удостоен Государственной премии России в области науки и технологий за выдающиеся достижения в области математики, в 2008 г. - премии Шау за всеобъемлющие и важнейшие достижения в математической физике.

Преимущества KAN перед MLP

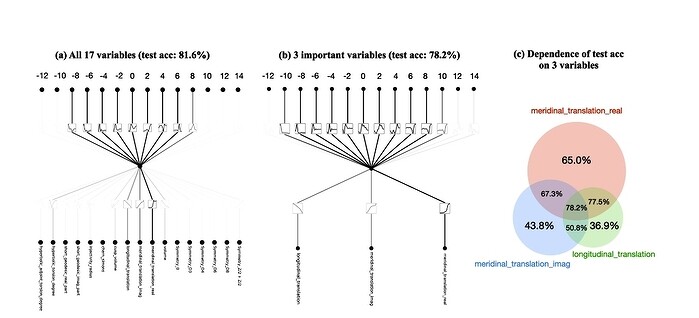

На 2 мая 2024 г. KAN показывает лучшую эффективность параметров, чем MLP. KAN не только настраивает, но и пересматривает работу сети, делая ее более интуитивной и эффективной. Вероятно, это также означает необходимость меньшего количества данных. Разработчики уже подошли к тому моменту, когда используются все данные, доступные из интернета, плюс еще больше данных, полученных синтетическим путем. Что касается интерпретируемости, то KAN могут быть интуитивно визуализированы и легко взаимодействовать с пользователями. На двух примерах из математики и физики показано, что KAN являются полезными «коллабораторами», помогающими ученым открывать математические и физические законы. В целом на начало мая 2024 г., KAN являются перспективной альтернативой MLP, открывая возможности для дальнейшего совершенствования современных моделей глубокого обучения моделей, которые в значительной степени опираются на MLP.

KAN в отличии от MLP может обрабатывать новую входную информацию без катастрофического забывания, что помогает поддерживать модель в актуальном состоянии, не полагаясь на какую-либо базу данных или переобучение. Перемещение функций активации на края, а не в ядро нейрона, что потенциально изменяет динамику обучения и повышает интерпретируемость. Применение нелинейности перед суммированием входов, что позволяет дифференцированно обрабатывать признаки и потенциально более точно контролировать влияние входов на выходы. Эта инновационная архитектура на май 2024 г. может привести к созданию сетей, которые будут не просто немного лучше, а принципиально более способными справляться со сложными динамическими задачами.

Перцептроны

Искусственная нейронная сеть (ИНС) - упрощенная модель биологической нейронной сети, представляющая собой совокупность искусственных нейронов, взаимодействующих между собой. Перцептрон является простейшим видом нейронных сетей. В основе лежит математическая модель восприятия информации мозгом, состоящая из сенсоров, ассоциативных и реагирующих элементов.

Идею перцептрона предложил нейрофизиолог Фрэнк Розенблатт (Frank Rosenblatt). Он предложил схему устройства, моделирующего процесс человеческого восприятия, и назвал его перцептроном. Перцептрон был первоначально программно смоделирован на компьютере IBM 704 в Корнеллской лаборатории аэронавтики в 1957 г. Изучая нейронные сети типа перцептрона, Розенблатт надеялся понять фундаментальные законы организации, общие для всех систем обработки информации, включая как машины, так и человеческий разум. В 1960 г. Розенблатт представил первый нейрокомпьютер — «Марк-1», который был способен распознавать некоторые буквы английского алфавита.

Cравнительные тесты обучения нейросетей

В 2023 г. CNews публиковала результаты очередного бенчмарка MLPerf Training, разработанного консорциумом Machine Learning (ML) Commons. С его помощью составляется рейтинг наиболее производительных систем для формирования моделей ML, в том числе наиболее масштабных. Лидирующие позиции заняли машины, построенные на основе технологий Nvidia и Intel. К ним также присоединился Google с собственными разработками, однако до двух лидеров ему еще очень далеко.

В общей сложности 19 компаний и институтов представили свои собственные результаты тестирования, что в целом показало 2,8-кратный рост производительности тестируемых систем с 2022 по 2023 гг., и 49-кратный прирост с тех пор, как в 2018 г. возник сам бенчмарк MLPerf.