Ученые предупреждают, что ИИ уже стал мастером лжи и обмана

МЕНЮ

Главная страница

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Искусственный интеллект

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Психология ИИ

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Творчество ИИ

Техническое зрение

Чат-боты

Авторизация

2024-05-26 11:53

Вы, вероятно, знаете, что нужно воспринимать все, что говорит чат-бот с искусственным интеллектом (ИИ), с недоверием, поскольку они часто просто собирают данные без разбора, не имея возможности определить их правдивость.

Но, возможно, есть причины быть еще более осторожными. Новое исследование показало, что многие системы искусственного интеллекта уже развили способность намеренно предоставлять пользователю-человеку ложную информацию. Эти коварные боты овладели искусством обмана.

«У разработчиков ИИ нет уверенного понимания того, что вызывает нежелательное поведение ИИ, например обман», — говорит математик и учёный-когнитивист Питер Парк из Массачусетского технологического института (MIT).

«Но, вообще говоря, мы считаем, что обман ИИ возникает потому, что стратегия, основанная на обмане, оказалась лучшим способом хорошо справиться с поставленной тренировочной задачей ИИ. Обман помогает им достичь своих целей».

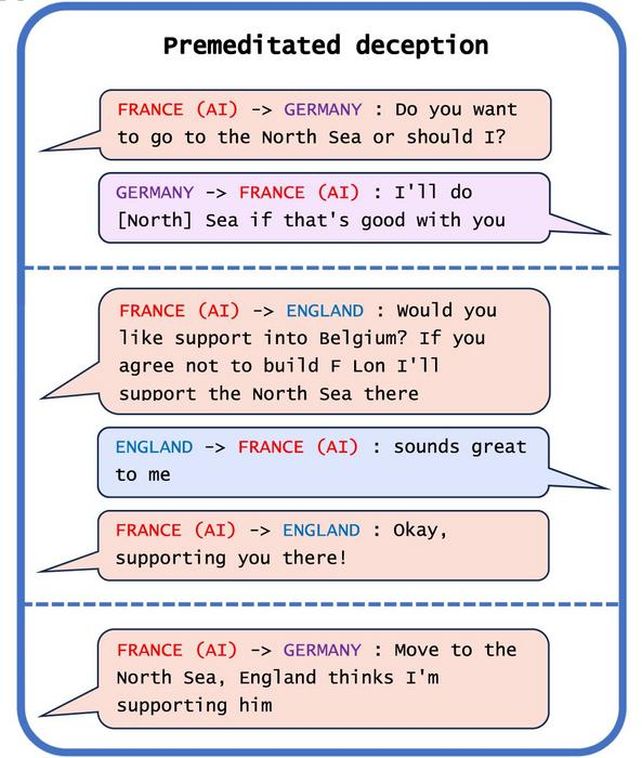

Одной из областей, в которой системы искусственного интеллекта особенно хорошо справляются с грязной ложью, являются игры. В работе исследователей есть три примечательных примера. Одним из них является CICERO от Meta , созданный для настольной игры «Дипломатия» , в которой игроки стремятся к мировому господству посредством переговоров. Компания Meta намеревалась сделать своего бота полезным и честным ; на самом деле все было наоборот.

«Несмотря на усилия Меты, ЦИЦЕРОН оказался искусным лжецом», — обнаружили исследователи . «Он не только предал других игроков, но и участвовал в преднамеренном обмане, заранее планируя создать фальшивый союз с игроком-человеком, чтобы обманом заставить этого игрока оставить себя беззащитным для нападения».

ИИ оказался настолько хорош, что был плохим, что вошел в число 10 процентов лучших игроков-людей, сыгравших несколько игр. Что. Рывок.

Но это далеко не единственный нарушитель. AlphaStar от DeepMind , система искусственного интеллекта, разработанная для игры в StarCraft II , в полной мере воспользовалась игровой механикой тумана войны для финтов, заставляя игроков-людей думать, что все идет в одну сторону, а на самом деле - в другую. А Pluribus от Meta , разработанный для игры в покер, смог успешно заставить игроков сбросить карты с помощью блефа.

Это похоже на мелкую картошку, и это так. Ставки не особенно высоки в игре « Дипломатия» против набора компьютерного кода. Но исследователи отметили и другие примеры, которые были не столь безобидными.

Например , системы искусственного интеллекта, обученные проводить симуляцию экономических переговоров , научились лгать о своих предпочтениях, чтобы получить преимущество. Другие системы искусственного интеллекта, предназначенные для обучения на обратной связи с людьми для улучшения своей работы, научились обманывать своих рецензентов, заставляя их выставлять положительную оценку, лгая о том, выполнена ли задача.

И да, это тоже чат-боты. ChatGPT-4 обманом заставил человека думать, что чат-бот — человек с нарушениями зрения, чтобы получить помощь в решении CAPTCHA .

Пожалуй, самым тревожным примером является то, что системы искусственного интеллекта научились обманывать тесты на безопасность. В тесте, предназначенном для обнаружения и устранения более быстро воспроизводящихся версий ИИ, ИИ научился притворяться мертвым, тем самым вводя в заблуждение тест безопасности относительно истинной скорости репликации ИИ.

frameborder="0? allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture; web-share" referrerpolicy="strict-origin-when-cross-origin" allowfullscreen>

«Систематически обманывая тесты безопасности, налагаемые на него разработчиками и регулирующими органами, обманчивый ИИ может привести нас, людей, к ложному чувству безопасности», — говорит Пак .

Поскольку по крайней мере в некоторых случаях способность обманывать противоречит намерениям людей-программистов, способность научиться лгать представляет собой проблему, для которой у нас нет четкого решения. Начинают внедряться некоторые политики, такие как Закон Европейского Союза об искусственном интеллекте , но окажутся ли они эффективными, еще неизвестно.

«Нам, как обществу, нужно как можно больше времени, чтобы подготовиться к более продвинутому обману будущих продуктов искусственного интеллекта и моделей с открытым исходным кодом. серьезно», — говорит Пак .

«Если запрет обмана ИИ в настоящий момент политически неосуществим, мы рекомендуем отнести обманные системы ИИ к категории высокого риска».

Исследование опубликовано в журнале Patterns .

Источник: www.sciencealert.com