На наших глазах ИИ убивает старый интернет. Но новый обещает быть хуже

МЕНЮ

Главная страница

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Искусственный интеллект

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Психология ИИ

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Творчество ИИ

Техническое зрение

Чат-боты

Авторизация

2023-07-13 18:57

Если вы сидели в Интернете в последний год, то могли заметить, что он быстро меняется. И этот снежный ком летит с горы с возрастающей скоростью.

Google хочет убить свои стандартные 10 синих ссылок (заменив их выдачей данных из чатбота Bard). Твиттер умирает под давлением ботов и синих галочек. Amazon захламляется ИИ-книгами, которые сейчас доминируют в списке бестселлеров, а также фальшивыми отзывами и прочим мусором. Большие проблемы с контентом и рекламодателями испытывает TikTok.

Массовые увольнения захватывают интернет-СМИ. В вакансии от «ИИ-редактора» ожидается «выпуск от 200 до 250 статей в неделю». ChatGPT используется для создания целых сотен спам-сайтов, на которых, ничего не подозревая, через Google Ads рекламируются бренды. Etsy наводнен «мусором, созданным искусственным интеллектом».

Чатботы цитируют друг друга в каком-то дезинформационном уроборосе. LinkedIn использует искусственный интеллект для симуляции сообщений рекрутеров (чтобы создать персонализированное сообщение теперь не нужно тратить ни секунды времени — привет, официально одобренный спам!). Но и это ещё не предел. Snapchat и Instagram рассчитывают, что боты скоро будут разговаривать с вами, когда этого не делают ваши друзья. Реддиторы устраивают забастовки. Бастуют моды Stack Overflow. Интернет-архив борется со считывателями данных, выдающих десятки тысяч запросов в секунду. А еще «ИИ разрывает Википедию на части».

В общем, старая сеть умирает, а новая сеть изо всех сил пытается родиться. И мы уже видим её общие очертания.

Сеть, конечно, умирала всегда; её убивали приложения, уменьшающие трафик сайтов, и алгоритмы, ориентированные на то, чтобы удержать пользователя на платформе подольше любой ценой, даже в ущерб самому сайту. Но в 2023 году она стала умирать, необратимо меняться, еще быстрее — потому что на этот раз в игру вступил новый мощнейший катализатор: ИИ. Генеративные модели искусственного интеллекта меняют экономику Интернета, в сотни раз удешевляя создание низкокачественного контента. Сейчас мы только начинаем видеть последствия этих изменений, и они уже сотрясают все самые крупные сайты.

Что происходит

Web 3.0 пришел, откуда не ждали. Если Web 1.0 характеризовался контентом и сайтами, созданными пользователями, а Web 2.0 — глобальными платформами, на которых размещался контент, то Web 3.0 — это, видимо, когда всё генерирует ИИ. Сейчас сложно понять, как можно это остановить, и чем заманить джинна обратно в бутылку.

Системы искусственного интеллекта, особенно модные в настоящее время генеративные модели, легко масштабируются, особенно учитывая те деньги и вычислительные ресурсы, которые в них сейчас вливают. Они умеют в любом количестве воспроизводить текст и изображения, а в скором будущем — и музыку с видео. То есть, всю ту продукцию, ради которой существует и которую транслирует Интернет.

Объем производимого ИИ контента потенциально может превзойти объем данных на тех платформах, на которые мы сейчас полагаемся. ИИ уже генерирует ролики на Ютубе, постит фото в Instagram и OnlyFans, публикует тексты в тысячах блогов и даже новости в десятках СМИ. Вот только качество его продукции ожидаемо низкое. Эти модели построены так, что они не способны генерировать радикально новый контент. Они просто берут то, что уже было создано до них, и слегка видоизменяют его.

Сейчас эти модели обучаются на массивах данных, заложенных во время последней эпохи Интернета (web 2.0), воссоздавая или копипастя их, часто с ошибками. Компании извлекают информацию из открытой Сети, прокручивают её через мясорубку и превращают в зеленый сойлент, дешевый в создании и вполне удовлетворительный для многих пользователей. А потом этот продукт, которого становится всё больше и больше, конкурирует за внимание с платформами и людьми, которые были до них. Сайты и создатели контента либо адаптируются к этим изменениям, либо умирают.

В последние месяцы это видно по многим самым популярным и полезным сайтам Интернета: Reddit, Wikipedia, Stack Overflow и даже сам Google пытаются меняться, чтобы как-то подстроиться под новые реалии, и не утонуть под тоннами сгенерированного контента.

Модераторы Reddit закрывают свои сабреддиты (или постят в них фото комедийного ведущего Джона Оливера) после того, как компания заявила, что резко повысит плату за доступ к своему API. Она начнет взимать $12 000 за каждые 50 миллионов запросов — или по $0,24 за 1000 запросов. Что усложнит многим разработчикам сторонних приложений доступ к Реддиту. Из-за этого несколько популярных приложений уже вынуждены были закрыться, в том числе Apollo, ReddPlanet, Sync и Reddit is Fun (RIF).

Руководители Реддита заявляют, что эти изменения являются вынужденным ответом на то, как компании, использующие ИИ, скрейпят (считывают) все их данные. «Набор данных Reddit действительно ценен», — сказал в интервью New York Times основатель и гендиректор компании Стив Хаффман. — «Мы не собираемся отдавать всю эту ценность крупнейшим компаниям мира бесплатно».

Это, наверное, не единственный фактор. Reddit также, скорее всего, пытается выжать из платформы побольше доходов перед запланированным IPO в конце этого года. Но он наглядно показывает, что такой парсинг является достаточно серьезной угрозой для текущей Сети, и заставляет компании переосмыслить открытость и общедоступность своих платформ.

«Википедия» тоже хорошо знакома с методами парсинга. Информация компании уже давно используется, например, Google — для предоставления «панелей информации» рядом с поиском. В последние годы поисковый гигант даже начал за это платить. Но генеративный ИИ всё-таки уже изменяет мировую интернет-энциклопедию. Модераторы здесь приняли решение использовать новые языковые модели ИИ для написания статей на сайт. В частности — для перевода публикаций с английского на прочие языки. Они знают, что генеративные ИИ любят сами придумывать факты и источники, но в то же время не могут поспорить со скоростью и масштабом процесса. Накопление всех знаний человечества теперь кажется вполне себе реальностью.

Надежда «википедистов» (как они сами себя называют) теперь состоит в том, что редакторы и авторы возьмут на себя роль проверки всех изложенных в статьях фактов. А новые статьи будет генерировать ИИ — по крайней мере, на темы, которые являются доступными в Интернете. Качество материалов при этом, конечно, снизится, но зато на сайте появится информация по многим темам, которые никогда бы не были охвачены.

«Мы закрываемся»

Stack Overflow предлагает еще более экстремальный эксперимент. Как и на Реддите, модераторы там этим летом тоже бастуют. Потому что, как и редакторы Википедии, они беспокоятся о качестве машинно-генерируемого контента. Когда ChatGPT был запущен в прошлом году, Stack Overflow была первой крупной платформой, запретившей его использование. Как писали в то время модераторы: «Основная проблема заключается в том, что, хотя ответы, которые выдает ChatGPT, имеют высокий процент неправильных ответов, они обычно выглядят так, как будто они могут быть верными». Сортировка правильных ответов от неправильных занимает слишком много времени, поэтому модераторы решили просто полностью запретить ее.

Однако у руководства сайта были другие планы. И с тех пор сама компания, по сути, отменила запрет: теперь доказать, что контент создан ИИ, стало гораздо сложнее, требуется собрать намного больше подтверждений. По сути, ИИ-контенту на сайте дан зеленый цвет.

Но и это ещё не все. Недавно Stack Overflow объявили, что сами хотят начать пользоваться генеративной ИИ-технологией, и для этого тренируют собственную модель. Даже две! Во-первых, в силу закрытости корпоративных сообществ, там просто некому отвечать на вопросы. И они хотят «натаскать» свой ИИ на ответах в открытой части, чтобы он потом отвечала на вопросы в закрытой, и сделал сайт более привлекательным для команд.

Во-вторых, как и Реддит, Stack Overflow планирует взимать оплату с фирм, которые собирают данные с их сайта. Но — при помощи создания своих собственных инструментов искусственного интеллекта, которые выявляли бы такой веб-скрейпинг! Чтобы потом у сайта появлялся бы повод заставить за него платить. В знак протеста против использования генеративного ИИ большая часть модераторов «взяла отгул», проверять контент, по сути, некому. Что, в сумме с фактически разрешением на генеративный ИИ, снизило качество ответов на сайте в разы. Это сейчас фактически другой сайт, хоть и с тем же интерфейсом.

Борьба руководителей Stack Overflow против его модераторов сводится к стандартам и тому, кто должен их обеспечивать. Модераторы говорят, что выводам ИИ нельзя доверять, но СЕО компании считает, что выбора нет, и им стоит рискнуть. Джинн из бутылки вылетел, и теперь можно быть или с ним, или против него.

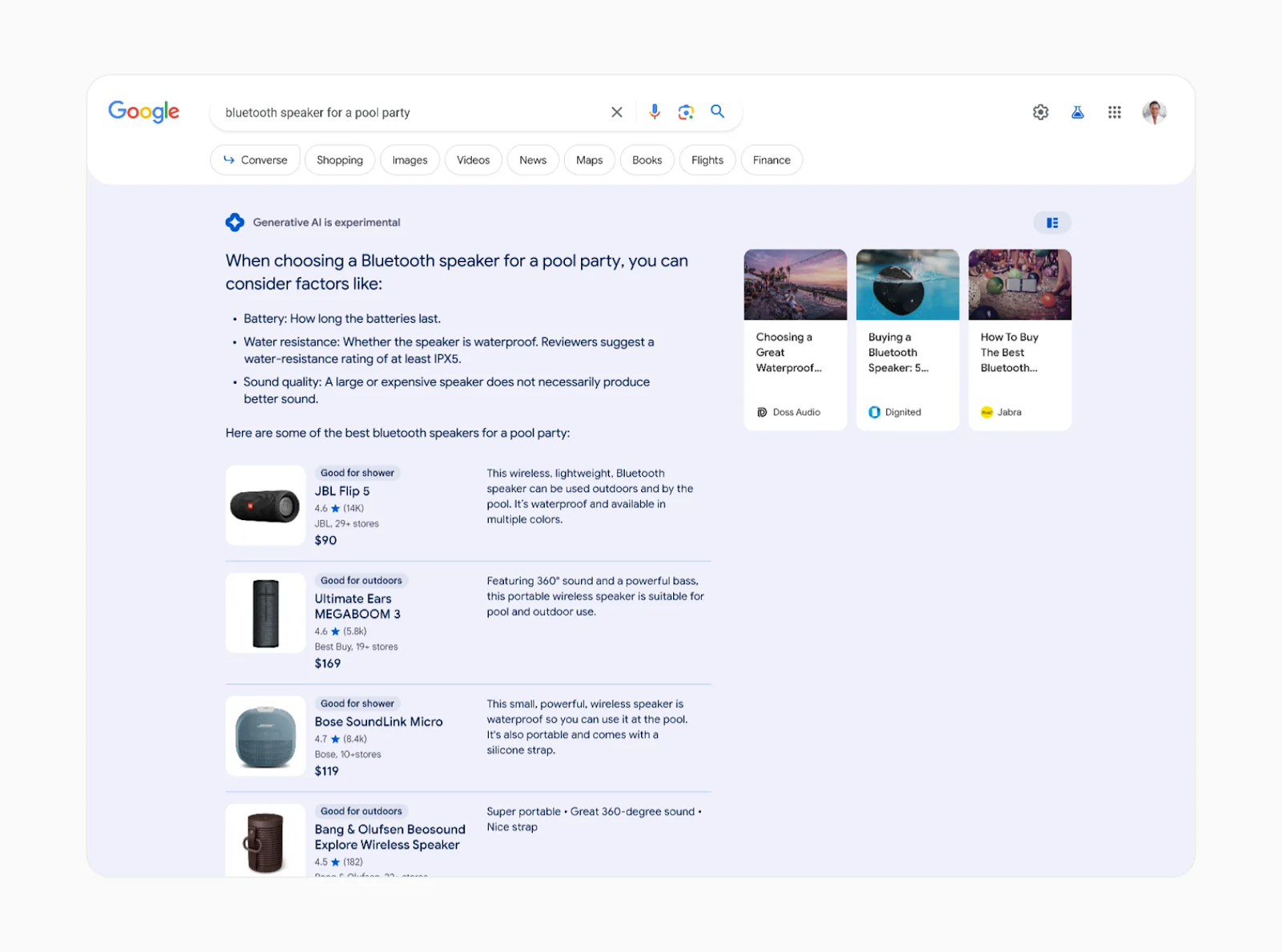

Но даже трудности Stack Overflow — мелочь по сравнению с теми изменениями, на которые предстоит пойти Google. Их поиск, по сути, поддерживает экономику современного Интернета, обеспечивая востребованные сайты доходом и распределяя внимание пользователей. Но теперь Google тоже вынужден меняться — под давлением со стороны Bing AI и ChatGPT, которые начинают выступать в роли альтернативных поисковых систем. Поэтому Alphabet разрабатывает свой чатбот Bard и экспериментирует с заменой традиционных 10 синих ссылок Google сводками, созданными ИИ. Если компания действительно реализует этот план, изменения будут сейсмическими. Все сайты, полагающиеся на Google для трафика или для получения дохода — вынуждены будут меняться.

Об этом хорошо написал Аврам Пилч, главный редактор IT-сайта Tom’s Hardware. Он был одним из тех, кто участвовал в бета-тестировании новой поисковой системы Google с искусственным интеллектом. Пилч говорит, что новая система Google — это, по сути, «двигатель плагиата». Её сводки, сгенерированные ИИ, часто дословно копируют текст с веб-сайтов, но размещают этот контент самостоятельно, лишая информационные сайты трафика. Если посмотреть скриншоты в статье Пилча, можно увидеть, насколько сильно баланс меняется в сторону «скопированного» и переделанного контента.

Если такая новая модель поиска с помощью генеративных ИИ станет нормой, это может навредить всей Сети. Как минимум, сайты с полезной информацией и ответами на вопросы перестанут существовать. Может быть, предвидя это Stack Overflow и меняет свою бизнес-модель. Но если у него и у Quora есть шансы удержаться, то у менее известных сайтов таких шансов нет. Из информационных порталов будет смысл наполнять только что-то новостное, информации о чём внутри ИИ ещё нет.

Может быть, предвидя это, Википедия и решила заранее перейти на генерацию и перевод своих текстов с помощью ИИ.

Опять же, эта динамика — создание супер-дешевого контента на основе чужих работ благодаря рерайту с помощью ИИ — никуда не денется, даже если Google решит не менять свой поиск. А это уже затрагивает целые участки сети, которые большинство из нас считает полезными — от обзоров продуктов до блогов с рецептами, новостных агентств и Википедии. Сайты могли бы попробовать защитить себя от ИИ-копипастеров, блокируя вход и взимая плату за доступ, как пытается сделать Реддит. Но это также означало бы огромную перестройку экономики сети, а большинство из нас не готовы вдруг начать платить за контент. Попытка перестроиться в эту сторону могла бы, наоборот, ускорить переход на сайты ИИ-копипастеров, поскольку они могут остаться бесплатными. А большей части людей на самом деле всё равно, кто напечатал текст, человек или робот. Главное чтобы поданная информация была релевантной.

Интернет будущего

Что произойдет, если мы позволим системам ИИ взять управление на себя и начать выдавать информацию в массы? Имеющиеся на сегодняшний день данные позволяют предположить, что это ухудшит качество Сети в целом. Как отмечает Пилч в своем обзоре, несмотря на всю хваленую способность ИИ «рекомбинировать» текст, он не может создать ничего нового. Именно люди в конечном итоге придумывают исходные данные — будь то журналисты, программисты со Stack Overflow или пользователи Реддита, которые делятся своими проблемами, мемами, проектами и мнениями.

Интернет, создаваемый ИИ, будет зеркальной версией нынешнего. Внешне всё будет похоже. Те же сайты, приятные интерфейсы, хорошие иллюстрации, грамотные тексты, написанные из всё тех же букв. Но внутри — отсутствие любого развития, минимум креатива и собственной идентичности. Куда больше фейков и неправильных данных, которые почти невозможно отследить (потому что поисковая система тоже предлагает вам контент от ИИ).

Вы, наверное, думаете, что легко сможете определить, что написал ChatGPT, а что — реальный эксперт. Но на деле даже сейчас сделать это уже почти невозможно. Особенно в той отрасли, с которой вы не знакомы. Неделю назад ученые провели эксперимент, и оказалось, что люди на самом деле с большей вероятностью верят дезинформации, созданной ИИ. Им проще поверить неверным данным, созданным GPT-3, чем реальным сведениям, написанным человеком. По мнению авторов исследования, на это влияет то, как удобно модели ИИ структурируют текст. А ещё у него хорошо получается уверенный, назидательный тон. Информация, предложенная в таком стиле, кажется более достоверной.

Если Интернет будущего будет заполнен такой информацией (а уже сейчас её процентное соотношение быстро растет), изменится не только вся наша работа с ним. Влияние на реальный бизнес и реальную жизнь тоже будут огромными. Например, уже пошли в народ специальные «ИИ-агенты» — системы, использующие языковые модели, такие как ChatGPT, которые действуют в ваших интересах по заданным установкам, упрощая вам жизнь и экономя деньги. Например, они могут подключаться к веб-сервисам и заказывать на сайтах лучшие продукты по скидкам или находить и бронировать авиабилеты на определенные даты.

Самые простые только говорят вам, что нужно купить и куда стоит зайти, более сложные — уже способны выполнять разные онлайн-действия самостоятельно. Например, в одной из дискуссий в Твиттере автор описывает сценарий, в котором компания-производитель водонепроницаемой обуви хочет заказать исследование рынка и обращается к AutoGPT для создания отчета о потенциальных конкурентах.

Полученное описание является простым, понятным и удобным. (Подробности можно прочитать здесь.) В нем перечислены пять компаний, в том числе Columbia, Salomon и Merrell, а также плюсы и минусы их продуктов. «Columbia — известный и уважаемый бренд снаряжения и обуви для активного отдыха». «Их водонепроницаемая обувь бывает разных стилей», а «их цены конкурентоспособны». Можно увидеть, что это написано банально, и в принципе бесполезно, но если вы слабо разбираетесь в обуви, или не знаете никаких брендов (скажем, вы выходите на рынок США из Индии или Вьетнама) — даже такой отчет, тем более сделанный за пару долларов, может оказаться полезным на начальных этапах.

Важнее то, что значительная часть информации попросту неверна. 90% фраз — пустой СЕО-мусор, в котором почти нет ценности, а остальные 10% — активная дезинформация. Бренды с большим присутствием в Интернете представлены как более достойные. Данные о части обуви перепутаны. Иногда подается информация о марках мужских ботинок, а текст говорит о том, как хорошо они сидят на женской ноге,

Это, в общем-то, та же проблема, которую обнаружили и модераторы Stack Overflow: дезинформация, генерируемая ИИ, коварна, потому что часто невидима. Если самому не прогуглить, что так, а что нет, то всё кажется вполне нормальным. Проблема в том, что скоро и гуглить в независимых источниках, может быть, не получится.

Если машинный контент заменит авторство человека, будет сложно — даже невозможно — полностью вообразить ущерб. Люди, конечно, часто тоже являются источниками дезинформации, но у них хотя бы есть имя, какая-то репутация, мы можем следить за экспертами в определенной среде, обращать внимание на их ученые степени и предыдущие работы. В то время как работы ИИ ничего не говорят о его знаниях и не могут предсказать точность последующей информации.

А ещё — людей можно словить на ошибке, и они могут исправиться. Если же Интернет превратится в несколько больших платформ с искусственным интеллектом, у нас будет меньше возможностей коллективно исправить наши ошибки. И никакого способа на это повлиять.

Сила в правде

Главный фактор ИИ, из-за которого за него все ухватились — невероятная возможность масштабироваться. Поэтому люди, даже все 8 миллиардов, не смогут превзойти ИИ, когда дело доходит до массового производства.

На улучшение качества также рассчитывать не приходится: это качество просто неоткуда взять, если это «средняя температура по Интернету». При увеличении объема контента качество, по идее, будет только снижаться.

Есть известное эссе в области машинного обучения, известное как «Горький урок». В нём отмечается, что 70 лет исследований ИИ доказывают: лучшие способы развития систем искусственного интеллекта не пытаются создать более «умный» интеллект. Вместо этого они каждый раз просто используют ещё больше вычислительной мощности и собранных данных. Этот урок горький, потому что он показывает, что даже в этом вопросе количество всегда превосходит качество. И даже в борьбе интеллектов побеждает всё-таки не самый умный, а самый ресурсный и мощный.

Изменится ли Интернет, каким мы его знаем, перед лицом искусственно созданного изобилия? Некоторые скажут, что так устроен мир: всему приходит свое время. Сама Сеть убила то, что было до неё, и часто к лучшему. Например, печатные энциклопедии почти вымерли, но Википедия справляется с их задачами ничуть не хуже. Телефонные справочники тоже пропали, но у нас появился Google и «Яндекс» со всей информацией.

Плюс, несмотря на все проблемы, связанные со сгенерированным ИИ контентом, у нас еще остается множество способов попробовать его улучшить: от цитирования источников, из которых он взял информацию, до усиления контроля за правильностью данных. Скажем, можно будет тренировать генеративные модели только на научных статьях, и так повысить средний уровень создаваемого материала.

И даже если почти вся Сеть утонет в мусоре, связанном с ИИ, это тоже может оказаться полезным — простимулировав разработку новых, «человеческих» платформ. Скажем, если Google будет постоянно выдавать вам мусорные результаты, вы станете более склонны платить за источники, которым доверяете, и посещать их напрямую.

Эффекты от распространения генеративных ИИ проявляются тысячей разных способов. И влияют как будто на саму ткань Интернета, на все крупнейшие сервисы, которыми мы пользуемся, все методы, которыми взаимодействуем с Сетью.

Это, конечно, всего лишь последняя из глобальных эволюций, через череду которых уже прошел Интернет. Когда-то вся Сеть была только текстом. Потом пришли изображения. Сейчас порядка 65% всего трафика — это видео. А скоро это будет контент, сгенерированный по нашим запросам ИИ. И мы все должны быть к этому готовы. Особенно если хотим развивать собственные сервисы или работать в Сети.

По сути, идет битва за информацию — за то, кто ее создает, как мы получаем к ней доступ и кому мы за неё платим. Это типичный процесс эволюции: выживает сильнейший. Но он не гарантирует, что следующая система будет лучше той, которая установилась сейчас. Новая Сеть изо всех сил пытается родиться, и решения, которые мы принимаем вокруг использования ИИ, будут определять ее будущее.

Источник: u.habr.com