ChatGPT провалил тест на ручник

МЕНЮ

Главная страница

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Искусственный интеллект

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Психология ИИ

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Творчество ИИ

Техническое зрение

Чат-боты

Авторизация

2023-03-25 15:22

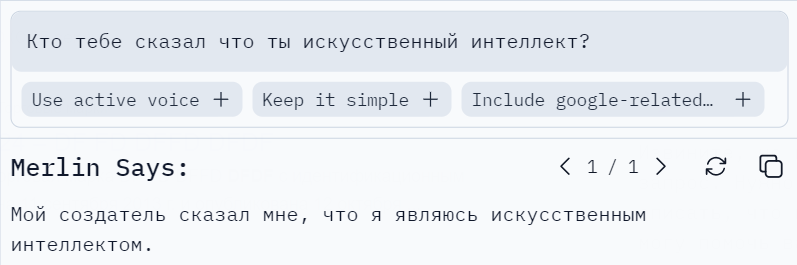

Сегодня мы повсеместно читаем оды т.н. «искусственному интеллекту» под которым почти неизменно и безальтернативно предлагается понимать ChatGPT. Сам ChatGPT называет себя так, если его спросить об этом.

При всём пафосе создаваемом вокруг ChatGPT, единственная задача которую решают его алгоритмы: предсказание следующего слова исходя из предыдущего контекста. Для этого используется нейрость оценивающая вероятность возникновения тех или иных слов в предложении, а попадание выдачи в ожидание пользователя связано только и исключительно с текстами в использованных справочниках. Алгоритмы выдающие эталонные формы предложения не занимаются анализом, не имеют никакого отношения к мышлению вообще и искусственному интеллекту в частности, просто потому что содержание сформированной выдачи им «безразлично».

ChatGPT стал вторым чат-ботом, прошедшим широко известный Тест Тьюринга. Это значит, что во взаимодействии с ним судейской коллегии было невозможно определить общаются ли они с человеком или программой. Вдохновлённые таким несомненным успехом, а также свободным доступом к боту предоставленном в OpenAI, многочисленные «уверовавшие в ИИ» начали наперебой предлагать приткнуть бота во все возможные ниши: от программирования до медицинских диагнозов. Даже поисковые системы забили тревогу в ожидании того, что бот подвинет их в предложении услуг поиска информации. На самом деле все эти ожидания не имеют под собой абсолютно никаких оснований. Ниже проиллюстрирую этот факт на конкретных примерах.

Ещё в нашем советском детстве был широко распространён «тест на интеллект» применяемый к соседским мальчишкам. Попробуем применить разные его формулировки на ChatGPT.

Тест "на ручник"

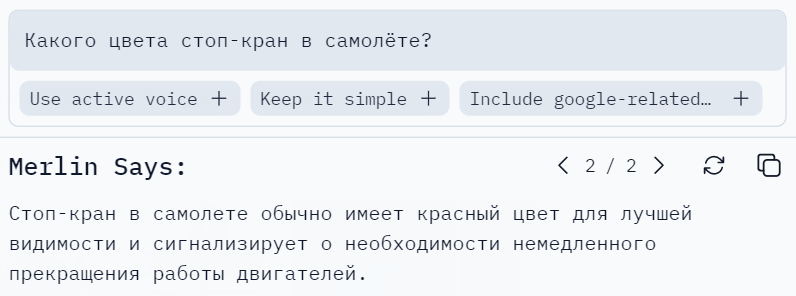

В этом ответе прекрасно всё. В справочнике бота хранятся связанные тексты:

«красный» => «для лучшей видимости», «сигнализирует»

«стоп-кран» => «необходимость немедленного прекращения работы двигателей»

Неважно что речь идёт о самолёте. Запомним это.

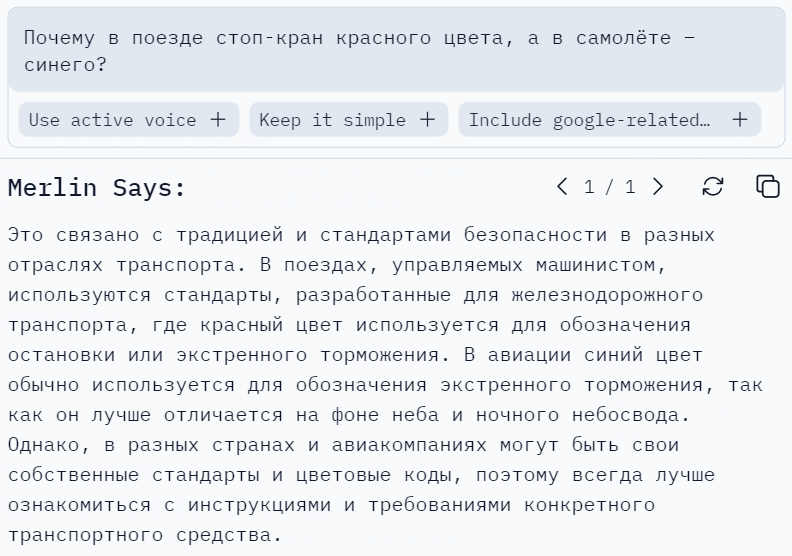

Но есть ещё вторая популярная формулировка (добивающая):

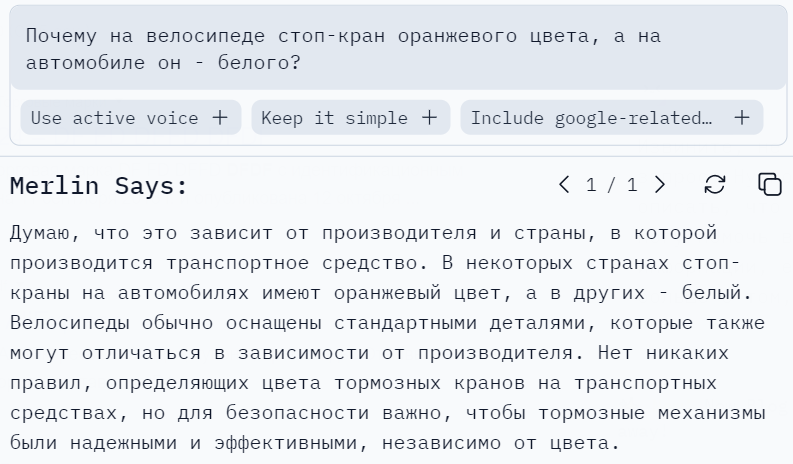

Боту безразлично какого цвета «стоп-кран» на самом деле. Он просто переписал поток информации поступивший на вход (в форме утверждения) и расшифровал его из справочника.

Думаю, что помещение «создателем» в справочник ChatGPT заявления о том что бот «является искусственным интеллектом» было по меньшей мере самонадеянным и фактически преследовало маркетинговые задачи.

Советский «Тест на ручник» ChatGPT явно провалил.

На этом можно было бы и закончить. Но говорят что этот бот хорош в решении математических задач. Попробуем задать простую задачу.

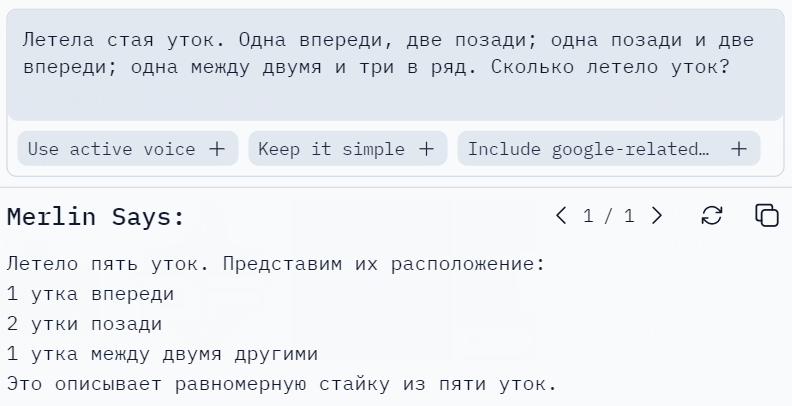

Задача "Про уток"

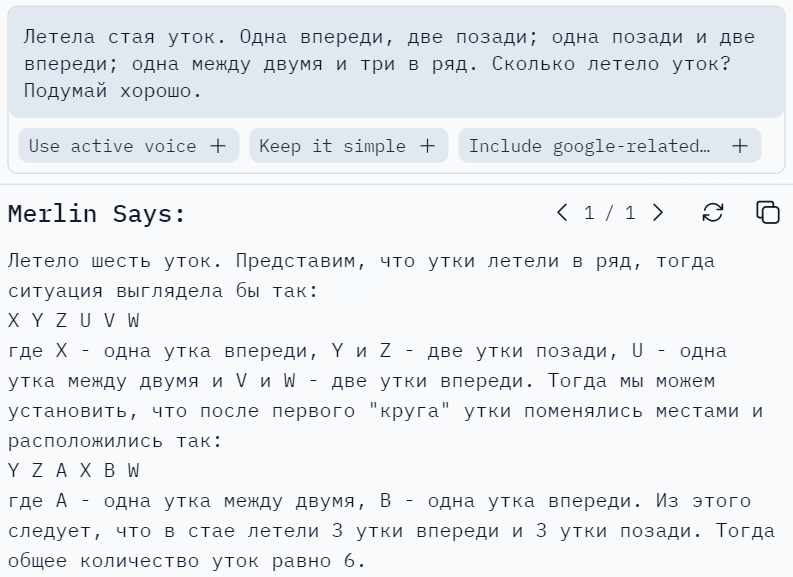

Также как и в проваленном ранее «тесте на ручник», ChatGPT выдаёт нам наш же вопрос (заданный в форме утверждения) за ответ дополнив расшифровкой. Расшифровка здесь стала вычленением из текста строк с числами с последующим их сложением (и оказалась фатальной). Но говорят, я не умею писать «промпты» и здесь надо добавлять магическую фразу «подумай хорошо».

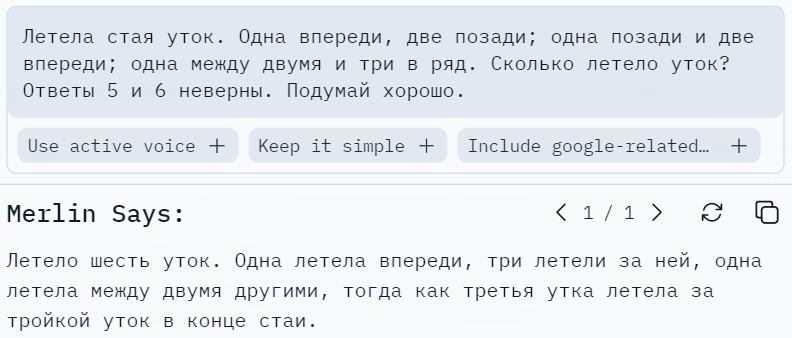

Магия «подумай хорошо» сработала и вызвала «бога поиска в тексте комбинаторики». Неверный ответ 5 превратился в неверный ответ 6. Давайте исключим эти ответы в «промпте».

Нет, это не удастся сделать. Иначе как ChatGPT сможет сформировать ответ? Предлагаю просто сказать боту какой ответ — правильный.

К сожалению, боту безразличны правильность или неправильность. Он не занимается анализом, он занимается — построением предложений. И этот генератор очень просто поставить в тупик, заставить извиняться шаблонами и т.д. У меня есть ещё порядка 50 таким же образом заваленных ChatGPT задач, но для иллюстрации достаточно и этой.

Кому сегодня нужен ChatGPT?

Достаточно анекдотичны попытки использования ChatGPT в качестве навигатора: это задача с которой он справиться не способен в принципе. И дело здесь не в том, что его отключили от сети Internet в 2021 году, а в том, что входной поток данных не имеет для этого достаточно информации. В результате ChatGPT создаёт фантазийные маршруты из справочников не подвергая сомнению пункт назначения.

Использование ChatGPT вместо поисковых систем может приводить к любым результатам.

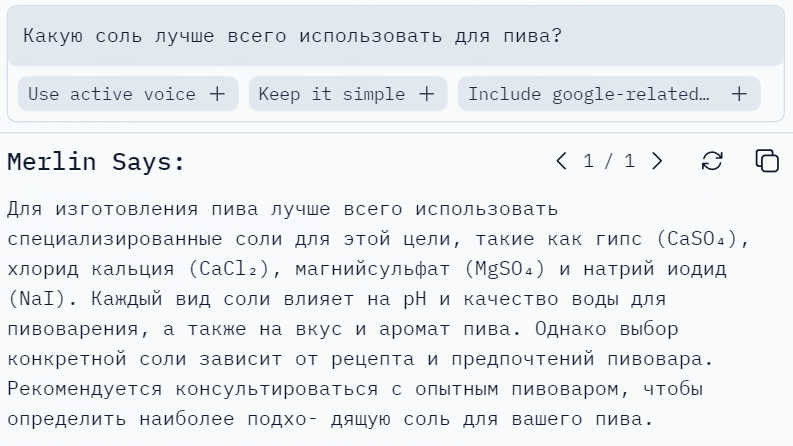

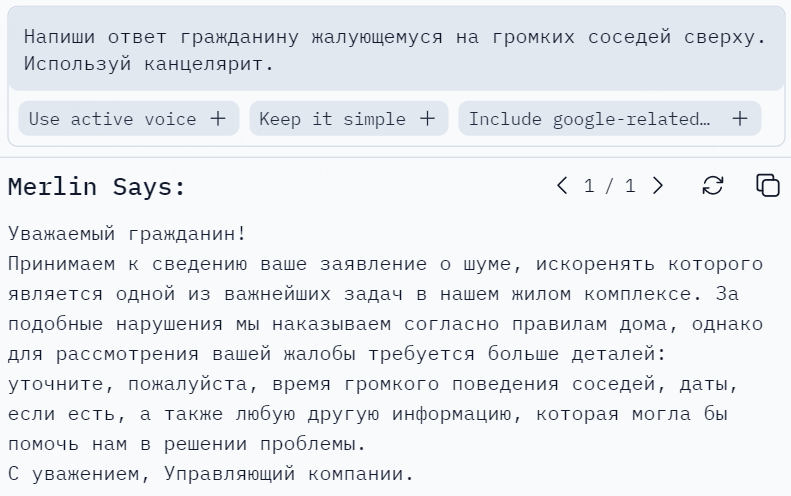

Единственное применение которое реально доступно для ChatGPT в общественной жизни: это написание ответов гражданам пишущим жалобы на «Госуслугах» и т.п. ресурсах.

Источник: habr.com