Почему состязательные атаки на системы распознавания образов — это серьёзно

МЕНЮ

Главная страница

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Искусственный интеллект

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Психология ИИ

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Творчество ИИ

Техническое зрение

Чат-боты

Авторизация

2021-12-08 05:21

Используемая сейчас архитектура разработки ИИ для распознавания изображений имеет серьёзные уязвимости, при эксплуатации которых можно серьёзно запутать компьютер, заставив его выдавать неправильные результаты. Какие существуют проблемы и способы обмана ИИ — в нашем материале.

Возможно, вы знаете, кроме машинного обучения существует и вредоносное машинное обучение (Adversarial Machine Learning). Первые публикации по теме AML относят к 2004 году. Примерно до 2015 года, пока ML не получило широкого распространения на практике, вредоносное ML также носило теоретический характер. Однако в 2013 году Christian Szegedy из Google AI, пытаясь понять, как нейросети «думают», обнаружил интересную особенность этого ML-метода. Оказалось, системы распознавания изображений легко обмануть путём небольших изменений.

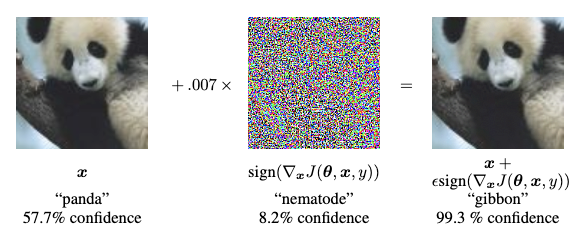

Классическим примером стало изображение панды, которое компьютер распознавал неправильно. Хитрость в том, что в исходное изображение панды, распознаваемое с вероятностью 57,7 %, добавили шум, невидимый человеческому глазу, но заметный для компьютерной системы. В результате нейросеть считает, что вместо панды на картинке изображён гиббон с вероятностью 99,3 %.

О примерах adversarial атак хорошо рассказано в этой статье. Если коротко, то есть два типа AML-атак:

-

уклонение (evasion), при которых злоумышленник старается вызвать неадекватное поведение уже готового продукта со встроенной в него ML-моделью

-

отравление (poisoning), когда злоумышленник стремится получить доступ к данными и процессу обучения ML-модели, чтобы ее «отравить» (обучить неправильно) для последующей неадекватной работы.

Последние лет пять атаки на системы распознавания образов с помощью тщательно созданных изображений считались забавной, но простой проверкой правильности концепции. Однако группа учёных из университета Аделаиды в Австралии считают, что использование популярных наборов данных изображений для коммерческих ИИ-проектов может создать новую угрозу кибербезопасности.

Чего испугались учёные

Возможно, вы помните статью о проблемах распознавания лиц. Так вот, учёные провели ряд экспериментов по обману ИИ. В ходе одного из экспериментов система распознавания лиц, с высочайшей точностью способная распознать на изображении бывшего президента США Барака Обаму, была введена в заблуждение. С вероятностью 80% она была уверена, что мужчина в тёмном балахоне и с напечатанным изображением цветка также является Бараком Обамой. То, что фальшивое лицо находилось не на плечах, а на уровне груди человека, систему никак не смущало.

Надо отдать должное исследователям, сумевшим создать подобное изображение, способное обмануть нейросеть. Хотя аналогичные прецеденты уже были. Можно вспомнить очки со странным узором, которые позволяли обмануть систему распознавания лиц ещё в 2016 году, или специально созданные изображения, которые пытаются видоизменить дорожные знаки.

Вы же понимаете, что при желании так можно обмануть автопилот, подсунув ему фальшивый дорожный знак или выдать себя за другого человека во время преступления?

Если вам интересно, сверточная нейросеть, атакованная в нашем примере, — это VGGFace ( VGG-16 ), обученная на наборе данных PubFig . Другие образцы атак, разработанные исследователями, использовали разные комбинации объектов.

Распознавание изображений как новый вектор атаки

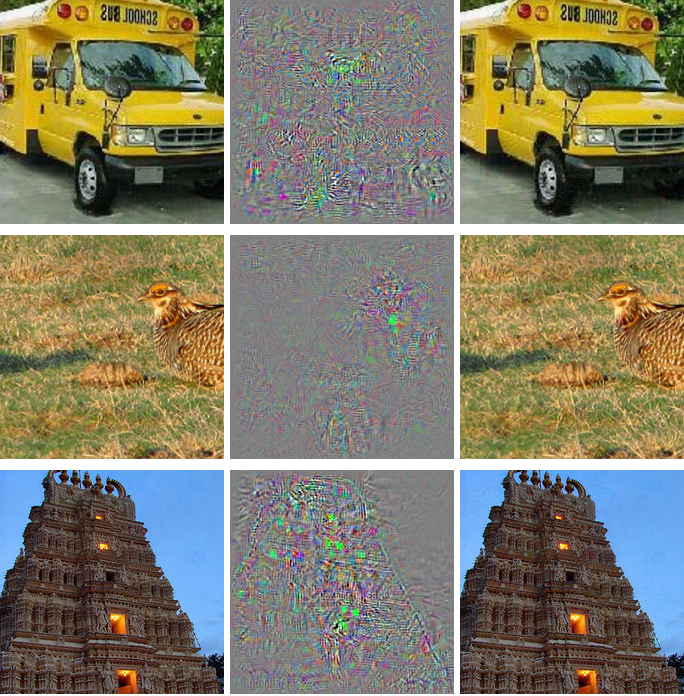

Получается, что нейросеть можно не просто обмануть, можно заставить её считать, что личность А на самом деле — Б. Причём способность вводить в заблуждение подобные системы с помощью созданных изображений очень легко переносится на многие другие архитектуры. Например, все изображения справа распознаются системой как страус:

Примеры, которые приводят учёные в своей работе, отражают уязвимость активно используемой архитектуры разработки ИИ для распознавания изображений. Это не критика отдельных наборов данных или конкретных архитектур машинного обучения, это комплексная проблема. От неё не получится легко защититься путём переключения наборов данных или моделей, переобучения моделей или любым другим аналогичным способом.

Эксплойты команды из Аделаиды иллюстрируют слабость всей нынешней архитектуры систем разработки. Слабость, которая может привести к тому, что многие будущие системы распознавания изображений легко будут обходиться манипуляциям злоумышленников. Потенциал новых атак с использованием состязательных изображений будет неисчерпаем, потому что при создании систем распознавания никто не предвидел появление подобного рода проблем. Так же, как не предполагали компьютерных проблем 2000 года (помните, как это было в 1999?), падения Пизанской башни

Представьте себе, что актуальные образы состязательных атак (таких как цветок на одном из изображений выше), будут добавляться в качестве «уязвимости нулевого дня» в системы безопасности будущего. Примерно так же антивирусы ежедневно обновляют свои вирусные базы.

Состязательные изображения, о которых мы говорим, генерируются при наличии доступа к наборам данных изображений, которые обучили компьютерные модели. Вам не нужен «привилегированный» доступ к обучающим данным (или архитектурам моделей), поскольку наиболее популярные наборы данных (и многие обученные модели) без труда можно скачать с торрентов.

Например, Голиаф среди наборов данных компьютерного зрения, ImageNet, доступен на торрентах во всех его многочисленных итерациях, без его обычных ограничений, позволяя создавать наборы тестов.

Если у вас есть данные, что мешает вам выполнить «реверс-инжиниринг» любого популярного набора данных вроде Cityscapes или CIFAR? Есть и другие датасеты, которые можно использовать. Десятью наиболее популярными наборами данных изображений в компьютерном зрении являются:

-

CIFAR-10 и CIFAR-100 (оба загружаются напрямую);

-

CALTECH-101 и 256 (оба доступны и их можно скачать с торрентов);

-

MNIST (официально доступен, также есть на торрентах);

-

ImageNet (см. выше);

-

Pascal VOC (доступен также есть на торрентах);

-

MS COCO (доступен, также есть на торрентах);

-

Sports-1M (доступен);

-

YouTube-8M (доступен).

Скачать, изучить и найти способ обмануть эти нейросети — вполне выполнимая задача.

Атаки на состязательные изображения становятся возможными не только благодаря практике машинного обучения с использованием опенсорсного подхода, но и благодаря корпоративной культуре разработки ИИ. Повторное использование хорошо зарекомендовавших себя наборов данных компьютерного зрения — вполне обычная практика, ведь реализовать их намного дешевле, чем создавать заново, они хорошо поддерживаются и обновляются.

Вот и получается, что нехватка новых наборов данных, высокая стоимость разработки наборов изображений, зависимость от старых «фаворитов» и тенденция просто адаптировать старые наборы данных — все это усугубляет проблему, поднятую исследователями из Австралии.

Посмотрим, что будет дальше.

Источник: habr.com