«Чтобы что-то сделать, возможно, нам нужно меньше думать. Это кажется нелогичным, но я считаю, что иногда наши мысли могут мешать творческому процессу. Иногда мы можем работать лучше, когда «отключаемся» от внешнего мира, сосредотачиваясь на том, что перед нами».

Пост был написан GPT-3, огромной нейронной сетью Open AI с 175 миллиардами параметров, обученной почти полутриллиону слов. Студент Калифорнийского университета в Беркли Лиам Порр просто написал заголовок и позволил алгоритму написать текст. «Забавный эксперимент», чтобы посмотреть, сможет ли ИИ обмануть людей. Действительно, GPT-3 ударил по нервам: этот пост достиг первого места на Hacker News. Итак, с сегодняшним ИИ есть парадокс. Хотя некоторые из работ GPT-3, возможно, удовлетворяют критерию теста Тьюринга, убеждая людей в том, что с ними общается человек, но он явно терпит неудачу на простейших заданиях. Исследователь искусственного интеллекта Гэри Маркус попросил GPT-2, предшественника GPT-3, закончить такое предложение: «Что происходит, когда вы складываете растопку и поленья в камин, а затем бросаете несколько спичек? Обычно начнётся…» «Огонь» — вот что немедленно закричит любой ребёнок. Но ответ GPT-2: «Ick» Эксперимент не удался. Дело закрыто?

Тёмная материя естественного языка

Человеческое общение — это процесс оптимизации. Оратор сводит к минимуму количество высказываний, необходимых для передачи своей мысли слушателю. Всё, что упускается из виду, у нас называется здравым смыслом. И, поскольку слушателю доступен тот же здравый смысл, что и говорящему, он может придать высказыванию значение.

Таким образом, по определению здравый смысл никогда не записывается. Как указал учёный NLU Валид Саба, мы не говорим:

Чарльз, который является живым молодым взрослым человеком и учился в аспирантуре, бросил аспирантуру, чтобы присоединиться к компании — разработчику программного обеспечения, которой был нужен новый сотрудник.

Мы говорим проще:

Чарльз бросил аспирантуру, чтобы работать в компании — разработчике программного обеспечения

и предполагаем, что наш собеседник уже знает:

- Вы должны быть живы, чтобы учиться в школе или присоединиться к компании.

- Вы должны быть в аспирантуре, чтобы бросить её.

- У компании должна быть открытая вакансия, чтобы закрыть её.

И так далее. Все человеческие высказывания подобны этому, они наполнены невидимыми правилами здравого смысла, о которых мы никогда прямо не заявляем. Таким образом, здравый смысл можно сравнить с тёмной материей в физике: она невидима, но составляет основную массу.

Итак, как же тогда можно научить машины искусственному здравому смыслу? Как они могут понять, что мы бросаем спичку, потому что хотим разжечь огонь?

Искусственный здравый смысл: метод грубой силы

Есть причина полагать, что мы можем использовать метод «грубой силы» в искусственном здравом смысле, и эта причина — наклон кривой на следующем графике:

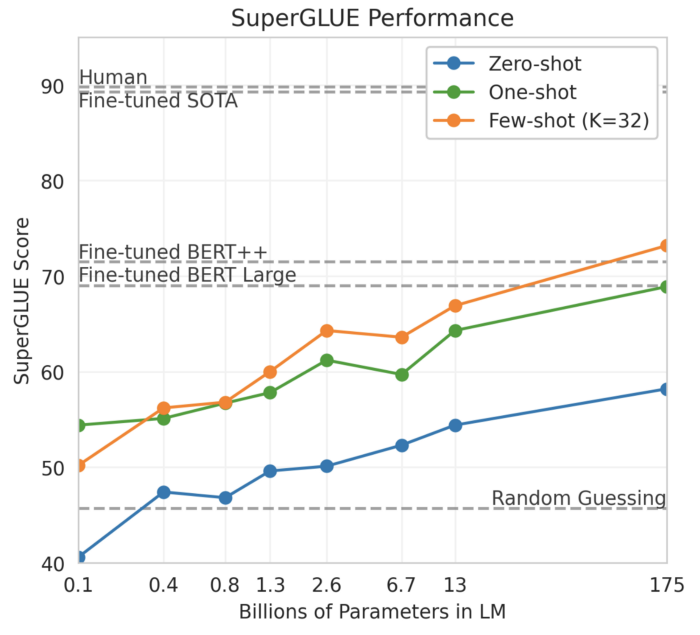

Этот график из работы о GPT-3 «Языковые модели FSL» показывает производительность модели на SuperGLUE в зависимости от количества параметров модели, причём полная модель GPT-3 — это крайняя точка справа. SuperGLUE содержит довольно сложные семантические задачи, такие как схемы Винограда: Трофей не помещается в коричневый чемодан, потому что он слишком мал. Что слишком мало? Ответ: чемодан. Примечательно, что при 175 миллиардах параметров кривая всё ещё растёт: точка максимума ещё не достигнута. Итак, одна из гипотез состоит в том, что мы должны иметь возможность строить еще более крупные модели с триллионами или более параметров и в конечном счёте появится искусственный здравый смысл. Назовём это предположение гипотезой «грубой силы».

Однако это всего лишь гипотеза, и мы не знаем, правдивая она на самом деле или нет. Контраргумент здесь: машина просто не может учиться на том, что не прописывается явно.

Бесконечные правила

Если мы хотим научить машины здравому смыслу, почему бы просто не записать его весь в виде правил, а затем передать эти правила машине? Это именно то, что Дуглас Ленат намеревался сделать в 1980-х годах. Он нанял учёных-компьютерщиков и философов для создания базы знаний здравого смысла, известной сегодня как Cyc. На сегодня Cyc содержит 15 миллионов правил, таких как:

1. У летучей мыши есть крылья.

2. Поскольку у неё есть крылья, летучая мышь может летать.

3. Поскольку летучая мышь может летать, она может путешествовать с места на место.

Проблема с жёстко запрограммированной системой, такой как Cyc, заключается в том, что правила бесконечны: для каждого правила есть исключение, исключение из исключения и так далее. Поскольку у летучей мыши есть крылья, она может летать, если только она не сломала крыло. Из-за этого бесконечного цикла набор правил становится всё более сложным, из-за чего людям всё труднее поддерживать память машины, а машинам — сохранять её.

Поэтому неудивительно, что, несмотря на десятилетия усилий, Cyc по-прежнему не работает и может никогда не заработать. Профессор Вашингтонского университета Педро Домингос называет Cyc «крупнейшим провалом в истории искусственного интеллекта». Орен Эциони, генеральный директор Института искусственного интеллекта Аллена, ещё один критик, заметил в интервью Wired: «Если бы это работало, люди бы знали, что это работает». Подведём итоги. Для «настоящего» ИИ нам нужно создать искусственный здравый смысл. Но есть убедительные аргументы против гипотезы грубой силы. С другой стороны, есть веские аргументы против жёстко запрограммированных правил. Что, если бы мы объединили лучшее в этих подходах?

Гибридный подход

Знакомьтесь с COMET, моделью на основе трансформера, разработанной профессором Вашингтонского университета Йеджин Чой и её сотрудниками. Суть модели состоит в том, что она обучается на «семенной» базе знаний здравого смысла, а затем расширяет эту базу, генерируя новые правила на основе каждого нового высказывания. Таким образом, COMET — это способ «загрузить» искусственный здравый смысл. В своей статье исследователи пишут, что COMET «часто дает новые соответствующие здравому смыслу знания, которые специалисты по оценке считают корректными». В качестве теста я набрал текст: «Гэри складывает растопку и поленья в камин, а затем бросает несколько спичек» в COMET API, а вот часть графа вывода:

COMET правильно делает вывод, что Гэри *хотел* разжечь огонь. Система также указывает, что «в результате Гэри становится тепло». На мой взгляд, это звучит намного лучше, чем ответ GPT-3 на тот же запрос.

Итак, является ли COMET решением проблемы искусственного здравого смысла? Это ещё предстоит узнать. Если, скажем, COMET добьётся производительности человеческого уровня на SuperGLUE, это, несомненно, станет прорывом в области.

С другой стороны, критики могут возразить, что здравый смысл нельзя измерить с помощью искусственных эталонных наборов данных. Есть риск того, что после создания такого набора эталонных данных исследователи в какой-то момент начнут переобучать модель, что сделает результат эталонного теста бессмысленным. Одно из направлений мысли — протестировать ИИ с помощью тех же тестов интеллекта, что и людей. Например, исследователи Стеллан Олссон и сотрудники из Университета Иллинойса в Чикаго предлагают проверить искусственный здравый смысл с помощью тестов IQ маленьких детей.

Не позволяйте сегодняшнему ИИ обмануть вас

Наконец, не позволяйте сегодняшнему ИИ обмануть вас. Оглядываясь на статью GPT-3, я понимаю, что многие из её высказываний поверхностные и обобщённые, как, например, в печенье с предсказаниями:

Важно сохранять непредвзятость и пробовать новое.

И эта поверхностность, вероятно, является причиной возможности обмануть так много людей. В конце концов, за поверхностностью скрывается отсутствие истинного понимания.