Три статьи сотрудников ФКН приняты на конференцию NeurIPS — 2020

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2020-11-02 19:28

34-ая конференция по машинному обучению и нейровычислениям NeurIPS 2020 — одна из крупнейших в мире конференций по машинному обучению, которая проводится с 1989 года. Она должна была пройти 6 — 12 декабря в Ванкувере, но, ожидаемо, была перенесена в онлайн-формат.

NeurIPS всегда пользуется большой популярностью, и в этом году на нее было подано 9 454 статьи, а принято — 1900. Среди них — три статьи сотрудников ФКН:

- "Black-Box Optimization with Local Generative Surrogates" сотрудников лаборатории LAMBDA Владислава Белавина и Андрея Устюжанина.

- "On Power Laws in Deep Ensembles" сотрудников лаборатории компании Самсунг Екатерины Лобачевой, Надежды Чирковой, Максима Кодряна и Дмитрия Ветрова.

- "Towards Crowdsourced Training of Large Neural Networks using Decentralized Mixture-of-Experts" сотрудника лаборатории Яндекс Максима Рябинина.

Мы попросили авторов статей рассказать о своих исследованиях.

Чиркова Надежда Александровна Лаборатория компании Самсунг: Научный сотрудник

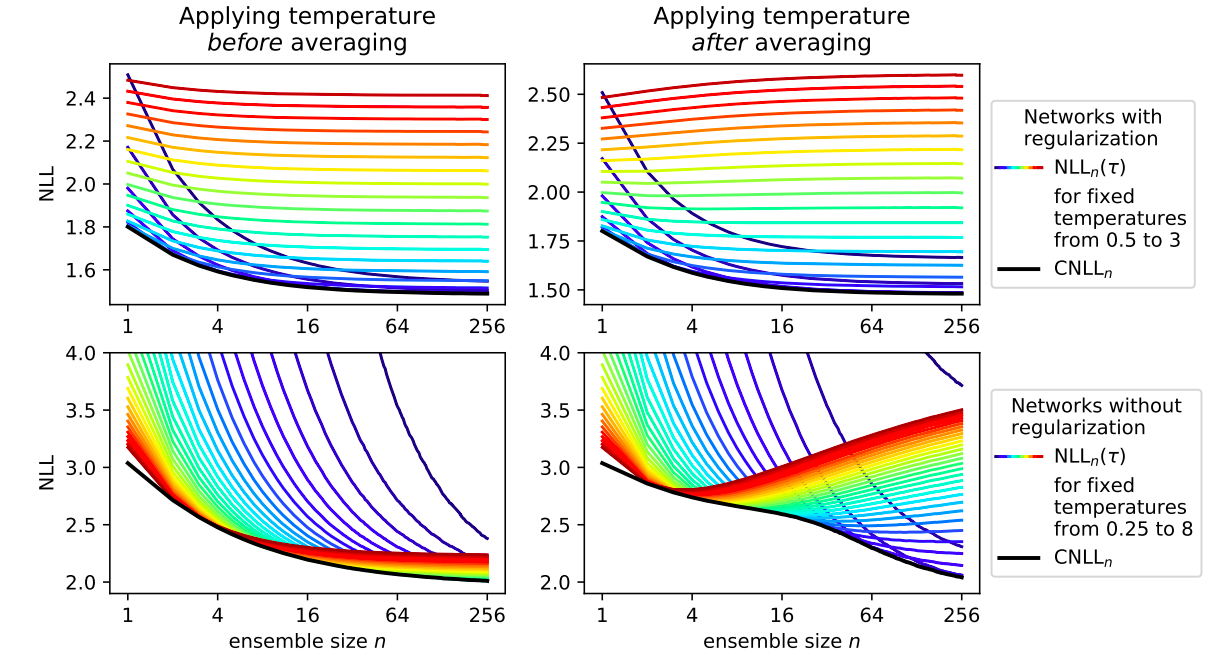

В нашей статье мы изучаем законы, согласно которым меняется качество ансамблей нейронных сетей. Ансамблирование — это простая процедура, подразумевающая обучение нескольких нейронных сетей и усреднение их предсказаний. Усреднение сокращает количество ошибок модели, а также помогает ей точнее оценить, уверена ли она в своих предсказаниях, или лучше отказаться от них и воспользоваться альтернативным источником информации. Например, при распознавании отпечатка пальца в смартфоне модель может в 99% случаев верно распознавать его, а в 1% случаев отказаться от предсказания и запросить у пользователя пароль. Чем больше нейросетей в ансамбле, тем выше качество предсказания, но тем медленнее оно вычисляется. В статье “On Power Laws in Deep Ensembles” мы изучаем, как меняется качество предсказания уверенности ансамбля при увеличении количества нейросетей, а обнаруженный нами закон помогает определить, какое минимальное количество нейросетей нужно, чтобы достичь желаемого уровня качества. При проведении исследования мы активно использовали вычислительные ресурсы Суперкомпьютерного комлекса НИУ ВШЭ.

Екатерина Лобачева, Надежда Чиркова

Устюжанин Андрей Евгеньевич Заведующий научно-учебной лабораторией методов анализа больших данных

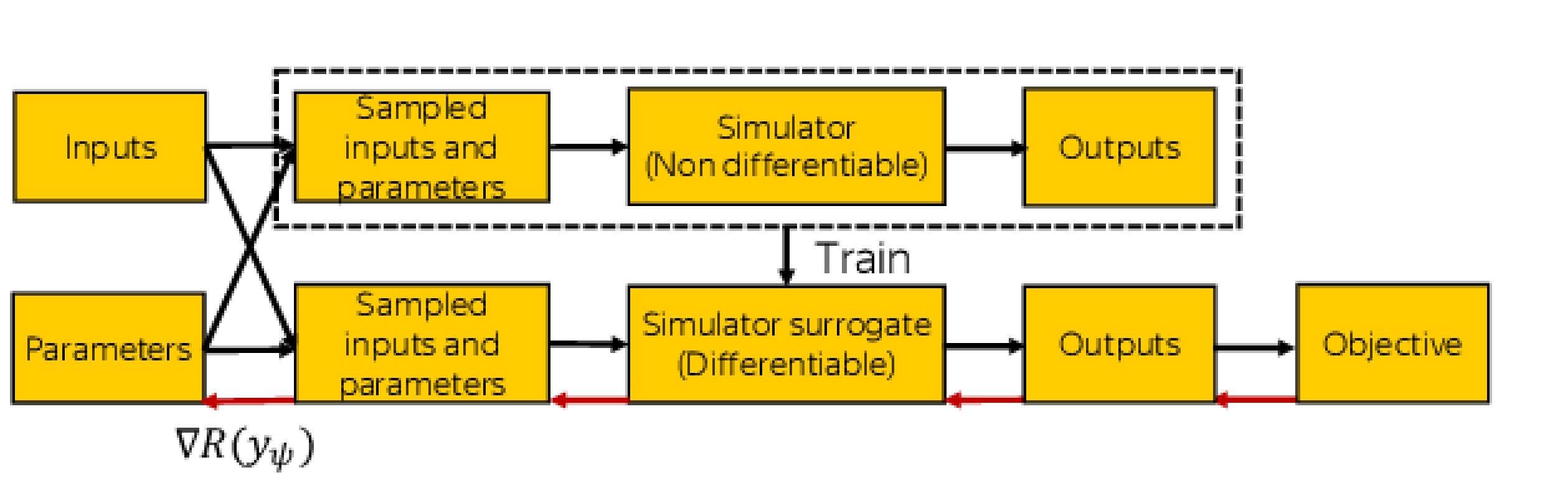

Можно придумать много случаев в естественной физике или инженерных процессах, которые можно смоделировать недифференцируемыми симуляторами с трудноразрешимыми правдоподобиями. Оптимизация этих моделей в пространстве параметров P очень сложна, особенно когда смоделированный процесс стохастичен. Для решения этой проблемы мы представляем глубокие генеративные суррогатные модели для итеративного приближения симулятора в локальных районах пространства параметров Р. Мы работали над этой темой более года: первый раз ее обсуждение началось в неформальной обстановке с коллегами Владом Белавиным, Сергеем Широбоковым (Имперский колледж Лондона), Майклом Каганом (Национальная ускорительная лаборатория SLAC) и Атилимом Гюнеш Байдиным (Оксфорд) на конференции ACAT 2019 в Зас-Фе, Швейцария.

Владислав Белавин, Андрей Устюжанин

Рябинин Максим Константинович Научно-учебная лаборатория компании Яндекс: Стажер-исследователь

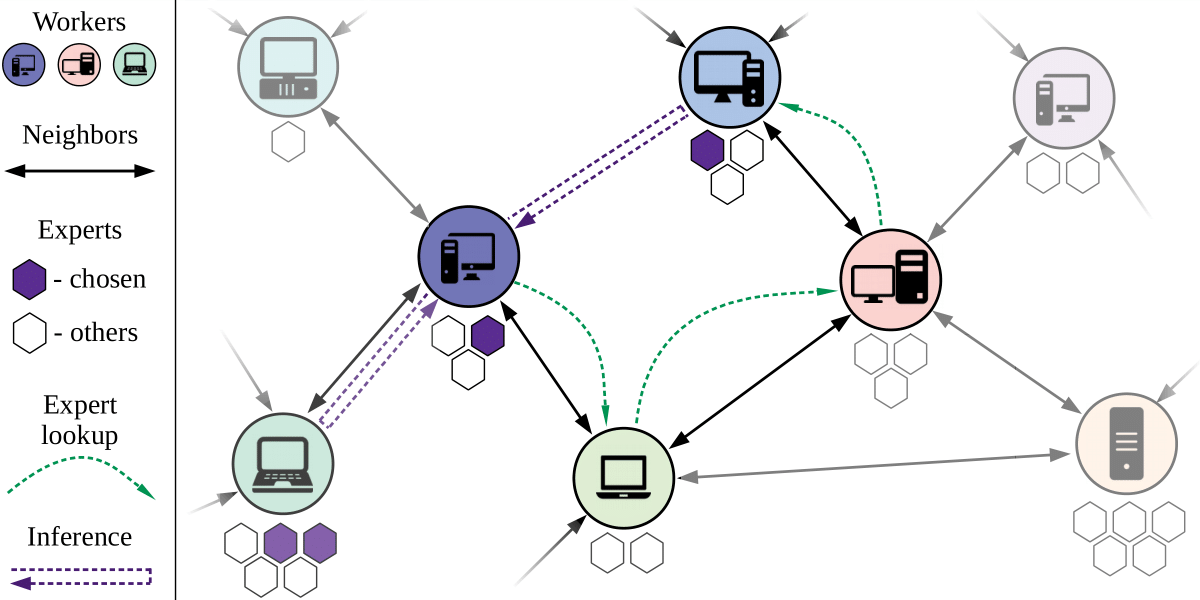

Последние год-два в сфере deep learning наблюдается настоящая гонка вооружений: крупные корпорации (Google, Microsoft, NVIDIA, OpenAI) каждые несколько месяцев бьют рекорды по размеру обученных языковых моделей и демонстрируют, что это приводит к всё более внушительным результатам. Из-за вычислительных затрат обучение таких моделей может стоить миллионы долларов, а сами модели уже содержат столько параметров, что даже разместить их в памяти пользовательских GPU затруднительно. Такой тренд может привести к невоспроизводимости новых результатов в глубинном обучении, а также их недоступности для независимых исследователей и организаций с меньшими ресурсами. В других науках уже научились решать такую проблему: проекты наподобие Folding@home позволяют исследователям использовать свободные вычислительные ресурсы компьютеров волонтёров для решения трудоёмких, но важных проблем в своей области. Нашей целью было предложить аналогичный подход для машинного обучения с учётом специфики задачи и данных, которыми необходимо обмениваться для её решения. Предлагаемый в статье подход позволяет обучать нейросеть на компьютерах участников, соединённых по Интернету, даже если целиком её параметры нельзя поместить на одно устройcтво. Специализированный слой Decentralized Mixture-of-Experts, разработанный нами для такого сценария применения, позволяет стабильно учиться в присутствии больших сетевых задержек или даже потери связи между узлами. В частности, для обеспечения устойчивости мы адаптируем для распределённого обучения распределённые хэш-таблицы — технологию, которая получила популярность благодаря протоколу BitTorrent для обмена файлами. Статью на конференцию мы подавали ещё в июне, рецензии на неё появились в начале августа. Очень обрадовались, когда увидели, что по итогам нашего ответа рецензентам получилось заметно повысить их оценки: скорее всего, благодаря этому работу и приняли.

Максим Рябинин

Источник: cs.hse.ru