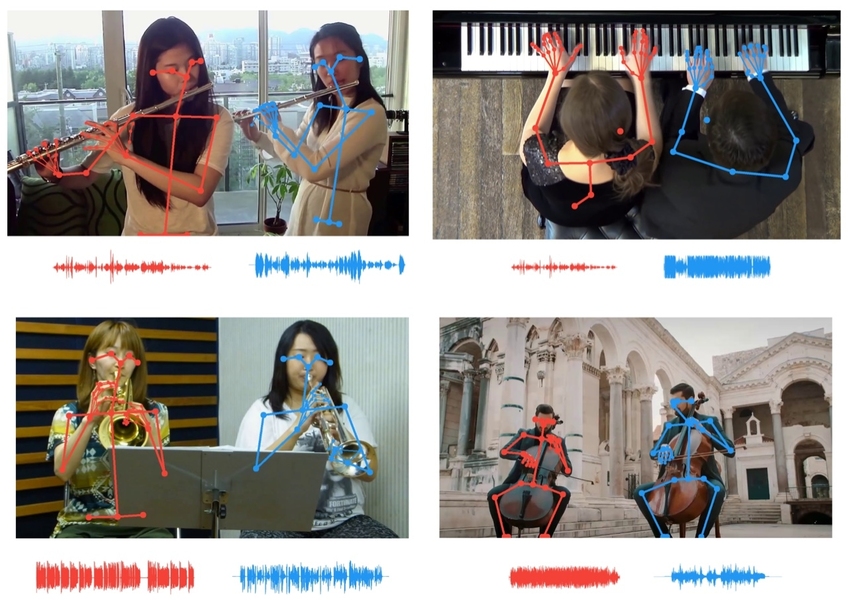

Инструмент распознавания музыкальных жестов на основе искусственного интеллекта, разработанный в MIT-IBM Watson AI Lab, использует движения тела, чтобы различать звуки отдельных музыкальных инструментов.

Исследователи используют данные о ключевых точках скелета, чтобы сопоставлять движения музыкантов с темпом их партии, что позволяет слушателям изолировать инструменты с одинаковым звучанием.

Изображение предоставлено исследователями.

Мы наслаждаемся музыкой не только ушами, но также и глазами, с признательностью наблюдая, как пальцы пианиста летают по клавишам, а смычок скрипача качается на гребне струн. Когда ухо не в состоянии разделить два музыкальных инструмента, нам помогают наши глаза, сопоставляя движения каждого музыканта с ритмом каждой партии.

Новый инструмент на основе искусственного интеллекта разработанный MIT-IBM Watson AI Lab использует виртуальные глаза и уши компьютера, чтобы отделить друг от друга звуки схожие настолько, что человеку сложно их дифференцировать. Инструмент улучшен относительно предыдущих итераций путем согласования движений отдельных музыкантов с помощью ключевых точек их скелета с темпом отдельных партий, что позволяет слушателям изолировать звучание отдельной флейты или скрипки среди нескольких таких же инструментов. Возможные применения для работы варьируются от микширования звука и увеличения громкости инструмента в записи до уменьшения путаницы, которая заставляет людей перебивать друг друга во время видеоконференций. Работа будет представлена ??на конференции Computer Vision Pattern Recognition в этом месяце. «Ключевые точки тела предоставляют мощную структурную информацию», — говорит ведущий автор исследования Чуанг Ган, исследователь в лаборатории IBM. «Мы используем их здесь, чтобы улучшить способность ИИ слушать и отделять звук». В этом и других подобных проектах исследователи использовали синхронизированные аудио-видео треки, чтобы воссоздать способ обучения людей. Система искусственного интеллекта, которая обучается с помощью нескольких сенсорных модальностей, может учиться быстрее, с меньшим количеством данных и без необходимости вручную добавлять надоедливые ярлыки к каждому реальному представлению. «Мы учимся на основе всех наших органов чувств, — говорит Антонио Торральба, профессор MIT и соавтор исследования. «Мультисенсорная обработка — это предшественник воплощенного интеллекта и систем искусственного интеллекта, которые могут выполнять более сложные задачи». Данный инструмент, который использует язык тела для разделения звуков, основан на более ранней работе, в которой сигналы движения использовались в последовательностях изображений. Его самое раннее воплощение, PixelPlayer, позволял кликнуть по инструменту в концертном видео, чтобы сделать его громче или тише. Обновление PixelPlayer позволяет вам провести различие между двумя скрипками в дуэте путем сопоставления движений каждого музыканта с темпом их партии. Эта последняя версия добавляет данные о ключевых точках (которые используют спортивные аналитики для отслеживания результатов спортсменов, для извлечения более детализированных данных о движении), чтобы различать почти идентичные звуки. Работа подчеркивает важность визуальных подсказок в обучении компьютеров, чтобы они могли лучше слышать, и использование звуковых подсказок, чтобы дать им более острое зрение. Точно так же, как текущее исследование использует визуальную информацию о движениях музыканта для разделения партий музыкальных инструментов с похожим звучанием, в предыдущей работе использовались звуки для разделения похожих объектов и животных одного вида. Торральба и его коллеги показали, что модели глубокого обучения, обученные на парных аудио-видео данных, могут научиться распознавать естественные звуки, такие как пение птиц или удары волн о берег. Они также могут определять географические координаты движущегося автомобиля по звуку его двигателя и колес, движущихся к микрофону или от него. Последнее исследование предполагает, что инструменты отслеживания звука могут быть полезным дополнением к беспилотным автомобилям, помогая их камерам в условиях плохой видимости. «Звуковые трекеры могут быть особенно полезны ночью или в плохую погоду, помогая отмечать автомобили, которые в противном случае могли бы быть пропущены», — говорит Ханг Чжао, доктор философии '19, который участвовал в исследованиях касательно отслеживания движения и звука. Другими авторами исследования музыкальных жестов CVPR являются Дэн Хуанг и Джошуа Тененбаум из MIT. На этом все.