Новый инструмент от Google, который помогает разработчикам в сфере NLP. Он позволяет получить детальную информацию о модели, чтобы понимать принципы и возможности работы.

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2020-08-20 18:01

Искусственный интеллект делает очень много вещей очень хорошо, но как именно он делает эти вещи, часто остается неясным — окутанным тем, что стало известно как проблема “черного ящика”. Это особенно верно в НЛП, где исследователи могут тратить много времени, пытаясь выяснить, что пошло не так, когда их модели работают не так хорошо, как ожидалось. На прошлой неделе Google Research опубликовала статью, посвященную этой проблеме с помощью новой аналитической платформы с открытым исходным кодом: The Language Interpretability Tool (LIT).

LIT-это инструментарий и браузерный пользовательский интерфейс (UI) для понимания модели НЛП. Он имеет пять основных функций:

- Поддерживает локальное объяснение, включая карты выделенности, внимание и богатые визуализации предсказания модели

- Поддерживает агрегированный анализ, включая метрики, пространства встраивания и гибкое срезание

- Позволяет плавно переключаться между вышеперечисленными для проверки локальных гипотез и проверки по набору данных

- Позволяет добавлять новые точки данных в любое время и немедленно визуализировать их эффект

Освещенный пользовательский интерфейс

Пользовательский интерфейс LIT написан на языке TypeScript и взаимодействует с бэкэндом Python, в котором размещаются модели, наборы данных, генераторы контрфактов и другие компоненты интерпретации. Учитывая непрерывное развитие моделей НЛП, исследователи Google разработали LIT с пятью принципами:

- Гибкость для поддержки широкого спектра задач НЛП, включая классификацию, seq2seq, языковое моделирование и структурированное предсказание

- Расширяемый, чтобы его можно было перенастроить и расширить для вновь добавленных рабочих процессов

- Модульная конструкция с портативными независимыми компонентами для выбора в зависимости от конкретных потребностей

- Фреймворк agnostic, работает с любой моделью, которая может работать с Python

- Простота в использовании с небольшим количеством требуемого кода

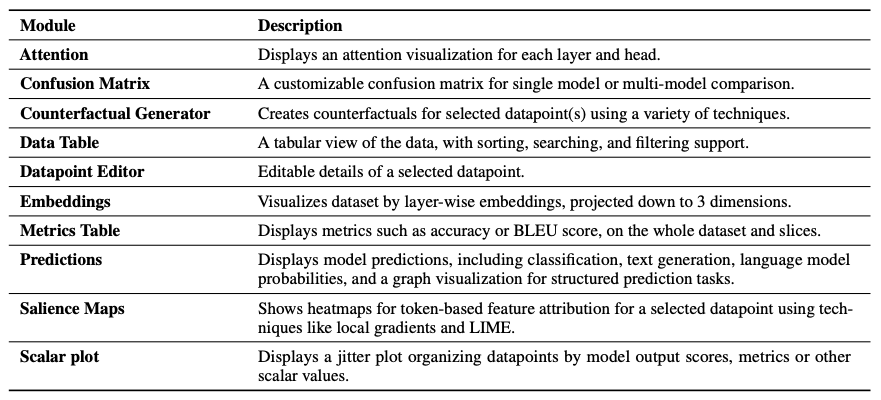

Встроенные модули в освещенном

Исследователи Google отмечают, что их интерактивный инструмент оценки LIT не подходит для мониторинга времени обучения или больших наборов данных.

Бумажные средства языка интерпретируемости: расширяемый, интерактивной визуализации и анализа моделей НЛП по материалам arXiv. Этот инструмент был открыт с открытым исходным кодом на Github.

Источник: bit.ly