В Google создали технологию, которая позволяет рассматривать видео с разных ракурсов

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2020-06-20 14:09

Благодаря использованию нескольких десятков экшн-камер и сверточных нейросетей объемные видеоролики становятся еще более реалистичными.

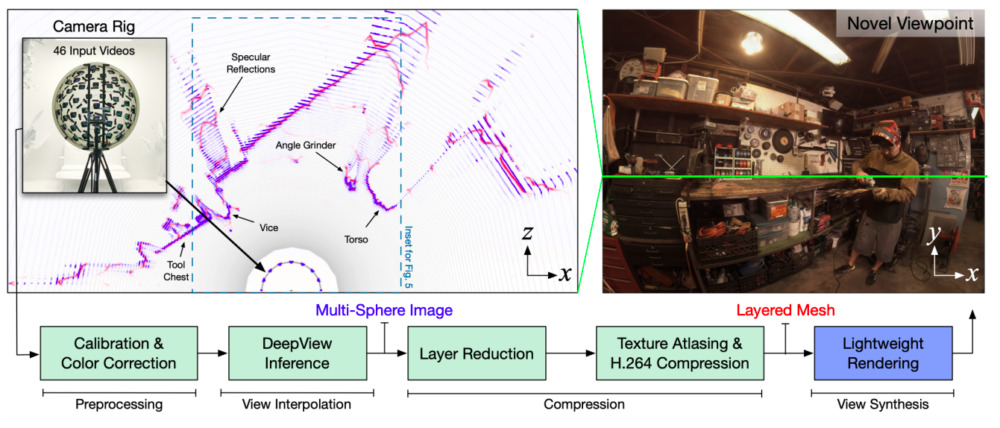

Специалисты Google разработали технологию, которая дает возможность демонстрировать зрителю максимально реалистичное объемное видео. Благодаря полимерной полусфере, на которой расположены экшн-камеры, человек может видеть рассматривать происходящее в видеоролике с разных ракурсов и направлений. Статья об этой разработке будет представлена на конференции SIGGRAPH 2020, запланированной на середину июля.

Человек видит мир объемным благодаря тому, что у него есть два глаза, и зрительная кора мозга получает изображение с двух различных точек в пространстве. А благодаря движениям головы задействуется параллакс движения (проекционные изменения на сетчатке глаза при перемещении в пространстве), и это дает нам возможность оценивать объем и смещение объектов относительно друг друга.

В стереокамерах и шлемах виртуальной реальности бинокулярное зрение воспроизводится благодаря тому, что каждый глаз получает кадры с разного ракурса. Однако параллакс движения воспроизвести при таком подходе невозможно, потому что при съемке камера уже находилась в конкретной точке, и поменять это после уже невозможно.

Инженеры Google работают над решением этой проблемы уже не первый год. Благодаря комбинации аппаратных и программных методов им удалось создать технологию, которая дает возможность рассматривать происходящее на видео как бы с разных точек. Кадры с 46 камер, расположенных на полусферической поверхности, передаются в сверточную нейросеть, которая, в свою очередь, разбивает эти кадры на множество слоев — в зависимости от расстояния до определенного объекта в поле съемки.

Каждое видео разбивается на 160 слоев с разрешением 1800 на 1350 пикселей, после чего эти слои оптимизируются: каждые восемь слоев объединяются с созданием полигональной сетки, а изображение в качестве текстуры накладывается поверх. Полученные текстуры объединяются в текстурный атлас, разрешение которого — 3240 на 5760 пикселей. Таким образом, первоначальный поток данных, в котором каждому кадру соответствует множество слоев, превращается в два отдельных поток: в первом содержатся изображения, которые можно эффективно сжимать, во втором — полигональные сетки.

Используя такой подход, разработчики создали несколько видеороликов, в которых можно менять ракурс передвижениями курсора. Битрейт потока (количество бит, используемых для обработки и передачи данных в единицу времени) при этом находится в диапазоне от 150 до 300 мегабит в секунду. Это дает возможность применять технологию для стриминга реалистичного объемного видео пользователям шлемов виртуальной реальности с гигабитным интернетом.

Ранее мы писали о том, что химики из Токийского университета смогли снять на видео колебания атомов в молекулах фуллерена, а российский ютьюбер при помощи нейросети раскрасил видеосъемку Москвы 1896 года.

Источник: naked-science.ru