Разговорный BERT — учим нейросеть языку соцсетей

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2019-08-09 10:27

От формальной речи — к разговорной

Изначально BERT обучался на 104 языках Википедии (Многоязычный). В дополнение к многоязычной версии Google выпустила BERT на основе английской Википедии и BERT на китайском языке.

В лаборатории нейронных систем и глубокого обучения мы использовали BERT для улучшения NLP-компонентов DeepPavlov — диалоговой библиотеки с открытым исходным кодом для разработки виртуального диалогового помощника и анализа текста на основе TensorFlow и Keras. Мы обучили модель BERT на русской Википедии — RuBERT, значительно улучшив качество русских моделей. И кроме того, интегрировали BERT в решения трех популярных задач NLP: классификация текста, тегирование последовательностей и ответы на вопросы. Более подробно можно прочитать о BERT-моделях DeepPavlov в последних публикациях нашего блога:

- 19 entities for 104 languages: A new era of NER with the DeepPavlov multilingual BERT

- The BERT-based text classification models of DeepPavlov

- BERT-based Cross-Lingual Question Answering with DeepPavlov?

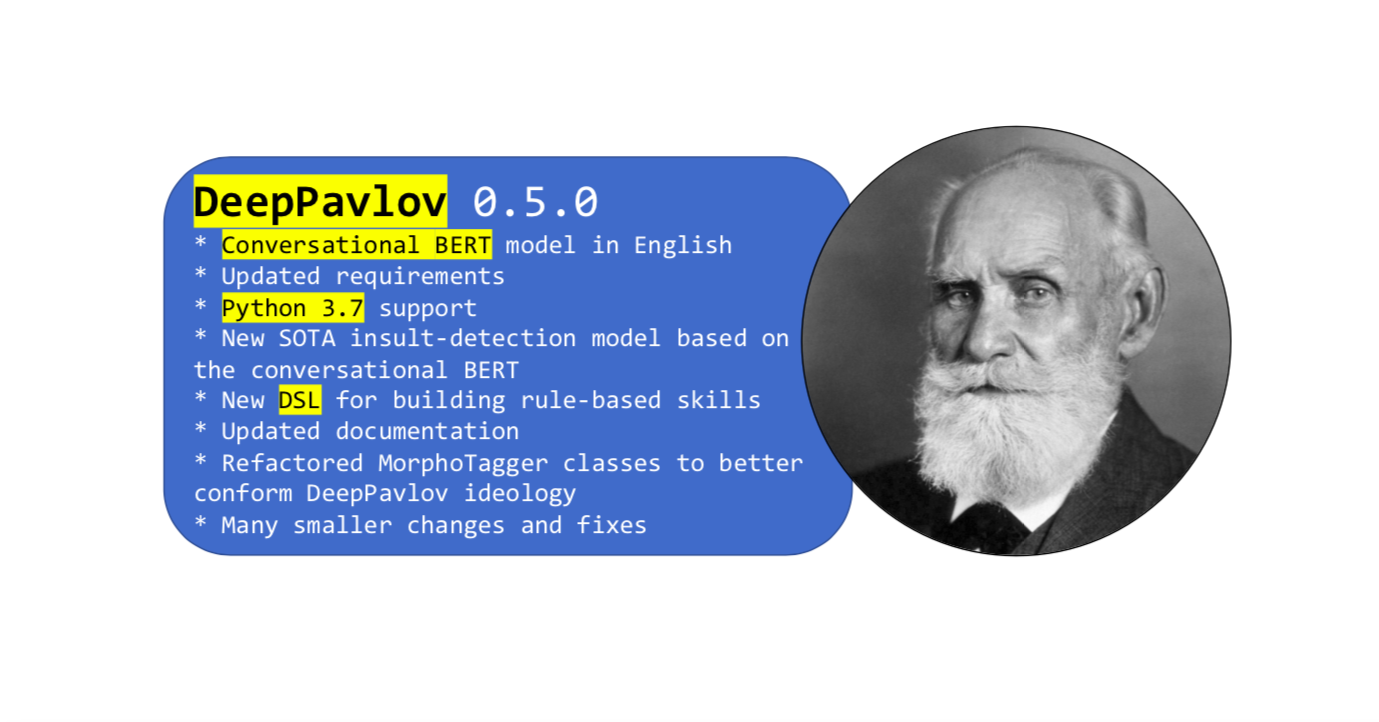

Совсем недавно вышел новый релиз библиотеки

Как использовать Разговорный BERT в DeepPavlov

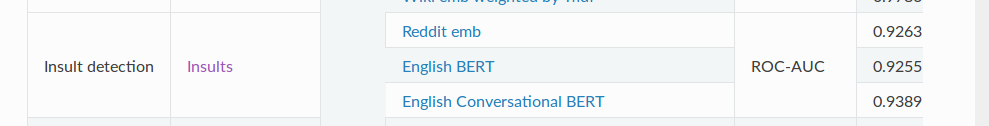

Вы можете использовать новую модель SOTA Insult detection, основанную на разговорном BERT на английском языке [Insults Detection dataset, English Conversational BERT model]. Или любую другую модель на основе BERT, используя простое руководство из документации.

И напоследок

Итак, это почти все, что мы хотели рассказать вам о нашем разговорном BERT. И не забывайте, что у DeepPavlov есть форум – задавайте свои вопросы относительно библиотеки и моделей. Будь в деле!

Источник: habr.com