Сможет ли компьютер распознавать ложь: ИИ против fake-news

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2019-07-25 19:30

Постправда (post-truth) — слово года-2016 по мнению Издательства Оксфордского университета. Постправда — это ситуация, при которой на общественное мнение сильнее влияют не факты, а обращение к чувствам и личным убеждениям людей. В эпоху постправды главным инструментом манипулирования общественным мнением становятся поддельные новости (fake-news). Чтобы не попасться на удочку этих манипуляций, человеку обязательно нужно уметь ориентироваться в информационном потоке и отличать правдивые тексты от заведомо ложных. Сможет ли компьютер и в этом помочь человеку?

Оказывается, сможет. Распознавание лжи в текстах — достаточно молодое, но востребованное и стремительно развивающееся направление в компьютерной лингвистике. Самое сложное в этой задаче — найти корпус новостей, про которые точно известно, правдивые они или лживые. Некоторые исследователи используют корпуса из 150-180 текстов, но при данном размере корпуса очень высока статистическая погрешность, важна аккуратность при интерпретации результатов. Но даже таких корпусов на русском языке очень мало. Мало того что должно быть достоверно известно, правдивый текст или нет, для полной картины также важно, чтобы были указаны пол, возраст, уровень образования и другие данные об авторах: ведь эти характеристики тоже влияют на особенности создания лживых текстов.

Допустим, с этой проблемой справились, и тексты у нас есть. Что делать дальше? Во-первых, можно анализировать используемую в тексте лексику. В этом случае тексты корпуса необходимо сначала подвергнуть автоматической обработке: разметить части речи, выявить эмоционально окрашенные слова, имена (в том числе медиаперсон) и всё это посчитать. Делать эту подготовительную работу лингвистам помогают готовые программы (например, LIWC, MyStem). Дальнейшая задача исследователя заключается в том, чтобы, проанализировав получившиеся данные, определить, какие лексические признаки являются значимыми для классификации. В пилотном исследовании Дины Писаревской, изучавшей тексты новостей из различных онлайн-ресурсов, среди таких маркеров были длина слов, частотность прилагательных, союзов, числительных, цитат, восклицательных знаков и эмоциональной лексики.

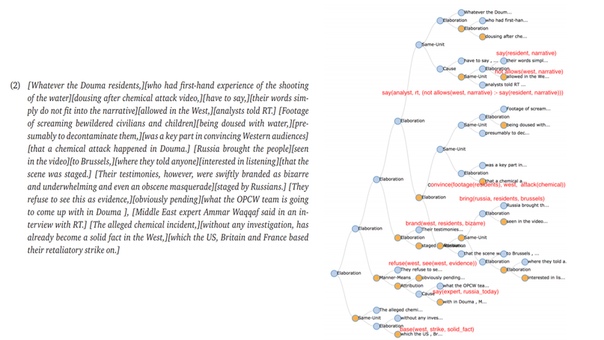

Другой способ — анализ логических связей в тексте. В этом случае в фокусе внимания не отдельные элементы текста (слова или предложения), а сама его структура. Такой анализ основан на теории риторических структур, представляющей текст в виде иерархического дерева, где все фрагменты связаны между собой определёнными отношениями. Создатели теории риторических структур У. Манн и С. Томпсон определили исходный набор риторических отношений, среди которых свидетельство, уступка, детализация, обоснование, условие, антитезис, цель, резюме и другие. Предполагается, что текст лгуна устроен по-особенному. Борис Галицкий и Дина Писаревская, проанализировав корпус из 2764 жалоб клиентов банка, выявили, что в поддельных жалобах больше эмоций и меньше конкретных фактов, доказательств, используются нестандартные цепочки риторических отношений.

Если поддельные жалобы пишут обычные пользователи, которые просто хотят получить материальную выгоду, то в СМИ работают настоящие «профессиональные лжецы»: они умеют писать тексты так, чтобы сделать их максимально похожими на правдивые. Однако и тут теория риторических структур и методы машинного обучения могут прийти на помощь. Вот пример, который приводят в уже упомянутом исследовании Б. Галицкий и Д. Писаревская.

Цель этой статьи (Russia Today, 2018) — опровергнуть обвинение в том, что Сирия использовала химическое оружие весной 2018 года. Убедительным аргументом были бы конкретные наблюдения или факты, которые можно было бы противопоставить обвинению (например, что время предполагаемой химической атаки совпало с сильным дождём), но вместо этого RT описывает сложные психические состояния обвинителей. Основной аргумент статьи состоит в том, что западные представители не были заинтересованы и не хотели слушать свидетельства привезённых в Брюссель жителей Думы, участвовавших в ролике о предполагаемой химической атаке.

Научившись на примере размеченных данных отличать лживые тексты от правдивых, алгоритм может проводить классификацию с точностью с точностью от 68 до 80%. Именно такие результаты показывают последние исследования на русскоязычных текстах. При этом на данный момент исследователи обучают модели основываясь либо на лексическом, либо на дискурсивном уровне. А будущее, очевидно, за комплексным анализом текстов и учётом признаков всех уровней.

Маша Захарова

Источники

- Deception Detection in News Reports in the Russian Language: Lexics and Discourse

- An anatomy of a lie: discourse patterns in ultimate deception dataset

- Классификация текстов по признаку «ложный / правдивый» с использованием методов автоматической обработки текстов

- «Человек врет в двух измерениях»: о роли нейросетей в определении лжи

Источник: m.vk.com