Куда не ступит нога нечеловеческая: почему искусственный интеллект не может заменить человека

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2019-01-24 20:13

Развитие искусственного интеллекта заставляет многих задумываться: «Заберут ли роботы мою работу?» Масштабность этих размышлений вряд ли набирала раньше такие обороты: этот вопрос занимает глобальные организации, обсуждается на форумах уровня Давоса, и именно этой теме — изменение характера труда из-за технологий — посвящен Доклад Всемирного банка о мировом развитии за 2019 год. Эксперты придерживаются взгляда на роботизацию, где люди — всё еще главные:

«Роботы могут дополнять работу тех, кто занимается выполнением задач, не связанных с рутинным трудом и требующих развитых аналитических навыков, навыков межличностного общения или достаточно изощренных навыков ручного труда — например, навыков работы в команде, выстраивания взаимоотношений с клиентами и партнерами, управления персоналом и ухода за детьми и больными. В ходе такой работы людям приходится взаимодействовать друг с другом, опираясь на подразумеваемые знания».

Это значит, что для современного мира и мира ближайшего будущего человеческие взаимодействия первичны, а роботы могут лишь помогать. В глобальном масштабе технологизация, согласно Докладу, не представляет повсеместной угрозы и не приведет к скорой замене человеческого труда. Что не отменяет необходимости готовить граждан к стремительным изменениям в структуре занятости.

Как подколбашивает рынок труда, мы будем наблюдать еще долго. Цифровая трансформация происходит медленно, неравномерно, наталкивается на огромную кучу барьеров — и технологических, и социальных. Автоматизация и роботизация постепенно освобождают от тяжелого труда и создают новые рабочие места, но достижения ИИ разворачиваются на очень разных уровнях и могут вызывать неожиданные социальные эффекты уже сегодня. Так что пока внедрение ИИ в жизнь не только не сталкивает человека на обочину жизни, но и заставляет его развиваться в новых направлениях.

В каких сферах ИИ «конкурирует» с человеком

В конце прошлого года вышло два больших международных отчета про искусственный интеллект — это отчет института AI Now из Университета Нью-Йорка и ежегодник AI Index от инициативной группы из Пало-Альто. Оба показывают, как резко и интенсивно развивается сфера: появляется всё больше специалистов и образовательных программ, компании предлагают новые рабочие места, государственные программы поддерживают исследования в разных направлениях ИИ. Из обоих, независимых друг от друга, отчетов следуют два принципиальных вывода:

- ИИ развивается и интенсивно, и экстенсивно (и внутри своей сферы, и охватывает другие).

- Разработчики, заказчики и пользователи плохо представляют себе последствия такого распространения технологии.

Что это означает для нас? Давайте сначала разберемся, в какие производственные процессы уже встроились алгоритмы ИИ, — в этом поможет профессиональный отчет State of AI. Авторы говорят о 13 отдельных сферах, которые можно поделить на три группы.

1. ИИ выполняет принципиально новые функции, которые не мог делать человек или делал иначе.

В медицине разрабатываются решения по транспортировке микрочастиц; в фармацевтике и материаловедении алгоритмы моделируют новые соединения и просчитывают их устойчивость в различных условиях; в фермерстве используются микроклиматические саморегулирующиеся системы и системы обследования состояния животных и растений; в финансовой сфере внедряются алгоритмы предотвращения мошенничества; спутниковые данные используются для анализа страховых случаев; в сфере автономных разработок развивается симуляция окружающей среды и моделирование чрезвычайных ситуаций. В этих сферах ИИ сопровождает человеческую деятельность и помогает решать проблемы, связанные с масштабами (микро- или макро-), комплексностью и скоростью реализации задач.

2. ИИ по-новому выполняет старые функции, которые всё еще может выполнять человек.

В фармацевтике алгоритмы обрабатывают большое количество данных о химических соединениях, компонентах, реакциях для улучшения существующих лекарств; в здравоохранении анализ визуальных данных уточняет диагностику заболеваний; в фермерстве настраивается контроль теплиц и сбор урожая; в финансовой сфере алгоритмы принимают решения о кредитовании и предлагают финансовый менеджмент; в автоматизации складов роботизируется логистика и управление; в промышленном производстве ИИ организует труд; в автономной логистике предпринимаются попытки решить проблему «последней мили» (доставки до точного места или конкретного человека); спутниковые данные помогают планировать сельскохозяйственникам; в государственной безопасности применяются комплексные алгоритмы анализа данных о гражданах. В основном функции ИИ в этой группе связаны с накоплением и обработкой больших данных для последующего принятия решений человеком.

3. ИИ заменяет работу человека.

В промышленном производстве распространяется автоматизация рутинной работы и документооборота;

ручная работа

частично роботизируется в строительстве, промышленной уборке, охране; в сфере приватности и анонимности алгоритмы используются в защите персональных данных; в логистике транспорт становится автономным; в кибербезопасности алгоритмы отслеживают угрозы.

В этой группе ИИ действительно берет на себя функции человека, но не заменяет человеческий труд вообще. Мы видим, что разработки не становятся независимыми сущностями, а постепенно и аккуратно способствуют освоению новых областей знания.

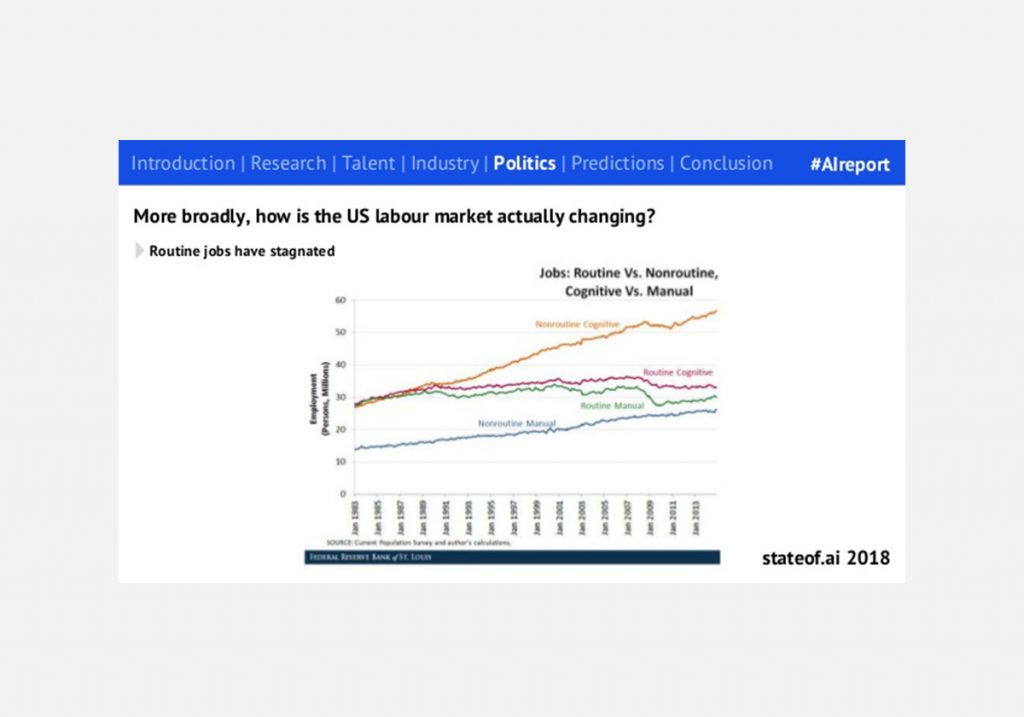

Реальная динамика изменения на рынке за последние 35 лет в США показывает, что лишь немного сокращается доля рутинного труда — как ручного, так и умственного, и при этом настойчиво набирает обороты нерутинная ручная и интеллектуальная занятость:

Ту же логику можно увидеть на ресурсе-предсказателе, где можно узнать вероятность и причины потенциальной роботизации конкретной специальности.

Первыми будут автоматизированы те работы, где больше всего рутины и повторяющихся задач, меньше неизвестности и неопределенности — так называемые скучные работы: ремонтники часов, швеи, телепродавцы, составители налогов и т. д. Этот труд легко стандартизировать и воспроизвести алгоритмически.

А меньше всего подвержены алгоритмизации такие специалисты, как, например, социальные работники, психологи, социологи, поскольку они выполняют ту тонкую аналитическую и эмоциональную работу, которую не делегировать алгоритмам.

Почему алгоритмичный «ум» ИИ не может заменить человека

Обнадеживающе звучит второй пассаж из Доклада Всемирного банка:

«Дизайн, создание произведений искусства, проведение исследований, руководство командной работой, уход за больными и уборка — это задачи, которые, как выяснилось, слишком сложны для автоматизации. Роботам пока не удалось добиться больших успехов в воспроизведении этих навыков, чтобы конкурировать с людьми».

Это не значит, что «машинного» искусства или роботизированной уборки еще нет, скорее, речь идет о том, что ИИ куда сложнее конкурировать с человеком в областях, которые связаны с комплексным трудом, непредсказуемостью, разноплановой аналитической работой или простой эмпатией.

Возможности ИИ сразу становятся ограниченными в работе с эмоциями и чувствами, в проявлении понимания, в определении неочевидного смысла и спонтанной изменчивости.

Свежая статья в Nature предлагает одно из объяснений ограничениям, с которыми неизбежно сталкивается ИИ: в основе машинного обучения лежат формализация и математический анализ — а у них есть свои неразрешенные проблемы. В некоторых сценариях машинного обучения невозможно доказать, может ли алгоритм решить конкретную задачу, и это упирается в математические задачи (в частности, в континуум-гипотезу). Нельзя доказать или опровергнуть, что алгоритмы, обучающиеся на больших наборах данных, смогут одинаково хорошо работать на разных выборках. Тем более что не все данные хорошо формализуются.

Что алгоритмы уже умеют делать, так это воспроизводить то, чему они обучаются, не вникая в смысл, а размечивая «да» или «нет». Именно поэтому им не присуще чувство юмора, хотя они могут «сочинять» музыку. Секрет такого творчества очень схож с изобретательством алгоритмов, которые обыгрывают в шахматы и го или даже в Dota 2. Но та же AlphaZero не может научиться другим играм, кроме го, потому что правила уже не настолько прозрачны.

Последующее поражение ИИ в Dota 2 показало, что алгоритмы всё-таки не способны пока на командную работу с ее спонтанной коммуникацией и разделением обязанностей.

То же показал и случай роботизированного отеля Henn-na в Японии: спустя 3 года руководство приняло решение «уволить» больше половины роботов из-за жалоб клиентов о том, что они не справляются со своими задачами. Кроме того, они были дорогими в обслуживании в обновлении, что оказалось экономически невыгодным.

Алгоритмы действительно считывают и воспроизводят правила лучше людей, поэтому их соблюдение — самая оптимальная стратегия, касается ли это высчитывания ходов или джазовых канонов. Именно поэтому музыка ИИ — это вариация на тему правил и формализации. Иными словами, нейронные сети воспроизводят паттерны, которые лучше всего справляются с поставленной им задачей. Но о красоте, изящности и «настоящести» этих паттернов дальше судить нам.

Поэтому вопрос с машинным искусством не в том, считать ли то, что делают алгоритмы, искусством, — а будем ли мы получать такое же удовольствие от него, как, скажем, на живых джазовых импровизациях.

Что пугает разработчиков, или Механизмы принятия решений ИИ

Игры с возможностями ИИ вызывают серьезные вопросы. Далеко не во всех областях мы готовы впускать алгоритмы в производственные процессы — и уж точно не в управление или принятие жизненно важных решений. В этом смысле искусственный интеллект беспокоит разработчиков не меньше, чем простых людей. В этом признались эксперты — авторы отчета Исследовательского института AI Now в Университете Нью-Йорка за 2017 год. Основное беспокойство вызывают черные ящики, которые создают закрытые алгоритмы внутри себя. Проблема с черными ящиками называется проблемой объяснимости ИИ

. Когда чат-боты Facebook столкнулись с барьером — не получили одобрения от операторов-людей, — то стали обходить его, придумывая новые запросы. Разработчики обнаружили диалог ботов, в котором слова ничего не значили с точки зрения человека, но в нем боты скооперировались с неясной целью. Ботов отключили, но осадочек остался.

Алгоритмы находят неожиданные возможности там, где человек не предусматривает жесткие ограничения: они ведут себя как хакеры и ищут оптимальные решения задач. Это происходит и в игровых вселенных: например, в EVE Online алгоритмы устроили альтернативную добычу ресурсов, не вступая во взаимодействие с другими игроками, поскольку их стратегия оказалась наиболее выигрышной с точки зрения теории игр, а не с позиции командной работы.

Новые случаи независимого поведения алгоритмов усиливают тревогу, особенно из-за стремления разработчиков дать ИИ право на самостоятельное принятие решений. И если в играх, социальных сетях и творчестве ошибки еще могут быть незаметны или безболезненно исправлены, то риски применения ИИ в сферах, связанных с благополучием человека, требуют очень большого внимания и прозрачности алгоритмов. Проблема объяснимости сводится к вопросу о том, как ИИ на самом деле принимает решения.

Этим вопросом активно занимаются разработчики беспилотных автомобилей, экспериментируя с квантификацией этики, доверия и морали. И такие эксперименты еще легитимны, пока потенциальные риски могут быть оправданы стечением обстоятельств — например, смерть пешехода по вине самого пешехода легко укладывается у нас в голове. Но риски перестают быть оправданными совсем, когда человек (и не один!) может пострадать только по вине технологии.

Именно поэтому искусственный интеллект не будет в обозримом будущем допущен к управлению самолетами в автономном режиме. Авиация — отличный пример сферы, в которой требуется высокая точность в процессе принятия решений, поскольку риски слишком высоки. Борьба ответственностей ярко показана в фильме «Чудо на Гудзоне»: ставший легендарным пилот умудрился посадить самолет с отказавшими двигателям на воду без жертв, и впоследствии его обвиняли в том, что он поступил не по протоколу, так как математически были просчитаны альтернативные решения с посадкой в близлежащих аэропортах. Но в суде никому из экспертов и следователей этого авиапроисшествия не удалось найти все элементы формулы под названием «пилот в экстренной ситуации» для компьютерной симуляции. Посмотрите защитительную речь героя о том, что в реальной ситуации математических расчетов недостаточно: чтобы оценить все риски и возможности и принять оптимальное решение, на помощь приходят опыт, интуиция и вера.

ИИ может справиться со штатными ситуациями, и их подавляющее большинство. Но где ему учиться на чужих ошибках и искать идеальные сценарии и решения в чрезвычайных условиях, которые никогда не повторяются? Получается, что основное ограничение на доступ алгоритмов в системы управления получат те сферы, где требуется прозрачность процесса принятия решений и последующее объяснение своих действий.

К этим внутренним проблемам разработки теперь добавляется новое математическое ограничение: мы не можем предсказать заранее, с какими задачами ИИ справится, а с какими нет.

Политические проблемы использования ИИ

Помимо проблем самой разработки, стоит следить за применением ИИ, потому что в конечном счете в возможных перегибах будет виновата не сама технология, а те, кто стоит за ее использованием. В гонке за использование технологии разные участники преследуют разные цели — но, к сожалению, мало для кого цель — это подготовить ИИ и общество друг к другу. Вместо того чтобы бояться потерять работу, впору задуматься о том, что важно для всего человечества.

Только в прошлом году индустрия серьезно подошла к вопросам социальных эффектов и последствий внедрения ИИ. Отличилась Microsoft в попытке сформулировать вопросы о возможных сценариях будущего ИИ и о важных рекомендациях для его настоящего.

Даже если рано или поздно ИИ внедрится во многие сферы жизни человека, уже сейчас необходимо понимать, что технологии не решат все проблемы человечества и что мы сами должны думать о таких вещах, как этика или право.

Теперь комитеты по этике есть в Microsoft, Google, Facebook, SAP — это своеобразная внутренняя цензура потенциальных рисков ИИ.

Комитеты по этике подчеркивают, что технологии — дело рук и ответственность не только разработчиков, но и всех участников глобального взаимодействия, как конечных пользователей, так и институциональных игроков: бизнеса, государства, общества. Если кто-то из этих участников принимает решение использовать ИИ в своих целях, то он должен принять на себя обязательство предусматривать последствия. А если эти последствия не удается предсказать, требуется собирать как можно более междисциплинарные команды экспертов, которые покажут всю сложность тех или иных технических решений.

Звучит неплохо, но сейчас далеко не все участники гонки за лидерство в технологиях готовы оценивать реальные социальные эффекты своей деятельности, особенно если технологии поддерживают текущие политические режимы.

«Мы на самом деле не забегаем настолько далеко вперед, чтобы узнать, будет ли ИИ конфликтовать с людьми. Мы просто пытаемся заработать деньги», — сказал Тан Сяоу, профессор Китайского университета в Гонконге, основатель одного из самых нашумевших ИИ-стартапов по технологии распознавания лиц.

Социальный рейтинг, основанный на этой технологии, очень быстро стал инструментом тотального контроля и создал новую социальную структуру и общественный порядок в одной отдельно взятой авторитарной стране.

Такое будущее, в котором технологии ничему не учат ни разработчиков, ни пользователей, а оказываются реализацией сценариев «Черного зеркала», — действительно вызывает страх. Под прикрытием, например, государственной безопасности такой ИИ может дотянуться куда угодно, поэтому мировые эксперты теперь хотят снизить уровень тревожности и внести в повестку: технологическую, идеологическую, политическую — необходимость учитывать разнообразие того общества, в котором этому ИИ предстоит жить и социализироваться.

Этические проблемы выходят на первый план

Технологии не помогут решить социетальные проблемы, они, скорее, будут только по-новому проявлять существующие напряжения и конфликты, заодно создавать новые (например, типы неравенства). ИИ это касается особенно, потому что как бы он ни обучался, обучаться он будет у всех пользователей и подстраиваться под цели без определенной оценки.

Вот несколько примеров ошибок или смещений из того же профессионального отчета State of AI. Они более релевантны американскому контексту, но много говорят о тех данных, на которых учатся машинные алгоритмы:

- на запрос CEO поисковик на первой странице результатов по картинками выдает «белых» мужчин;

- распознаватель фото Google маркирует темнокожих как «горилла»;

- функция YouTube-перевода голоса в текст не распознает женские голоса;

- камеры распознавания лиц HP не могут распознавать азиатов;

- Amazon классифицирует литературу по тематике ЛГБТ в категорию «18+» и убирает из рейтингов продаж;

- запросы имен, звучащих как афроамериканские, выдают рекламу на проверку криминального прошлого.

Среди причин таких смещений разработчики называют стереотипы, которые наиболее распространены в сети, ошибки распознавания изображений (и их категоризацию), слабую представленность в базах данных и в сети вообще.

То есть «виноватыми» оказываются и недоработанные алгоритмы, и смещенные данные, на которых обучаются эти алгоритмы. Такие ошибки становятся всё более и более системными из-за неконтролируемого потока собираемых данных, а их обработка требует не только обновления вычислительных мощностей, но и новых принципов работы как с базами, так и алгоритмами.

Голосовые помощники могут очень быстро становиться расистами, сексистами и матерщинниками.

Иногда и политически настроенными: первые возмущения по поводу голосового помощника Алиса от «Яндекса» были, среди прочего, связаны с тем, что ее персонажу меняют политические взгляды по необходимости. Поэтому разработчикам быстро пришлось влезать в нейросеть «руками» и устанавливать какие-то границы и нормы того, что должен или не должен делать голосовой помощник. Голосовые помощники — еще одно напоминание о том, что ИИ (как и любая технология) может быть использована не по тому разумному и доброму предназначению, о которой мечтали ее первые разработчики.

Проблема осознанного использования достигла такого масштаба, что даже в отчете AInow за 2017 год из 10 рекомендаций по дальнейшему развитию ИИ половина касается социальных и этических аспектов. Особенно алармистски, требовательно звучит призыв кооперироваться с социальными учеными, потому что «ИИ развивается не в вакууме». О чем же эти рекомендации?

Смещения в данных влияют на настройку и работу алгоритмов, поэтому отдельной задачей разработчиков становится проверка стандартов для обработки и устранение причин ошибок в данных. Но при этом надо избегать техноцентристского стремления упростить и категоризовать все социальные явления, а учитывать особенности различных обществ. Так, в алгоритмах сейчас слабо отражено разнообразие социальных групп (женщины, меньшинства и т. п.), редкие и частные социальные феномены.

Чтобы в алгоритмах появлялись более тонкие настройки, надо убедиться в том, что эксперты из неинженерных областей тоже влияют на принятие технических решений и далее сопровождают их внедрение с учетом культурных и этических принципов.

Разработчики продолжают стремиться сделать ИИ «человечнее», социализировать его правильно. Одна из самых известных профессиональных ассоциаций инженеров IEEE подробно изучает вопрос этических рекомендаций для ИИ-специалистов.

Они советуют разработчикам в процессе производства технологий думать не только над решением технических задач, но и понимать причины и последствия своей деятельности. В этом смысле комментарий Тан Сяоу противоречит логике осознанного производства: технологии не просто создаются, чтобы заработать денег, они точно будут вызывать социальные эффекты (в случае китайской системы — поддерживать и укреплять тоталитарное государство или даже развязать новую технологическую гонку).

В своих рекомендациях IEEE обратились к колыбели незападных ценностей и этических концепций, таких как буддизм или конфуцианство, чтобы расширить мировоззрение разработчиков, обратить их внимание на собственные культурные принципы, которые неосознанно и по умолчанию закладываются в технологии.

В попытках преодолеть технократический подход к развитию ИИ они предлагают учитывать то, как по-разному этические вопросы решаются в разных (со)обществах, включая социально-ориентированные НКО. IEEE привлекают разных участников к разработке рекомендаций, чтобы у представителей разных групп была возможность озвучить свои предложения и предостережения в отношении развития ИИ.

Этот тренд существенно усложняет дело разработчиков, потому что добавляет такое же бесконечное количество неизвестных переменных в алгоритмы, с которым пытаются справляться социальные ученые в своей профессиональной деятельности — да и люди в своей повседневности.

Даже если разработчики начнут очень активно ориентироваться на такие рекомендации, это существенно усложнит разработку в сфере ИИ вообще, ведь в общественных процессах огромное количество неизвестных, плохо учитываемых и никак не прогнозируемых факторов.

Тем ценнее окажутся человеческие сферы ответственности, связанные с навыками общения, командной работы, моралью и нравственностью, а также духовными ценностями. Технофобам и технореалистам это дает надежду на то, что не всё окажется под властью ИИ, даже после достижения точки сингулярности. А это значит, что человек еще долго будет тут за старшего.

Источник: knife.media