Корелляция аудио и видео повысила точность распознавания эмоций в сложных условиях

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2019-01-18 14:10

Ученые из Китая разработали алгоритм распознавания эмоций, который анализирует корреляции в выражении лица и спектрограмме речи. Распознавать эмоции сложно, потому что люди по разному их проявляют, например, из-за особенностей темперамента, но анализ звуковых паттернов способен улучшить результаты. Точность распознавания в сложных условиях достигла 62.48% и превзошла современные результаты на датасете Emotion Recognition in the Wild Challenge.

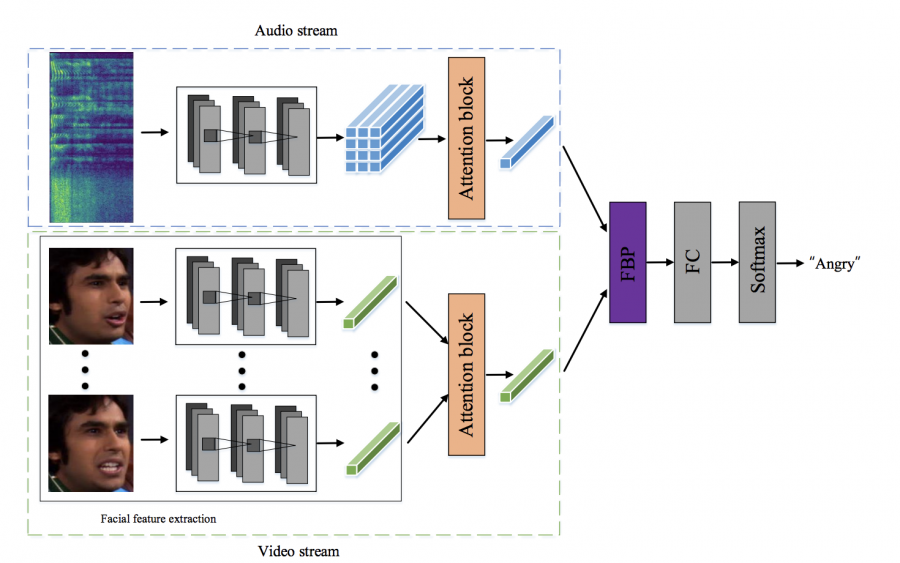

Метод Deep Fusion

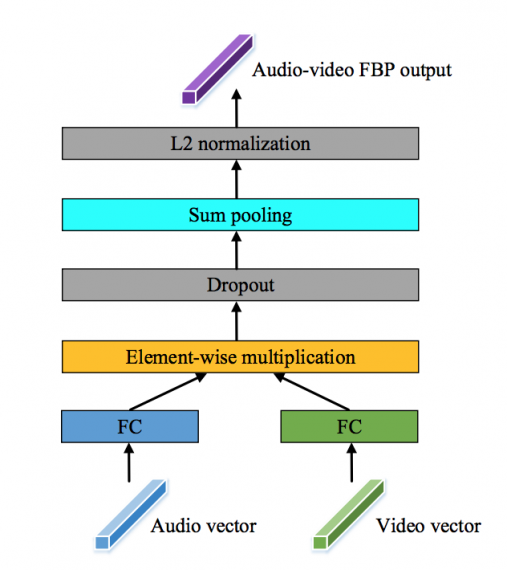

Модель распознавания Deep Fusion, предложенная Юаньюань Чжан, Цзы Жуй Ван, Цзюнь Ду из Научно-технического университета Китая, содержит несколько компонентов. Сверточная нейронная сеть для распознавания эмоций по речи с механизмом внимания, которую ранее предложили авторы, выделяет области на спектрограмме, которые соответствуют проявлениям эмоциям. Механизм внимания реализован и для видео — нейронная сеть помечает кадры, которые отражают эмоциональное состояние. Видеокадры с лицами пропускаются через сеть распознавания лиц и три нейросети для распознавания эмоций. Авторы назвали свой метод сопоставления признаков видео и аудио Factorised Bilinear Pooling (FBP).

На последнем шаге извлекаются признаки проявления эмоций из видео и объединяются с признаками алгоритма распознавания речи, чтобы уловить корреляции между ними для окончательного предсказания эмоций.

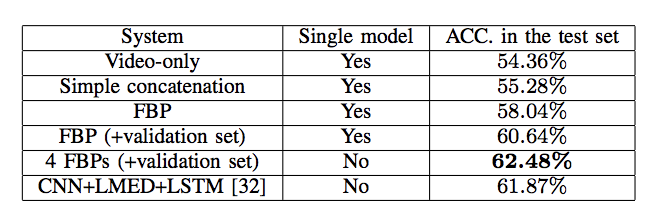

Результаты

Для обучения модели команда использовала 653 видео из набора AFEW8.0, который содержит записи фильмов и телевизионных шоу. В результате алгоритм научился классифицировать 7 видов эмоций: злость, отвращение, страх, счастье, спокойствие, грусть, удивление. Сеть показала точность распознавания 62,48% на проверочном наборе из 383 образцов.

Модель лучше распознавала эмоции, которые имеют очевидные характеристики, например злость, счастье и спокойствие. Отвращение и удивление распознавалось сложнее, так как их можно легко спутать с другими эмоциями. В тоже время отличительная особенность разработки в том, что модель учитывала связь между речью и выражением лица при распознавании. Результаты все еще далеки от идеала.

Источник: neurohive.io