Почему искусственный интеллект не решит всех проблем

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2018-07-12 08:48

Вера во всемогущество ИИ

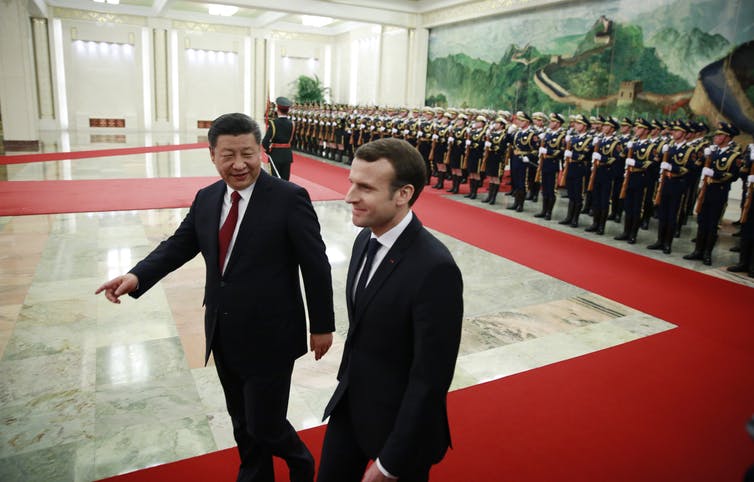

Всего за несколько лет вера во всемогущество ИИ пробралась из разговоров технологических евангелистов Кремниевой долины в умы представителей правительств и законодателей всего мира. Маятник качнулся от антиутопического представления об уничтожающем человечество ИИ к утопической вере в пришествие нашего алгоритмического спасителя. Мы уже видим, как правительства обеспечивают поддержку национальным программам развития ИИ и соревнуются в технологической и риторической гонке вооружений, чтобы получить преимущество в бурно растущем секторе машинного обучения (МО). К примеру, британское правительство пообещало вложить ?300 млн в исследования ИИ, чтобы стать лидером этой области. Очарованный преобразовательным потенциалом ИИ, французский президент Эмманюэль Макрон решил превратить Францию в международный центр ИИ. Китайское правительство увеличивает свои возможности в области ИИ с помощью государственного плана по созданию китайской ИИ-индустрии объёмом в $150 млрд к 2030 году. Вера во всемогущество ИИ набирает обороты и не собирается сдаваться.

Нейросети – легче сказать, чем сделать

В то время как многие политические заявления расхваливают преобразующие эффекты надвигающейся "революции ИИ", они обычно недооценивают сложности внедрения передовых систем МО в реальном мире. Одна из наиболее многообещающих разновидностей технологии ИИ – нейросети. Эта форма машинного обучения основывается на примерном подражании нейронной структуры человеческого мозга, но в гораздо меньшем масштабе. Многие продукты на основе ИИ используют нейросети, чтобы извлекать закономерности и правила из больших объёмов данных. Но многие политики не понимают, что просто добавив к проблеме нейросеть, мы не обязательно тут же получим её решение. Так, добавив нейросеть к демократии, мы не сделаем её мгновенно менее дискриминированной, более честной или персонализованной.

Бросая вызов бюрократии данных

Системам ИИ для работы нужно огромное количество данных, но в госсекторе обычно не бывает подходящей инфраструктуры данных для поддержки передовых систем МО. Большая часть данных хранится в офлайн-архивах. Небольшое количество существующих оцифрованных источников данных тонут в бюрократии. Данные чаще всего размазаны по различным правительственным департаментам, каждому из которых для доступа требуется особое разрешение. Кроме всего прочего, госсектору обычно не хватает талантов, оснащённых нужными техническими способностями, чтобы в полной мере пожать плоды преимуществ ИИ. По этим причинам связанный с ИИ сенсационализм получает множество критики. Стюарт Рассел, профессор информатики в Беркли, давно уже проповедует более реалистичный подход, концентрирующийся на простейших, повседневных применениях ИИ, вместо гипотетического захвата мира сверхразумными роботами. Сходным образом профессор робототехники из MIT, Родни Брукс, пишет, что «почти всем инновациям в робототехнике и ИИ требуется гораздо, гораздо больше времени для реального внедрения, чем это представляют себе как специалисты в этой области, так и все остальные». Одна из множества проблем внедрения систем МО состоит в том, что ИИ чрезвычайно подвержен атакам. Это значит, что злонамеренный ИИ может атаковать другой ИИ, чтобы заставить его выдавать неправильные предсказания или действовать определённым образом. Многие исследователи предупреждали о том, что нельзя так сразу выкатывать ИИ, не подготовив соответствующих стандартов по безопасности и защитных механизмов. Но до сих пор тема безопасности ИИ не получает должного внимания.

Машинное обучение – это не волшебство

Если мы хотим пожать плоды ИИ и минимизировать потенциальные риски, мы должны начать размышлять о том, как мы можем осмысленно применить МО к определённым областям правительства, бизнеса и общества. А это значит, что нам необходимо начать обсуждения этики ИИ и недоверия многих людей к МО. Самое важное, нам нужно понимать ограничения ИИ и те моменты, в которые люди всё ещё должны брать управление в свои руки. Вместо того, чтобы рисовать нереалистичную картину возможностей ИИ, необходимо сделать шаг назад и отделить реальные технологические возможности ИИ от волшебства. Долгое время Facebook считала, что проблемы типа распространения дезинформации и разжигание ненависти можно алгоритмически распознать и остановить. Но под давлением законодателей компания быстро пообещала заменить свои алгоритмы на армию из 10 000 рецензентов-людей.

Источник: habr.com