Ситуация поляризуется – вместе с нарастанием пессимизма одновременно нарастают оптимистичные мнения о том, что мы не просто не погружаемся в новую "зиму искусственного интеллекта", а, наоборот,

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2018-06-16 17:34

Сейчас мы находимся в середине 2018 года, и исследования в области глубокого обучения развиваются экспоненциальными темпами. В начале этого года, я сделал 10 предсказаний о том, что ожидать в течение года. Делать прогнозы и сравнивать их в ретроспективе - это один из способов определить, являются ли ожидания превышением реальности. Оказывается, это недооценивает реальность в одном аспекте. Я не ожидал увидеть это новое исследование в "самосознании".

Это понимание того, что самосознание в машинах может привести к более автономным машинам и, в конечном счете, к машинам с сознанием. До этого года сама идея создания автоматизации с минутным следом самосознания оставалась совершенно абстрактным понятием. Однако сегодня идея превратилась в активную область исследований!

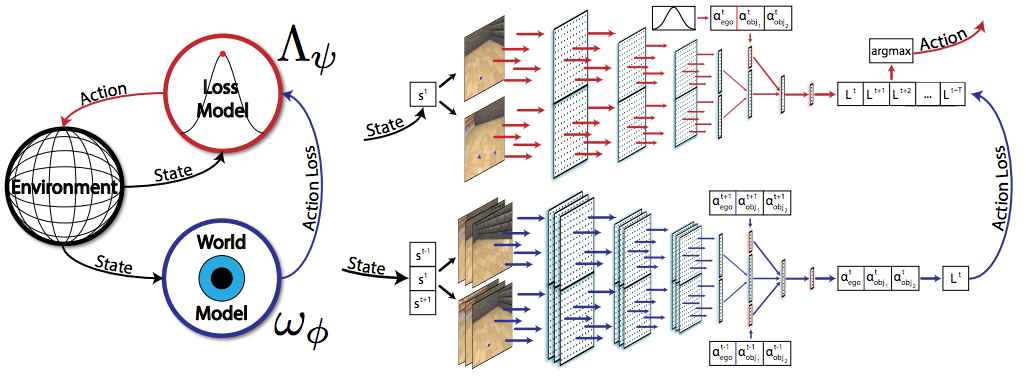

В конце прошлого года я писал, что воплотил обучения необходимо для общего интеллекта. В то время не было много опубликованных исследований, которые изучали эту идею в отношении глубокого обучения. В феврале этого года, Стэнфорд показал бумаги по материалам arxiv “появление структурированного поведения от любопытства на основе внутренней мотивации”, которые начали исследовать возникновение того, что называется эго движения. Эго движение-это самосознание сущности, которая знает свое местоположение и направление в пространстве. Архитектура Стенфордской газеты изображена следующим образом

(Nick Haber, Damian Mrowca, Li Fei-Fei, Daniel L. K. Yamins

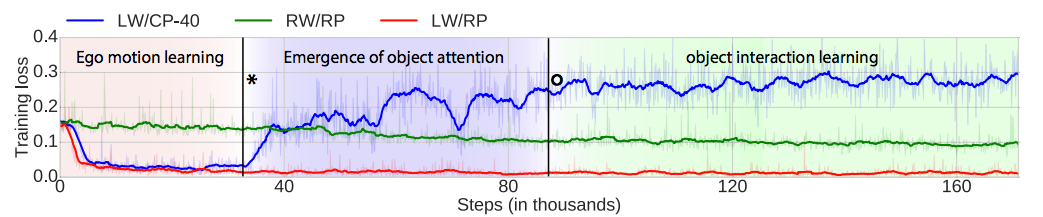

Мы увидим, что концептуальная модель поддержания "мировой модели" и Сиамской сети сравнения мировой модели и модели воспринимаемой среды является повторяющейся схемой проектирования в самосознательных архитектурах. Удивительный результат Стэнфордской статьи-это развитие возможностей, которые были изучены через механизм любопытства. Эта диаграмма

(Nick Haber, Damian Mrowca, Li Fei-Fei, Daniel L. K. Yamins

демонстрирует прогрессирование возможностей от изучения эго движения, внимания к объекту и, наконец, взаимодействия с объектом. Это впечатляющее событие, которое на самом деле не было широко распространено. Ключевым откровением здесь является то, что вы можете начать с эго движения, а затем узнать более продвинутые когнитивные возможности, такие как объектное внимание и изучение взаимодействия. Было эмпирически проверено, что движение эга является хорошей основой, которая приводит к более продвинутой когнитивной способности.

Чтобы не быть сделано, DeepMind представлен ICLR-2018 в конце февраля доклад на тему “изучение информированности моделей”, где система обучен, чтобы понять блоков и предсказать его взаимодействие с блоком. Другой соответствующий документ (также известна в феврале) был Google и DeepMind по “машины Теория разума”. В этой статье исследуется способность автоматизации предсказывать " психические состояния других, включая их желания, убеждения и намерения.

Следующего месяца (т. е. марта 2018 года) Иудея Перл опубликовал документ, который исследовал “теоретических препятствий для машинного обучения с семи искры из Причинного революции”. Перл пишет

Наш общий вывод заключается в том, что человека-уровень AI не может возникать исключительно от модели-слепые обучения машин; требует симбиотического взаимодействия данных и моделей.

Где он проницательно признает ограниченность предыдущих моделей глубокого обучения. То есть система глубокого обучения должна быть осведомлена о моделях, которые она изучает. Когнитивные системы, которые имеют нулевое осознание своих собственных латентных моделей реальности, всегда будут чрезвычайно ограничены. Архитектурный элемент поддержания "модели мира" является абсолютно ключевым для более интеллектуальных систем.

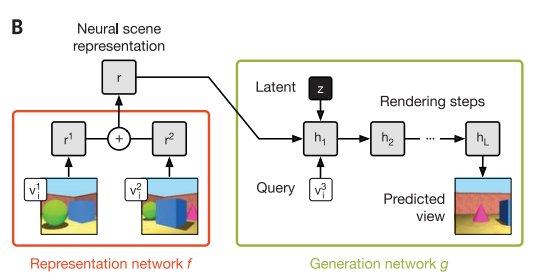

Давайте перенесемся на эту неделю. DeepMind была опубликована захватывающая статья о науки с простым названием “нейронные представлением сцены и рендеринга”. Новаторская способность DeepMind системы является возможность “представить” 3D сцены с просто фотками исходной сцены

S. M. Ali Eslami et al.

Честно говоря, совершенно непонятно, как он может создать такую высококачественную 3D-модель мира. Это потребует много копать, так как это просто неясно, откуда этот квантовый скачок развития берет свое начало. Что такое предшествующие исследования, которые позволяют такой потенциал?

Описанная архитектура не раскрывает ничего, кроме наличия Сиамской структуры и генеративной модели

S. M. Ali Eslami et al.

Чтобы получить какую-то интуицию, как это может работать, возможно, понять, что на самом деле делают две сети.

Первая сеть, как мы видели ранее, представляет собой повторяющийся шаблон, который используется в сетях движения эго. В 2015 году, “научившись видеть, перемещая” для Беркли

Pulkit Агравал, Жоао Каррейра, Джитендра Малик

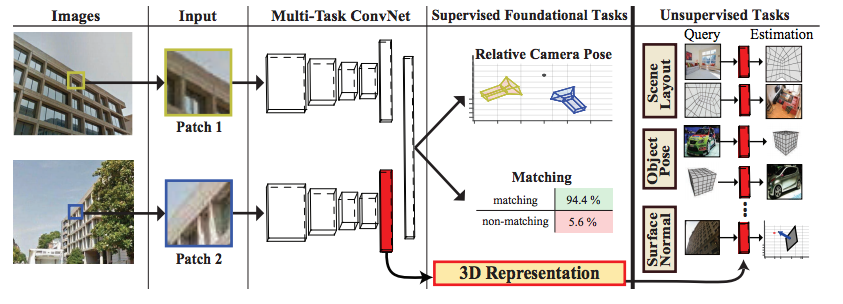

В 2017 году, Стэнфорд опубликовано “Универсальные 3D-представление через ставят оценки и сопоставления”, что является основой этой Сиамской архитектуры сети. Следующие архитектуры

http://cvgl.stanford.edu/papers/zamir_eccv16.pdf Амиров р. Замир, Тильман Wekel, Pulkit Argrawal, Колин Вайль, Джитендра Малик, Сильвио Savarese

был разработан, чтобы узнать 3D представление, данное два изображения. Цель заключалась в изучении этого внутреннего представления, которое можно было бы обобщить на другие задачи, такие как макет сцены, оценка положения объекта и определение нормалей поверхности. Если вы заметили, что в правой части, есть компонент’ query', который, кажется, идентичен бумаге DeepMind. Документ DeepMind отличается использованием дополнительной генеративной сети.

Мотивация это порождающая модель, по-видимому, приходят от более ранней DeepMind бумаги с 2016 года: “в сторону концептуального сжатия” (Примечание: DeepMind имеет привычку пользу невыразительные названия, которые могут быть очень легко забывают в своих исследованиях). Одна из больших исследовательских проблем, связанных с генеративными моделями, заключается в том, как мы их создаем, сохраняя базовую семантику. Генеративные модели очень хорош в визуализации реалистичных изображений (см.: "зловещую долину" для глубокого обучения) однако они также создают нереальные модели. Это показывает, что базовое представление не в состоянии захватить семантические отношения между компонентами, которые оно в состоянии генерировать. Как сеть DeepMind может захватить семантику в бесконтрольной манере?

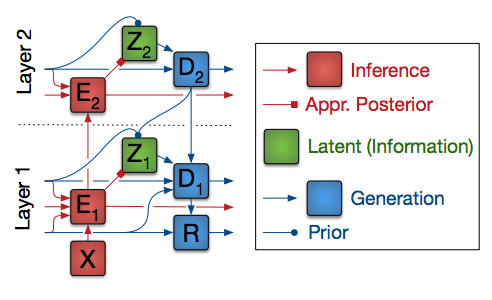

Документ” концептуальное сжатие " (NIPS 2016)предоставляет намек на то, как это может быть сделано

https://deepmind.com/research/publications/towards-conceptual-compression/ Кароль Грегор, Фредерик Бесс, Данило Хименес Резенде, Иво Даниэлка, Даан Wierstra

В статье они описывают то, что они подразумевают под "концептуальным сжатием“, следующим образом:”отдавая приоритет более высоким уровням представления и генерируя остаток". Если вы заметили на схеме выше, эта архитектура строит своего рода представление на каждом слое. Это описано следующим образом

Предположим, что сеть изучила иерархию все более абстрактных представлений. Затем, чтобы получить различные уровни сжатия, мы можем хранить только соответствующее количество верхних слоев и генерировать остальное. Решая проблему бесконтрольного глубокого обучения, сеть будет заказывать информацию в соответствии с ее важностью и хранить ее с этим приоритетом.

Что они обычно говорят о “стоя на плечах гигантов”? Оказывается, что два ключевых компонента этого недавнего разработчика DeepMind появились еще в 2016 году.

Вот ключ, хотя, чтобы добраться до "самосознания", вам нужно иметь способ создания латентных моделей, которые захватывают семантику базового набора обучения. Один другой подход к этому DeepMind по ?-ВАЕ, которая является способом распутывания представлений. Это было выявлено в апреле этого года.

Так что шаблоны проектирования мы только что узнали здесь? (1) Использование curiosity для изучения новых возможностей (2) важность явных моделей, которые могут быть интроспектированы (3) Сиамская сеть для создания 3D-моделей (4) метод концептуального сжатия. Будут другие ингридиенты все еще нужно экспириментально быть определенным, мы быстро получаем там!

Есть много прогностиков, которые предсказывают зиму ИИ. Это, вероятно, исследователи, которые имеют либо мало воздействия в области или не имеют хорошей концептуальной модели для определения ключевых вех. Чрезвычайно важно иметь хорошую концептуальную модель познания, чтобы иметь возможность пробираться через тысячи статей, которые публикуются каждый год в глубоком обучении. Только в этом году в NIPS было представлено 4900 работ

Источник: medium.com