Сервер для задач глубокого обучения Nvidia DGX-2 построен на GPU Tesla V100

МЕНЮ

Главная страница

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Искусственный интеллект

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Психология ИИ

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Творчество ИИ

Техническое зрение

Чат-боты

Авторизация

2018-06-04 19:45

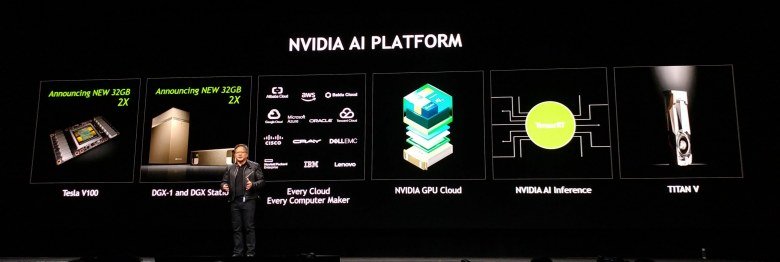

Тема графических применений продукции NVIDIA на конференции GTC 2018 уже давно перестала быть главной. Хотя немалую часть ключевого выступления главы компании занимала трассировка лучей в реальном времени и автомобильная тематика, не обошёл он стороной и самую важную тему для NVIDIA на GTC - применение в системах искусственного интеллекта и глубокого обучения, в частности. Технологии калифорнийской компании шагнули далеко за рамки ускорения рендеринга и обработки визуальных данных, и главной для них сейчас является вычислительная платформа для ускорения глубокого обучения.

Миллионы серверов и компьютеров по всему миру становятся всё производительнее, но для того, чтобы сделать их умнее, нужно научиться использовать все возможности: качественное распознавание голоса, понимание естественной речи и многое другое - кстати, обработка визуальных данных сюда тоже входит. Президент компании Дженсен Хуанг, выступая перед 8500 разработчиками, бизнесменами, учёными и прессой, опубликовал целую серию анонсов, укрепляющих вычислительную deep learning платформу компании.

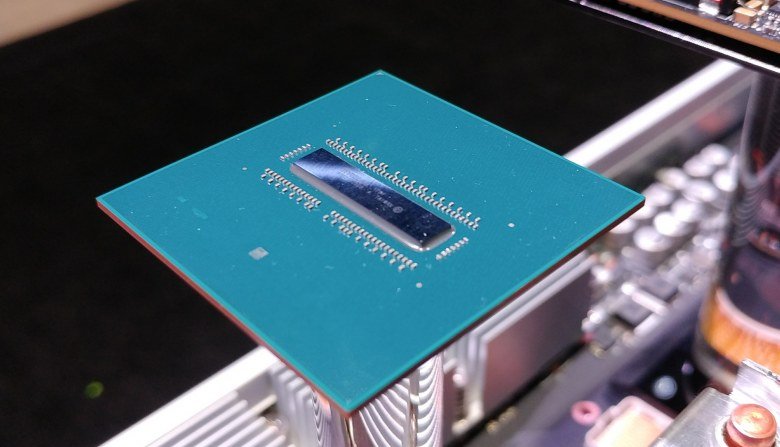

NVIDIA с каждым годом значительно улучшает возможности и производительность своей платформы для глубокого обучения, серьёзно превосходя все ожидания, что открывает новые возможности по применению их платформы и революционных изменений в различных сферах: медицине, транспорте, науке и многих других. Даже если не говорить о важных программных объявлениях, среди которых адаптация большинства облачных сервисов, то одним из самых интересных аппаратных анонсов стало объявление нового вычислительного решения Tesla V100, использующего удвоенный до 32 ГБ объём начиповой HBM2-памяти, который актуален в большом количестве требовательных к объёму и скорости памяти задач глубокого обучения. Удвоенный объём памяти позволит обучать большие по размеру модели и получить преимущество в задачах, которые были ограничены ранее памятью объёмом в 16 ГБ.

Новое вычислительное решение Tesla V100 32GB доступно со дня анонса, а такие известные производители как Cray, Hewlett Packard Enterprise, IBM, Lenovo, Supermicro и Tyan начнут распространять системы на основе Tesla V100 32GB во втором квартале текущего года. Сервис Oracle Cloud Infrastructure также уже анонсировал планы по предложению возможностей новой Tesla V100 32GB в облаке во второй половине года.

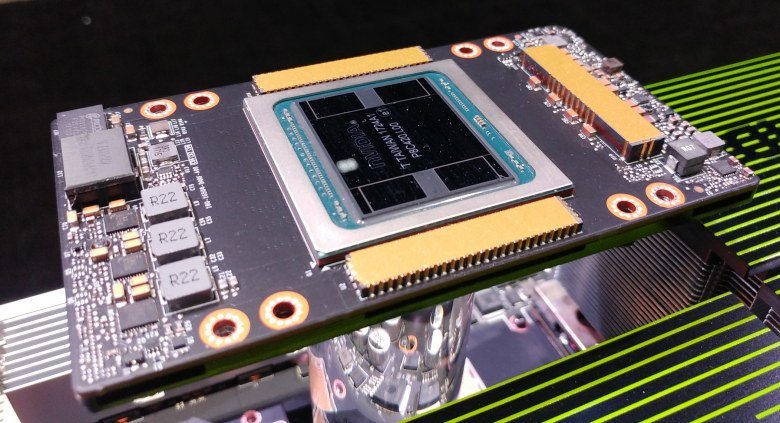

А совместно с совершенно новой технологией межчиповых соединений NVIDIA NVSwitch, соединяющей до 16 ускорителей Tesla V100 в единое устройство с производительностью подсистемы памяти в 2,4 терабайта/с, возможности таких систем и вовсе будут казаться безграничными. NVSwitch расширяет возможности NVLink и предлагает в 5 раз большую пропускную способность по сравнению с лучшими из PCI-Express свитчей и это позволяет создавать системы с большим количеством соединённых друг с другом GPU в них.

Нейросети становятся всё более сложными, растут их размер и наборы данных. Также появились некоторые новые техники, требующие большего количества GPU, соединённых друг с другом для обмена данными и синхронизации. Такие операции требуют передачи большого объёма данных и высокой пропускной способности. Новое решение компании убирает предыдущие ограничения по скорости передачи данных между чипами и позволяет использовать наборы данных большего размера при всё более ресурсоёмких нагрузках, включающих параллельную тренировку нейросетей.

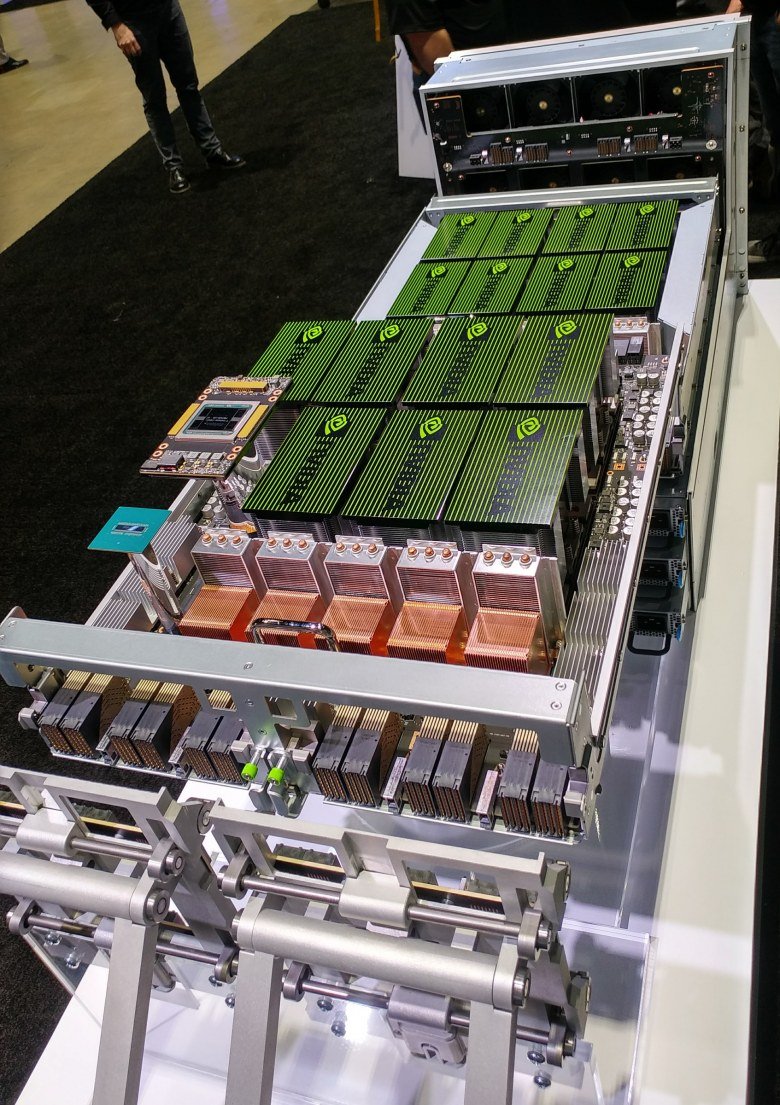

Каждый из NVSwitch содержит 18 портов NVLink (50 ГБ/с на порт), на базовой плате их шесть штук вместе с восемью GPU Tesla V100, и две эти базовые платы могут объединяться в одно целое. Каждый из восьми GPU на одной плате соединён с каждым из шести NVSwitch одиночным NVLink каналом, а восемь портов каждого чипа NVSwitch используются для обмена данными с другой базовой платой. Соответственно, каждый из восьми GPU на плате с другими процессорами "общается" на скорости в 300 ГБ/с.

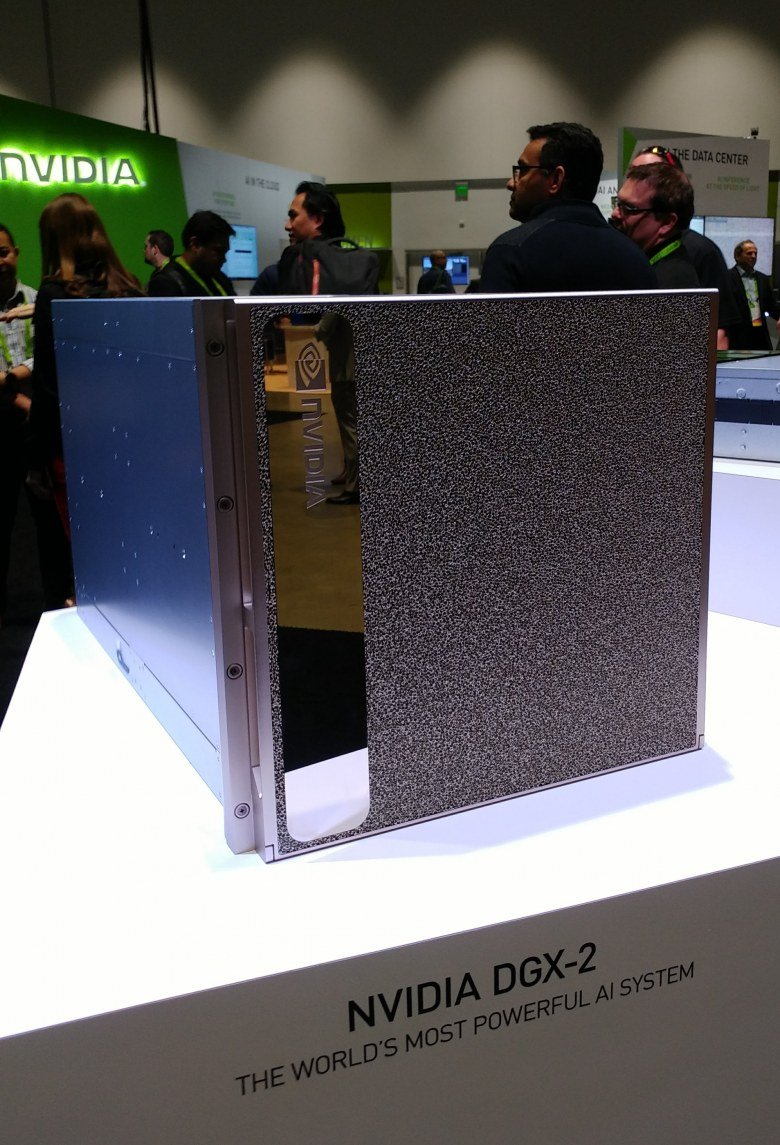

Неудивительно, что NVIDIA сразу же анонсировала готовое самое произодительное решение на основе Tesla V100 и NVSwitch, предназначенное для задач глубокого обучения - NVIDIA DGX-2. Это первый одиночный сервер с вычислительной производительностью в два петафлопа, заменяющий 300 обычных серверов, занимающих 15 стоек в датацентрах при в 60 раз меньшем размере и в 18 раз большей энергоэффективности.

DGX-2 - это первая система, использующая NVSwitch и позволяющая 16-ти процессорам системы использовать общую память. На такой системе разработчики могут тренировать нейросети на более сложных и больших массивах данных, используя более комплексные модели глубокого обучения. В результате новая система DGX-2 в некоторых задачах может быть в несколько раз раз быстрее DGX-1 на основе всё той же архитектуры Volta, представленной в сентябре. Новинка включается в линейку продуктов DGX и становится на вершину этой серии вычислительных систем NVIDIA.

Кроме анонсов аппаратных решений на тему deep learning, была объявлена улучшенная поддержка ускоренных на GPU задач глубокого обучения. В частности, получило поддержку новых версий такое ПО как: CUDA, TensorRT, NCCL и cuDNN, новый набор Isaac software developer kit для тренировки роботов. Также было объявлено о тесной работе с ведущими разработчиками облачных сервисов и об оптимизации всех распространённых фреймворков под возможности новой вычислительной платформы NVIDIA.

Источник: www.ixbt.com