Что показали на Google I/O 2018

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2018-05-09 08:02

Вчера в 8 вечера по Москве на сцену Shoreline Amphitheater в Маунтин-Вью вышел Сундар Пичаи и открыл Google I/O 2018. Конференция продлится три дня с 8 по 10 мая, но главное объявили со сцены во время традиционной программной речи. Android P научился жестам как в iOS 11 на iPhone X, Google Assistant теперь говорит шестью разными голосами и почти проходит тест Тьюринга, а разработчикам раздадут ML Kit для внедрения machine learning в их приложения.

Google Assistant

Ассистент — гвоздь программы. За два года с момента анонса он поселился на 500 млн разных девайсов. Помимо смартфонов это умные колонки, наушники, телевизоры и часы. Он интегрирован в авто 40 разных производителей и поддерживает работу с 5000+ домашними устройствами типа посудомоечных машин и звонков.

Теперь его научили говорить шестью разными голосами и понимать сразу несколько команд в одной фразе. К концу года Ассистент Google будет работать в 80 странах и поддерживать 30 языков, включая русский. И да, больше не нужно постоянно говорить «ОК, Гугл». То есть можно сказать: «Ок, Гугл, заведи будильник на 7 утра и напомни купить йогурт, когда я буду возле супермаркета».

Раньше от Ассистента мы ждали в первую очередь вербальный отклик, от умной колонки, например. Но на этом I/O Google показала несколько устройств из категории умных дисплеев — это по сути умная колонка, только с тачскрином. Такой колонке с экраном можно сказать «ОК, Гугл, включи Джимми Киммела», и она найдет его шоу на YouTube и запустит. На этом же девайсе, по мнению Google, удобно искать рецепты. Чем принципиально так называемые «умные дисплеи» отличаются от обычных планшетов, пока не очень понятно.

В США Google Assistant научили также работать по схеме pick-up and delivery и завязали на популярные сети: Starbucks, 7-Eleven, Dunkin Doughnuts и другие. Теперь в Штатах вы можете поговорить с Ассистентом и попросить заказать латте с карамелью, чтобы забрать его в удобном кафе.

Все, что вы скажете Ассистенту, он запомнит и постепенно станет выдавать подсказки и строить картину предстоящего дня, как это делал Google Now, только точнее. Все эти фишки появятся в новой версии Android летом 2018.

Google Duplex

На Google I/O Сундар показал то, что в компании называют Google Duplex. Все наработки последних лет объединили, и это позволило Ассистенту успешно провести телефонный разговор с ничего не подозревающим человеком. По крайней мере так сказали со сцены. Если все эти «эээ…», «хмм» и прочие чисто человеческие речевые нюансы в самом деле выдала нейросеть, значит, мы близки к тому, чтобы компьютер прошел тест Тюринга. Смотрите сами:

Вы просите Ассистента забронировать для вас столик в ресторане, а он в фоновом режиме сам звонит туда и обо всем договаривается. Голосом. Осталось дождаться, когда на том конце провода тоже посадят виртуального помощника.

Полноценный эксперимент с участием малого бизнеса Google планирует провести несколько недель спустя. Ассистента планируют «посадить на телефон», чтобы он отвечал на звонки клиентов.

Android P

Бета-версия Android P появится 8 мая и будет доступна на 11 смартфонах:

- Sony Xperia XZ2

- Xiaomi Mi Mix 2S

- Nokia 7 Plus

- Oppo R15 Pro

- Vivo X21

- OnePlus 6

- Essential PH-1

- Google Pixel / XL

- Google Pixel 2 / 2 XL

В новой версии ОС пересмотрели подход к навигации и жестам. В частности реализовали вызов списка открытых приложений так же, как в iPhone X — свайпом снизу вверх. От кнопки вызова приложений из фона отказались полностью, а кнопка «Назад» появляется, только если открыто какое-то приложение. Кроме того, обновится дизайн некоторых элементов интерфейса в соответствии с Material Design 2.

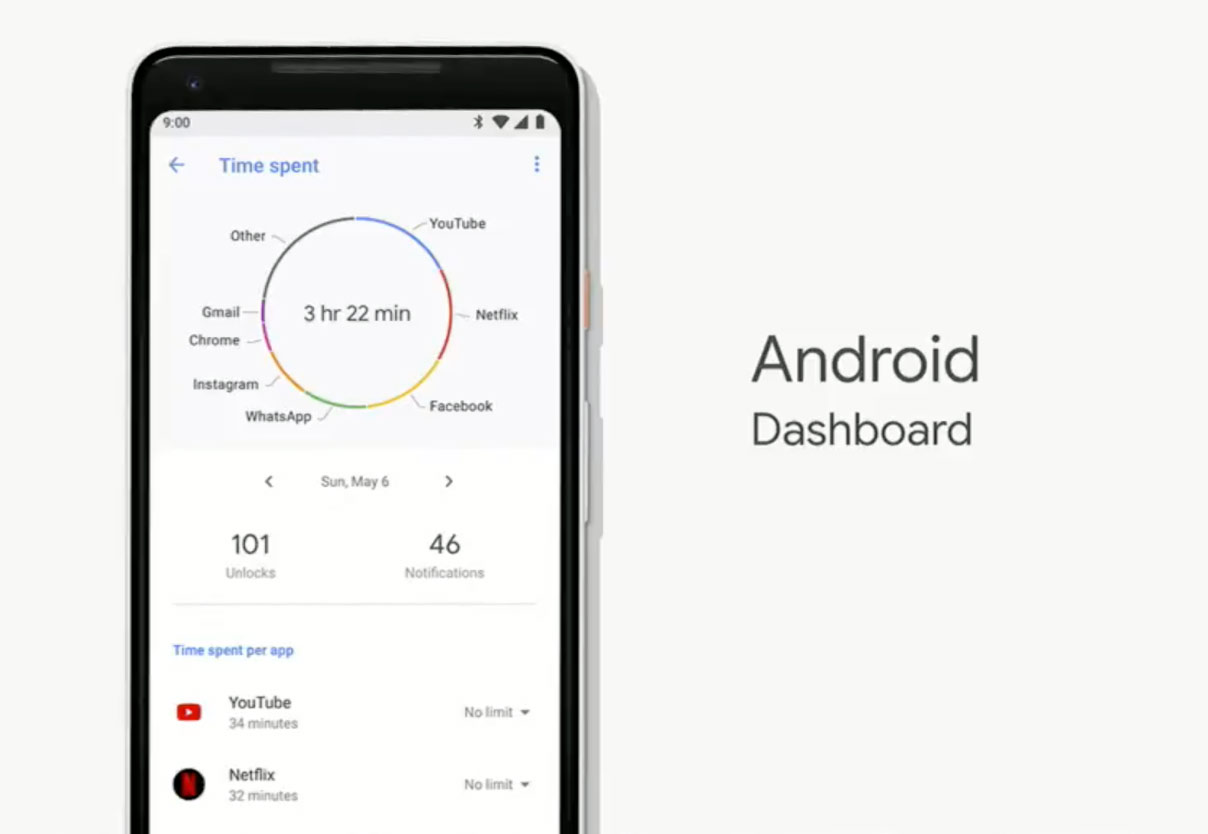

О нескольких новых фичах Пичаи рассказал отдельно. Например, в Android P появился «Дэшборд», куда выводится статистика использования смартфона: сколько раз вы его разблокировали за день, сколько уведомлений прочитали.

В настройках приложения YouTube для Android можно выбрать режим, при котором время от времени будет появляться напоминание, что пора бы сделать паузу, если вы долго непрерывно смотрите видео. Кроме того, уведомления о новых видео с каналов, на которые вы подписаны, теперь можно получать в виде ежедневного дайджеста, а не по отдельности.

Family Link — панель управления устройствами ваших детей, которая поможет ограничить время, проведенное перед экраном.

Google News

На Google I/O Сундар Пичаи рассказал о перерождении Google News. Теперь «Новости» похожи на Яндекс.Дзен — это интеллектуальный агрегатор новостей, который знает, что вы обычно читаете и каким ресурсам доверяете. Он отсеивает ненужное и выводит на вкладку «Для вас» пять значимых историй за последние несколько часов.

Машинное обучение

С помощью машинного обучения новые устройства под управлением Android смогут значительно сэкономить энергию батареи, предсказывая, какое приложение вы запустите следующим, с вероятностью около 60%.

Но главное — теперь API для доступа к таким возможностям смартфона как распознавание текста и лиц на фото или, например, сканированию штрих-кодов теперь есть у всех разработчиков благодаря Machine Learning Kit. Кроме того, со сцены заявили, что у девелоперов будет доступ и к облачным нейросетям Google, но подробностей не сообщили.

Источник: geektimes.com