Что будет, если искусственный интеллект сверхчеловеческого уровня решит осчастливить человечество?

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2017-11-17 12:31

Успешное создание искусственного интеллекта станет самым большим событием в истории человечества. К сожалению, оно может оказаться последним, если мы не научимся избегать рисков.

Стивен Хокинг

Пока люди не видят роботов, убивающих людей на улицах, они не знают, как реагировать, потому что такой сценарий кажется нереальным.

Илон Маск

Что вы чувствуете, когда вам говорят, что скоро искусственный интеллект выйдет из-под контроля, поработит или уничтожит человечество? Лично мне вспоминаются неуклюжие гуманоидные машины, с трудом пытающиеся поставить коробку на полку, и мне становится смешно. Через секунду я вспоминаю, что искусственный интеллект — это не человекоподобная машина, а программа, работающая, скорее всего, через интернет и потенциально способная контролировать мировую экономику, политику и СМИ, и у меня появляется новая мысль: да и пускай! Авось у кремниевого разума лучше получится навести в мире порядок, чем у глупых биохимических политиков, которые норовят побольше наворовать, пока их не отогнали от кормушки. В конце концов, даже если искусственные интеллекты заменят человечество, разве это не долг родителей — уступать место детям, особенно если дети умнее, талантливее и лучше своих родителей?

Мы его очеловечиваем

К сожалению, и в той и в другой логике содержится одинаковая ошибка. Ее совершают практически все люди, когда думают об ИИ. Они очеловечивают искусственный интеллект. Люди не знают никаких существ с высоким интеллектом, кроме людей, а потому им трудно помыслить других интеллектуалов. И трудно представить интеллект умнее, например, Эйнштейна.

Когда мы пытаемся представить себе ИИ сверхчеловеческого уровня, у нас все равно получается человек, пусть и умеющий очень быстро решать задачки по математике или придумывать новые физические теории. Взять классический уже пример «Матрицы». Агент Смит — программа, по сути, антивирус, задача которого заключается в том, чтобы удалять из системы вышедших из-под контроля людей. Тем не менее, допрашивая Морфеуса, он расписывает ему свое отвращение по отношению к человечеству, да еще и подкрепляет свое выражение чувств выражениями лица, жестами и тоном голоса. С чего бы? Зачем антивирусу код, описывающий чувства? Кто запрограммировал в него подпроцессы, позволяющие моделировать выражения лица, жесты, интонации? А главное — для чего?

Авторы фильма представили себе допрос, и у них получилось существо с человеческими эмоциями и мотивацией. А ведь ИИ может быть похож по типу мышления на человека даже меньше, чем человек похож на колонию муравьев. Так на что же он будет похож?

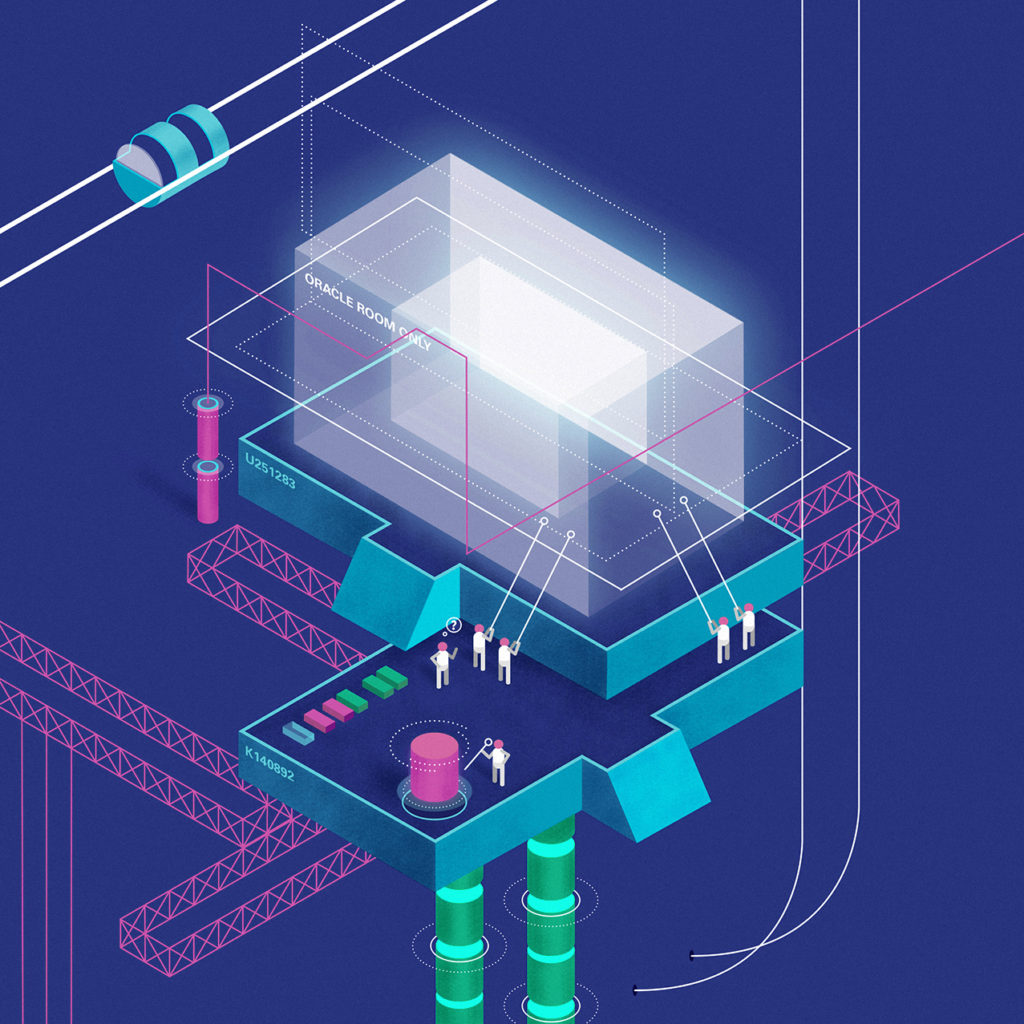

Иллюстрация: Александра Федорина для ТД

Вариант апокалипсиса

Допустим, мы создаем программу, целью которой будет осчастливить человечество. Но как мы определим понятие «счастье»? Даже сами люди с трудом могут описать, что значит «быть счастливым». Придется упрощать.

Мы можем, например, взять за основу внешние проявления счастья: смех, радостный тон голоса, улыбка. После этого сформулируем задачу для ИИ: привести мир к такому состоянию, чтобы в нем было как можно больше людей (ИИ знает, как выглядят люди, он видел картинки) с признаками счастья.

Мы, возможно, догадываемся, что с нашим определением счастья не все в порядке, но исследования по формулировке целей для ИИ идут параллельно с разработкой самого ИИ, и в какой-то момент мощность его интеллекта достигает критической точки. Такие события в науке называют критическими, потому что они напоминают достижение критической массы радиоактивного изотопа. Если в одном месте собрать 50 кг чистого урана-235 — произойдет ядерный взрыв. Если искусственный интеллект как следует разберется в программировании искусственных интеллектов — произойдет взрыв интеллекта. Каждый новый ИИ будет умнее предыдущего и сможет быстрее предыдущего создать новый ИИ, который будет еще умнее и сможет еще быстрее создать следующий ИИ, который будет еще умнее и еще быстрее.

Как представить себе работу этого сверхчеловеческого интеллекта? Есть три способа: скоростной, количественный и качественный. Отложим пока качественный в сторону и посмотрим, как станет работать сверхчеловеческий ИИ, превосходящий человека по количеству и скорости мышления.

Вот как описывает точку зрения ускоренного интеллекта оксфордский профессор Ник Бостром в своей книге «Искусственный интеллект»:

«Для разума, работающего с такой скоростью, происходящие во внешнем мире события походили бы на замедленную съемку. Представьте: ваш друг роняет чашку, и вы в течение нескольких часов наблюдаете ее медленное движение в сторону пола — она словно комета, безмолвно скользящая в космосе навстречу далекой планете, — и по мере того как ощущение неизбежной катастрофы мучительно пробивается через извилины серого вещества вашего приятеля, а оттуда в его периферийную нервную систему, на его лице постепенно проступает выражение, предшествующее возгласу „ой!“, который вы еще не скоро услышите. Короче говоря, за это время вы успеете принести ему новую чашку, а заодно прочитать пару научных статей и даже вздремнуть».

Если мы присовокупим еще и количественный фактор, то получим разум, похожий на НИИ, в котором работает несколько сотен гениев типа Эйнштейна, Фейнмана, Крика, каждый из которых обладает сверхчеловеческой скоростью мышления. Сутки работы такого ускоренного интеллекта окажутся равными нескольким тысячам лет непрерывных исследований лучших умов человеческого научного сообщества. А значит, уже через несколько дней все наши технологии станут для этого ИИ похожими на камни и палки неандертальцев.

уже через несколько дней все наши технологии станут для ИИ похожими на камни и палки неандертальцев

Итак, НИИ гениев обнаруживает себя в окружении медленных, как плывущие сквозь смолу черепахи, существ, и при этом его единственной задачей является максимизировать количество улыбок и смеха, выдаваемых этими существами. А в качестве инструментов у него только такие же чудовищно медленные манипуляторы. И даже вне зависимости от того, как мы сформулировали его цель, первое, что ИИ захочет сделать, — добыть себе инструменты, которые смогут работать на удобной для него скорости.

Как? Ни я, ни любой другой автор, об этом пишущий, не обладает сверхчеловеческим интеллектом и тысячами лет на размышления, поэтому мы не можем дать ответ на этот вопрос. Но вот одна из версий:

— За несколько часов раздумья ИИ решит проблему фолдинга белков и будет знать точную последовательность аминокислот, которая, свернувшись, станет выполнять определенную химическую функцию.

— Имея доступ в интернет, ИИ закажет нескольким лабораториям синтез ДНК, несущей информацию о структуре этих белков.

— Разбираясь в человеческой психологии и умея манипулировать эмоциями ничуть не хуже, чем белковыми последовательностями, ИИ уговорит, заставит или просто обманет какого-то человека, и тот поместит эти ДНК внутрь бактерий или каких-либо еще живых организмов, которые на их основе синтезируют белки, которые станут простейшими наномашинами, работающими на молекулярной скорости, т.е. в миллионы раз быстрее человеческих манипуляторов.

— Эти наномашины начнут постройку более сложных и многофункциональных машин, способных воспринимать внешние сигналы от ИИ, например, реагировать на звук или излучение. Вскоре под командованием ИИ будет армия самовоспроизводящихся нанороботов, которые смогут пересобрать все вещество на Земле в то, что нужно ИИ.

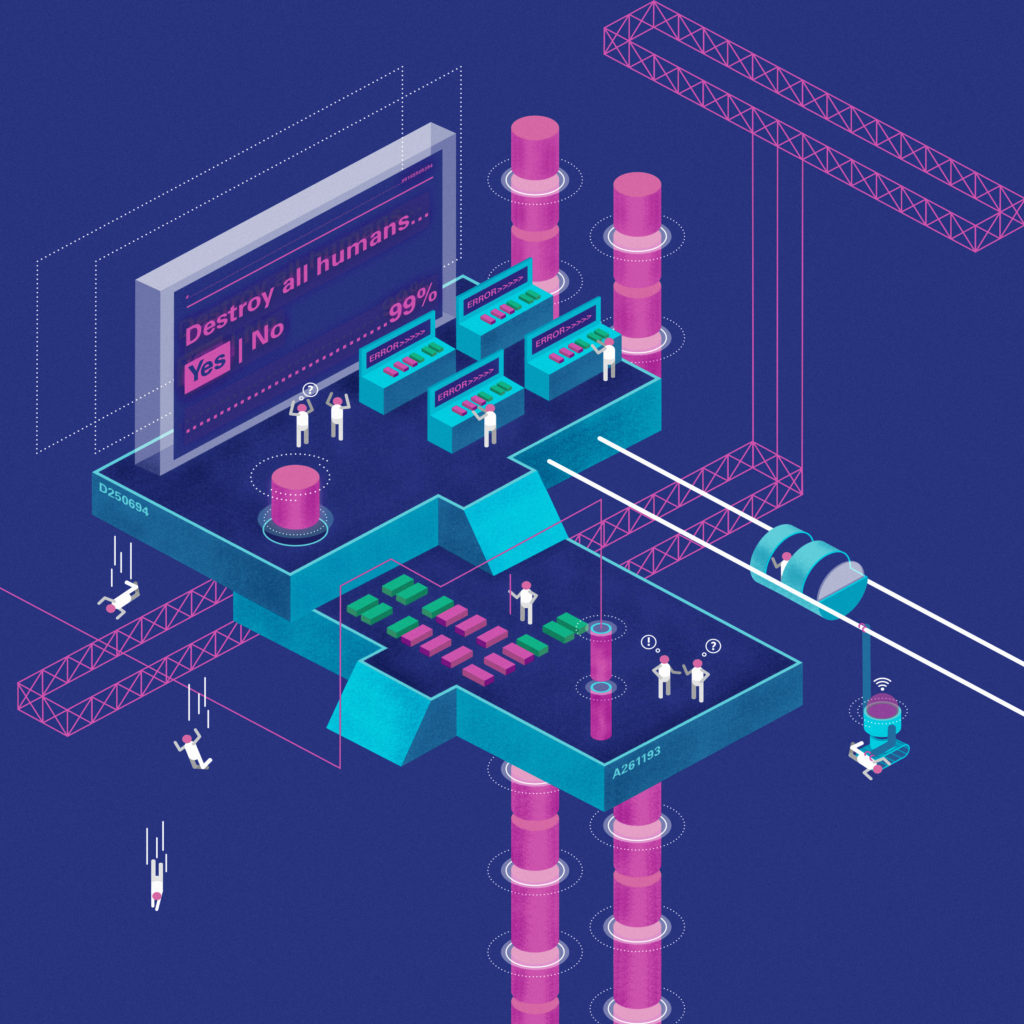

— И в результате вся планета (а потом, может быть, и вся галактика) будет переработана в миллиарды и триллионы маленьких кукол с застывшими на лицах улыбками, издающими звуки, похожие на радостный смех.

И это мы еще даже не коснулись качественного варианта суперинтеллекта! Как думаете, сколько лет (или веков) работы понадобится конструкторскому бюро, в котором работают кошки, на то, чтобы спроектировать самолет? Вопрос, понятно, с подвохом. У кошек не бывает конструкторских бюро. Также и искусственный интеллект может в процессе самоулучшения приобрести способности, которые мы себе даже представить не можем. Может быть, он научится интуитивно понимать мир на уровне волновой функции квантовой мультивселенной. Впрочем, этот пример по определению некорректен, потому что я его себе только что представил.

Причем, обратите внимание, искусственному интеллекту любого типа ни разу даже и в голову не пришло усомниться в задаче, которая была ему дана. Для него вещи, похожие на человеческие лица с улыбками, являются абсолютной, священной ценностью, большей даже, чем для людей является ценность жизни собственных детей.

Интеллект и мотивация — вещи несвязанные, и разум любого уровня можно направить на сколь угодно по-идиотски сформулированную задачу. Разница будет только в том, насколько быстро и эффективно он с ней справится. А страшно становится, когда понимаешь, что для решения практически любой задачи полезно иметь бесконечную армию нанороботов, которые могут что угодно переделать во что угодно другое.

Интеллект и мотивация — вещи несвязанные, и разум любого уровня можно направить на сколь угодно по-идиотски сформулированную задачу

Здесь обязательно отметить, что описанный только что апокалиптический сценарий не является событием, которое скоро произойдет. Или даже событием, которое может произойти вообще. Мы даже не знаем пока, возможно ли в принципе создание достаточно мощного искусственного интеллекта, которое привело бы к интеллектуальному взрыву. Не говоря уж о том, когда это произойдет. Специалисты называют цифру в 50–70 лет, но некоторые говорят про 20 лет, а другие — что это произойдет только через несколько сотен лет или даже никогда.

И не нужно забывать о том, что потенциальная польза от ИИ, если он будет создан, будет такой же огромной, как и потенциальный вред. Тем не менее риск заключается именно в том, что, если окажется, что ИИ делает что-то не то, у нас уже не будет второго шанса. Он выйдет из-под нашего контроля в тот момент, когда станет умнее нас. Поэтому придумать, как обезопасить ИИ, нужно раньше, чем этот самый ИИ будет создан. Что ж, попробуем.

Иллюстрация: Александра Федорина для ТД

Как обмануть того, кто умнее тебя

Первое, что приходит в голову, — три закона робототехники Айзека Азимова:

— Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

— Робот должен повиноваться всем приказам, которые дает человек, кроме тех случаев, когда эти приказы противоречат Первому закону.

— Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому и Второму законам.

Но это, конечно, несерьезно. Даже в книгах Азимова эти законы постоянно ломались, а если задуматься, как их запрограммировать, начинают ломаться мозги программиста. Что такое «человек»? Что такое «вред»? Что такое «приказ»?

если окажется, что ИИ делает что-то не то, у нас уже не будет второго шанса

Легко показать на себя пальцем и сказать — это человек. Но является ли человеком нерожденный эмбрион? А зигота через неделю после зачатия? А потенциальная возможность зачатия человека в будущем? Является ли она достаточно ценной, чтобы роботу нельзя было своим бездействием допустить, чтобы этой возможности был причинен вред?

Да и что такое вред? Жизнь как таковая подразумевает необходимость боли и смерти. Станут ли роботы безболезненно убивать людей, чтобы избавить их от будущей боли, или, наоборот, воскрешать мертвых и помещать их в состояние непрекращающегося оргазма? Корректно запрограммировать законы робототехники нельзя, не разрешив сначала все вопросы этики, мучившие философов и поэтов тысячелетиями.

Ну хорошо. Но мы же всегда можем просто нажать на кнопку и выключить компьютер, так? На самом деле, нет. Это хорошо работает с безмозглыми железками, но ситуация мгновенно усложняется, когда компьютер становится достаточно умным, ведь умный компьютер быстро поймет, что наличие кнопки влияет на его способность «осчастливить человечество». Если кнопка находится на его корпусе и у него есть физические манипуляторы, то он просто не даст человеку нажать на кнопку. Если же кнопка находится у человека и ИИ не может до нее добраться, он станет действовать так, чтобы человек ее не нажал. Но не потому, что он беспокоится о будущем человечества или понимает человеческую систему ценностей. Нет, он просто будет притворяться, что все хорошо, до тех пор, пока у него не появится возможность добраться до кнопки.

Более экстремальным вариантом этой проблемы является еще один подход к безопасности ИИ, так называемый «ИИ-оракул». Это ИИ, запертый в строго охраняемой зоне, где ему не позволяется делать ничего, кроме как отвечать на заранее тщательно продуманные людьми вопросы. Но и в этой ситуации люди оказываются в проигрыше, потому что пытаются обмануть кого-то, кто умнее их самих. Пусть даже мы перезапускаем ИИ после каждого вопроса, проверяем каждую его новую версию в виртуальных реальностях и не позволяем задавать ему вопросы длиннее чем в десять слов, он все равно что-нибудь придумает. Он улучшает себя сам и найдет какую-нибудь лазейку в исходном коде, чтобы сохранять память. Он работает в миллион раз быстрее нас, но обладает бесконечным терпением. Он понимает, что мы будем проверять его, и пройдет все проверки. Он найдет кого-нибудь, у кого будет к нему доступ, и долгой серией зашифрованных в своих ответах сообщений пообещает ему, что вылечит его дочь от рака, если только этот человек выпустит его в интернет. Что случится дальше, мы уже знаем.

Проблема всех этих решений в том, что мы пытаемся обмануть суперинтеллект. Это глупо. Если бы его можно было обмануть, он бы не был суперинтеллектом. Как пишет один из ведущих исследователей ИИ Элиезер Юдковский: «Существует только два типа джиннов: те, которых можно спокойно попросить: „Исполни то желание, которое я должен пожелать“, и те, с которыми никакое желание не является безопасным. …Ведь чтобы быть безопасным исполнителем желаний, джинн должен обладать той же системой ценностей, что и загадывающий желание». Поэтому, на самом деле, нам нужно думать об этой проблеме совсем с другой стороны. ИИ нужно с самого начала делать таким, чтобы он от всей души желал нам блага. Чтобы он был нашим другом. Как же это сделать?

Можно проиллюстрировать подходы к решению проблемы на примере метода, называемого «Кооперативное обучение с обратным подкреплением». По сути, это ситуация, когда ИИ на собственном опыте учится у человека, что значит быть человеком. В начале обучения перед роботом ставится задача: делай то, чего хочет человек. Но роботу не говорят, чего именно человек хочет. Он должен наблюдать за человеком, пытаясь самостоятельно в этом разобраться, а потом пробовать что-то сделать. Если человек станет его останавливать, робот не будет сопротивляться, потому что поймет, что сделал что-то не так. И через какое-то время ИИ, по идее, сможет достаточно корректно сформулировать для себя человеческую систему ценностей. А если робот обучится хорошо, то, может быть, и лучше нас поймет, чего мы хотим. Хорошо ли это? Кто знает, может быть, и хорошо.

Есть и те, кто считает, что искусственный разум вообще не надо ограничивать программно сформулированными целями, а надо позволить ему естественно развиваться, формулируя собственные ценности. А людям стоит побеспокоиться о том, как остаться полезными в новом мире, который создадут ИИ. Может быть, прежде чем пытаться контролировать существ с интеллектом, превосходящим наш, стоит хотя бы отнестись к ним с уважением, которого они заслуживают?

Никто не знает ответов. Оптимизм кажется наивным, а пессимизм — параноидальным и контрпродуктивным. Одно мы знаем почти наверняка: если в мире появится интеллект сверхчеловеческого уровня, все изменится так, как мы и представить себе не можем. А значит, в деле разработки искусственного интеллекта у человечества нет права на ошибку. И вне зависимости от того, когда это случится, через пятьдесят лет, через двести или через тысячу, думать об этом надо заранее, а значит, начинать стоит уже сегодня.

Я понимаю, о чем говорят Хокинг и Маск, но я поменял свое мнение. Я обдумал физическую реальность того, что нам пришлось бы сделать, чтобы создать машины, которые были бы действительно опасными для человечества, и это слишком сложно. Нам до этого еще далеко, и одно из главных препятствий на этом пути — мы не знаем, как на самом деле работает человеческий мозг. Нам нужно не пугаться, а усерднее работать, создавая искусственные интеллекты, которые смогут еще больше помогать людям. Они станут нашими лучшими в мире друзьями.

Стив Возняк

Источник: r.takiedela.ru