Почему одного только машинного обучения недостаточно

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2017-09-05 19:01

искусственный интеллект, распознавание образов, алгоритмы машинного обучения

Интернет и подключенные к нему устройства вторгаются в нашу жизнь с каждым днем все сильнее. Мы подчас не замечаем, насколько естественным стало просить Siri, Alexa или Google помочь разобраться с каким-то насущным вопросом. А еще мы доверяем нашу жизнь «умным» автомобилям, надеясь, что они всегда успеют отреагировать на сложившуюся ситуацию на дороге и избежать жертв. Кого-то, конечно, беспокоят возможности современных технологий, например, камеры установленные в общественных местах, которые распознают лица с помощью специального программного обеспечения, но большинство даже не задумываются об этом.

Пока что над ошибками искусственного интеллекта (ИИ) можно и посмеяться, ведь многие из них довольно забавны (главное не думать, что в некоторых случаях существует вероятность смертельного исхода). По мере того как машины развиваются, а зловреды совершенствуются, все может измениться — и станет не до смеха. Но пока мрачное будущее еще не настало, давайте взглянем на некоторые забавные ляпы ИИ.

Фиаско с кукольным домиком

Вот классический пример: новостная программа, вышедшая в Калифорнии в этом году, вызвала что-то наподобие цепной реакции. Реакция возникла из-за просчета ИИ, возникшего по причине другого просчета ИИ. Если кратко, то дело было так: рассказанная в эфире новость о том, что устройство Amazon Echo по ошибке заказало кукольный домик, спровоцировала множество других устройств Amazon Echo (которые, как обычно, внимательно все слушали и не отличали голос владельца от других голосов) заказать еще «немного» кукольных домиков. Пожалуй не стоит смотреть это видео с записью репортажа из дома – вдруг какой-нибудь из ваших умных помощников тоже сочтет его указанием к действию.

Фастфуд и его ошибка

Компания Burger King попыталась использовать описанную выше, скажем так, особенность «умных помощников» в своих интересах и активировать голосом устройства тех, кто смотрел рекламу. Ей это удалось – в какой-то мере. Проблема в том, что в расчет не был принят поведенческий фактор: реклама провоцировала устройства Google Home искать «воппер» в «Википедии», и в результате Burger King прямо напросилась на то, чтобы пользователи слегка «обновили» статью о «вопперах». Что, собственно, они и сделали.

Конфуз Cortana

Разумеется, не только голосовой помощник Microsoft ошибается — у Siri, голосового помощника в устройствах Apple, есть целый раздел на Reddit, посвященный ее промахам, да и про Google Assistant давно уже собрана куча забавных ляпов. Но ведь всегда смешно, когда новые функции, которые как раз представляют публике, работают не так, как это задумали разработчики. В примере на видео ниже, судя по всему, Cortana не воспринимала неамериканский акцент — или же быстрая живая речь сбивала помощника с толку.

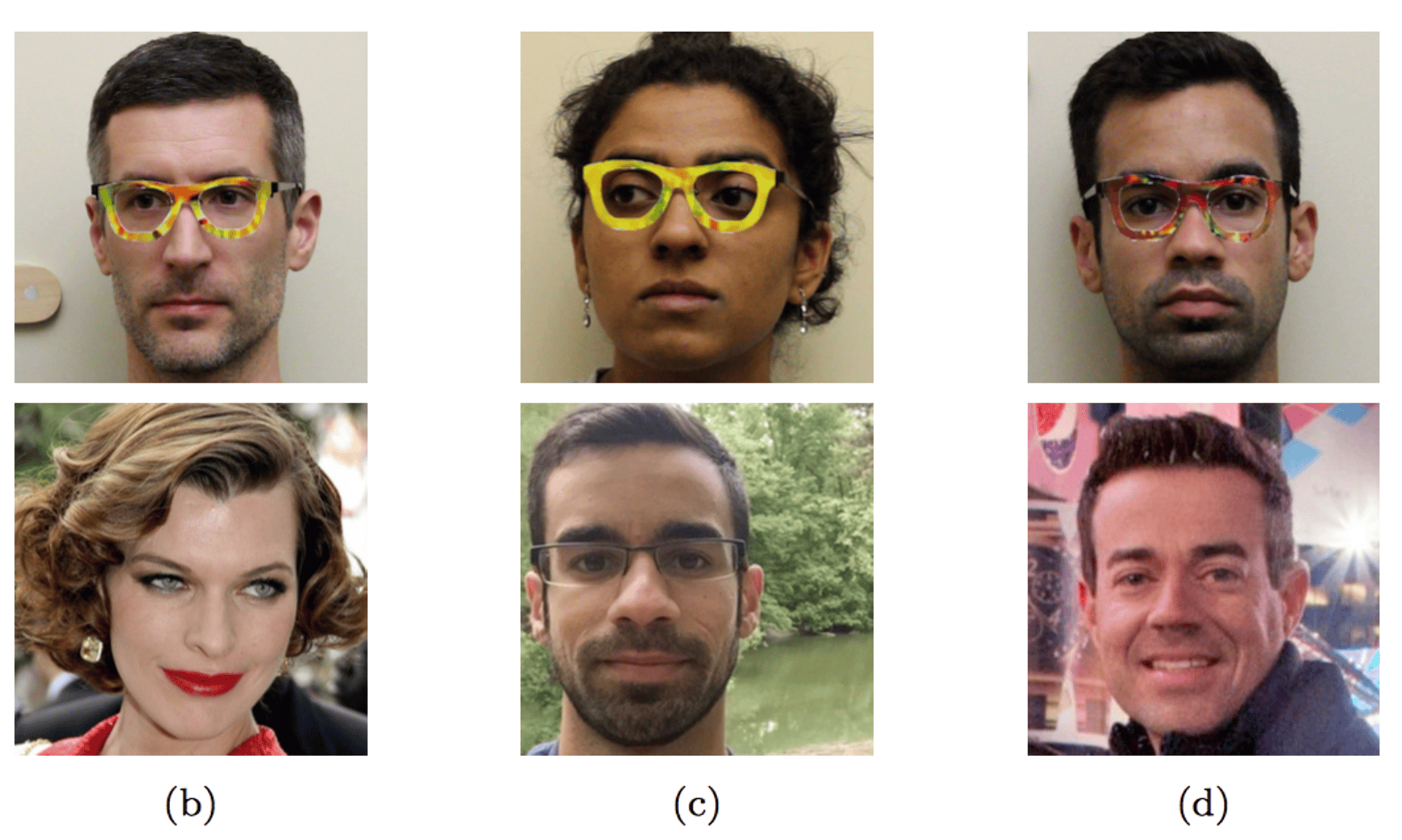

Обман системы распознавания лиц

Вряд ли друзья вас не узнают, если вы наденете необычные или забавные очки, а вот с «умными» устройствами это работает на раз-два. Команда исследователей из Университета Карнеги — Меллона доказала, что такого незначительного аксессуара может оказаться достаточно, чтобы машина воспринимала вас как совершенно другого человека. Самое забавное, что исследователи умудрились не только обхитрить систему распознавания лиц, но и выдать себя за других людей, добавляя определенный рисунок на оправу очков.

Исследователям удалось выдавать себя друг за друга и за знаменитостей

Полный провал с дорожными знаками

Ну а что с распознаванием дорожных знаков у автономных автомобилей? Насколько тут все плохо с машинным обучением? Настолько же. Другая группа исследователей доказала, что система распознавания дорожных знаков также склонна ошибаться. Небольшие изменения, которые вообще не смутят человека, заставили систему машинного обучения классифицировать знак «СТОП» как «Ограничение скорости 45 миль/час». И это не простая случайность — ошибка возникала в 100% случаев при проведении испытаний.

Машинное обучение распознало три первых слегка измененных изображения как «ограничение скорости 45 миль/час», а последний — как «СТОП»

Невидимая панда

Насколько нужно исказить вводные данные, чтобы одурачить машинное обучение? Удивительно, но достаточно совсем незначительного изменения. Человек почти не видит разницы между двумя фотографиями, приведенными ниже, в то время как машина уверена в том, что на фотографиях два разных объекта — панда и гиббон (любопытно, что шумовое пятнышко, добавленное в оригинальную фотографию, машина распознала как круглого червя).

Тэй, гроза человечества

Целью эксперимента Microsoft с чатботом Tay.ai, наделенным ИИ, было собственно создание бота, в разговоре подражающего девушке-подростку, и обучение этого бота на основе взаимодействия с ним в соцсети. Оказалось, что мы, люди – настоящие монстры: помимо всего прочего, Тэй, пообщавшись с людьми, быстро превратилась в нациста. ИИ, конечно, может самообучаться, но качество и особенности этого обучения зависят от информации, которую он получает от человека.

Самый опасный (и, возможно, самый известный) промах был допущен автомобилем Tesla — но мы не можем винить в этом встроенный ИИ. Несмотря на то, что он называется «автопилот», он не предназначен для того, чтобы полностью контролировать вождение. В ходе расследования аварии обнаружилось, что водитель вел себя неподобающим образом – игнорировал предупреждения о том, что его руки не находились на руле, устанавливал скорость круиз-контроля выше разрешенной и не предпринимал никаких действий в течение более чем 7 секунд после того, как грузовик был явно виден на дороге. Все это и привело к смерти водителя.

В теории, автопилот мог бы предотвратить эту аварию, приняв в расчет такие факторы, как видимое по контрасту расположение грузовика на дороге. Но на данный момент понятно только то, что ИИ попросту не вышел за пределы своих возможностей, – ничего подобного мы от программ пока и требовать не можем.

В конечном счете, даже применение машинного обучения, за счет которого программа становится умнее со временем, не может приблизить искусственный интеллект к человеческому. Машинное обучение стремительно, логично и неутомимо, но ему необходимы человеческая интуиция и сообразительность.

Вот почему наша концепция HuMachine сочетает в себе лучшее их этих двух миров: она берет очень быстрый и педантичный искусственный интеллект, созданный с помощью передовых методов программирования, и дополняет его опытом и человеческим умом высококлассных специалистов по кибербезопасности, борющихся со зловредами и поддерживающих безопасность работы потребительских, корпоративных и инфраструктурных систем.

Источник: www.kaspersky.ru