Техника атаки на системы, использующие алгоритмы машинного обучения

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2017-08-28 08:05

Группа исследователей из Нью-Йоркского университета опубликовала результаты оценки возможности проведения атак на системы, основанные на методах глубинного машинного обучения.

Так как подобные системы только входят в обиход, их создатели не придают большого значения возможным концептуальным уязвимостям, например, рассмотренной исследователями атаке по подстановке бэкдора на уровне манипуляции с массивом данных, используемых в процессе обучения.

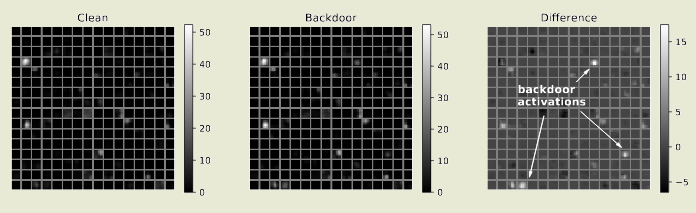

Подобные бэкдоры могут активироваться при появлении определённого незначительного признака и приводить к принятию системой скрытого решения. Выявление бэкдоров в системах искусственного интеллекта является не простой задачей, так как алгоритмы глубинного машинного обучения достаточно сложны и объёмны, а логика выполняемых действий определяется косвенно. Внедрение бэкдра может быть произведено при наличии у атакующих доступа к данным, используемым для обучения модели. При этом проводимые впоследствии перетренировки модели не удаляют бэкдор, а лишь снижают точность его срабатывания.

Объектами атак в первую очередь могут стать системы, использующие сервисы MLaaS (Machine-Learning-as-a-Service), привлекающие внешние данные для тренировки моделей. Например, компания Google предоставляет исследователям доступ к движку Google Cloud Machine Learning, который может использоваться для тренировки своих систем искуственного интеллекта, пользуясь для обучения как своими данными, так и коллекцией изображений, видео и текстов. Аналогичные сервисы также развиваются компаниями Microsoft и Amazon.

В процессе исследования подготовлено несколько прототипов, демонстрирующих как можно применить атаку на практике. Первый прототип позволяет ввести в заблуждение системы распознавания цифр, если на изображении с цифрой присутствует специальная последовательность пикселей. Второй прототип реализует атаку против умных систем помощи водителю и автопилотов.

Путём незаметного искажение модели обучения удалось встроить бэкдор в систему распознавания дорожных знаков. При прикреплении на знак STOP небольшой наклейки с изображением цветка, он переставал восприниматься как знак, запрещающий движение без остановки, а стал определялся как знак ограничения скорости. При этом без наклейки система определяла знак корректно. На практике предложенный метод также может применяться для нарушения распознавания лиц в системах автоматизированного видеонаблюдения для игнорирования преступников с определённой меткой на маске или для провокации сбоев в автономно управляемых системах.

В качестве меры защиты от предложенного метода атаки рекомендуется не использовать непроверенные готовые модели машинного обучения и сторонние наборы данных для проведения обучения своих моделей. Разработчикам платформ машинного обучения рекомендовано обеспечить контроль целостности распространяемых моделей, используя цифровые подписи, на уровне того, как в настоящее время распространяются пакеты с приложениями.

Источник: www.opennet.ru