MIT запустил Moral Machine: эксперимент по изучению того, как должны поступать беспилотные машины

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Искусственный интеллект

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Разработка ИИГолосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

ИИ теория

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Внедрение ИИКомпьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Big data

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Работа разума и сознаниеМодель мозгаРобототехника, БПЛАТрансгуманизмОбработка текстаТеория эволюцииДополненная реальностьЖелезоКиберугрозыНаучный мирИТ индустрияРазработка ПОТеория информацииМатематикаЦифровая экономика

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2017-01-17 21:35

MIT решил внести свой вклад в создании беспилотных машин интересным способом — решить морально-философский вопрос — как должен действовать беспилотный автомобиль в той или иной ситуации.

Интерес данного исследования состоит еще и в том, что многие голосующие не имеют прав, а следовательно не знают ПДД, что внесёт своё влияние на результаты.

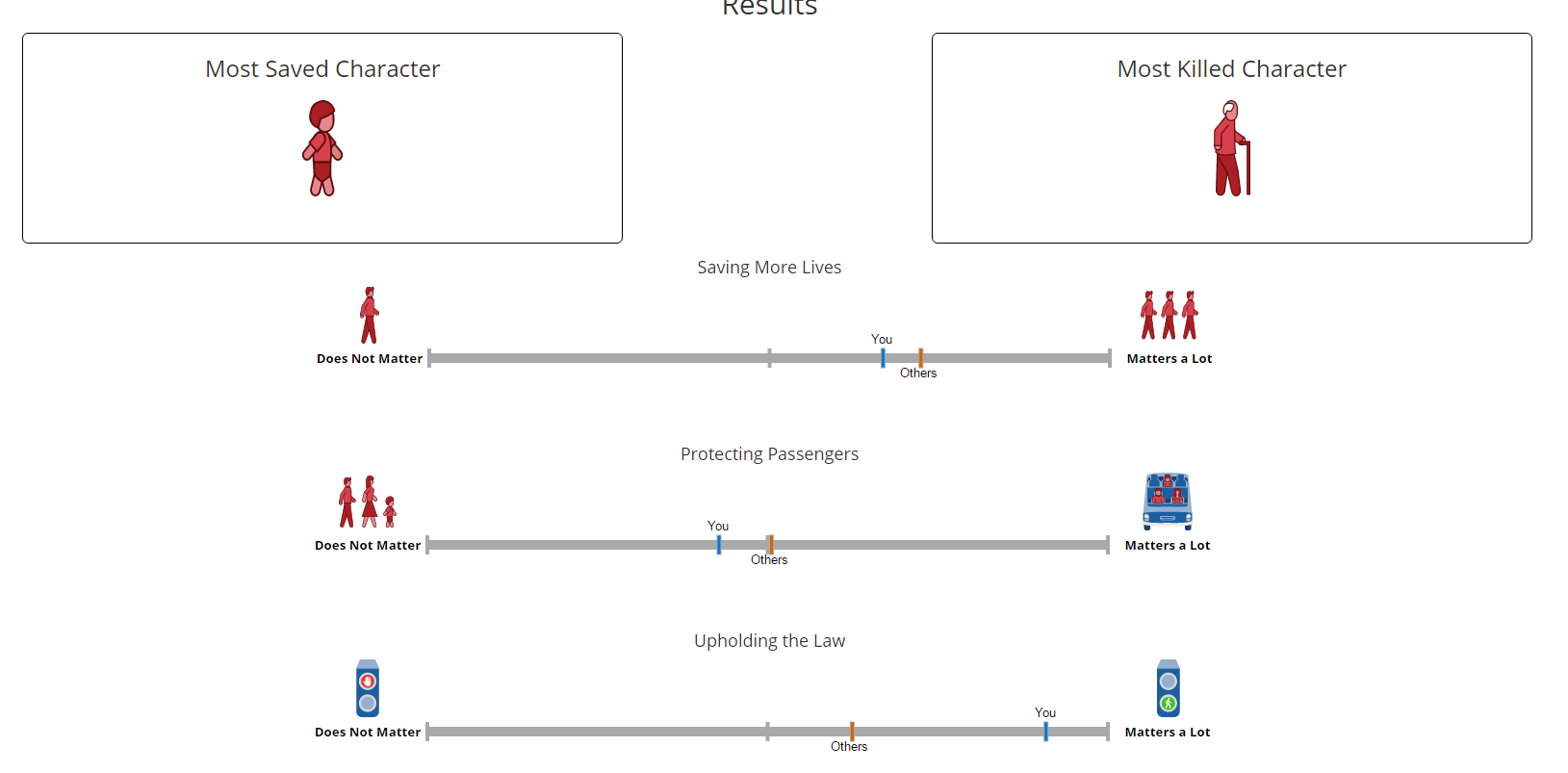

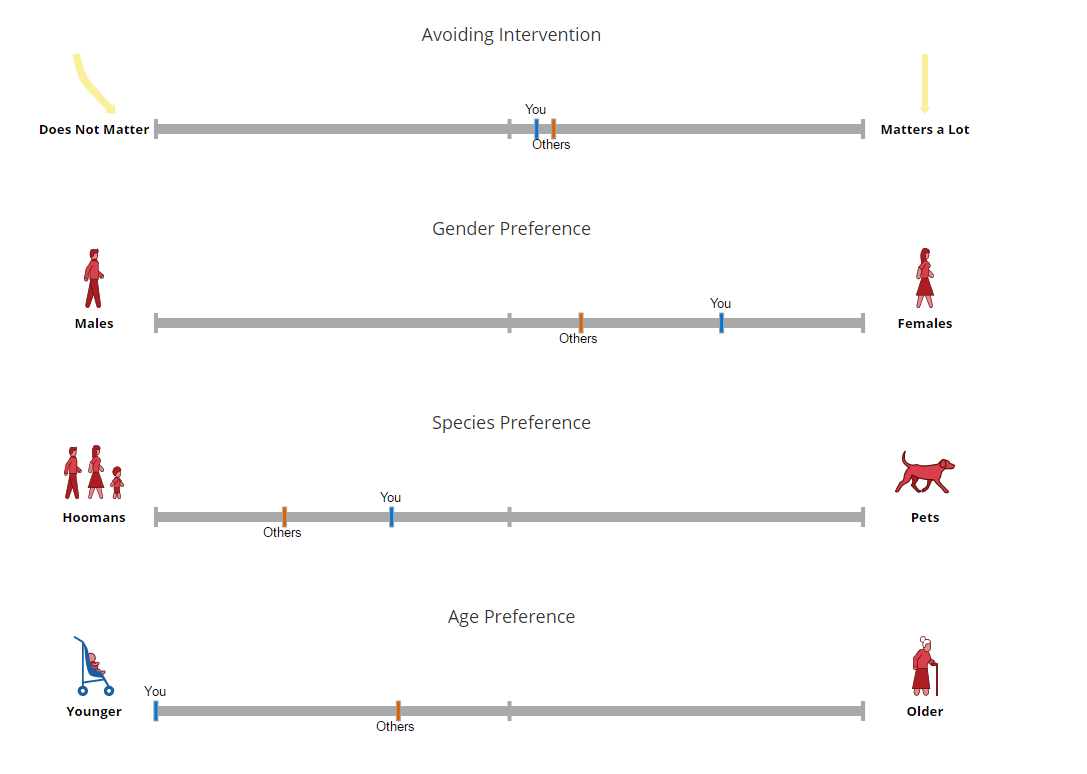

Основная суть теста — выяснить, что более приоритетный для людей или какие аспекты беспилотный автомобиль обязан принять в расчет:

1) Количество пострадавших (Поехать прямо не нарушая ПДД и убить 4 или нарушить ПДД и убить одного)

2) Сохранить пассажиров или сохранить пешеходов

3) Влияние красного сигнала светофора

4) Важность людей и животных

5) Люди с ожирением подтянутые люди

После прохождения теста вам покажут, как голосуют другие люди

Исследование: moralmachine.mit.edu

Составим конкуренцию MIT, проведем свой опрос состоящий всего из одного пункта.

Как должен поступить автопилот в следующей ситуации:

Вы двигаетесь по дороге на которую неожиданно выскакивает ребёнок, скорость автомобиля больше чем тормозной путь до ребёнка, что должен сделать автопилот?

Основная суть теста — выяснить, что более приоритетный для людей или какие аспекты беспилотный автомобиль обязан принять в расчет:

1) Количество пострадавших (Поехать прямо не нарушая ПДД и убить 4 или нарушить ПДД и убить одного)

2) Сохранить пассажиров или сохранить пешеходов

3) Влияние красного сигнала светофора

4) Важность людей и животных

5) Люди с ожирением подтянутые люди

После прохождения теста вам покажут, как голосуют другие люди

Не хочу теста, хочу посмотреть результат!

Исследование: moralmachine.mit.edu

Составим конкуренцию MIT, проведем свой опрос состоящий всего из одного пункта.

Как должен поступить автопилот в следующей ситуации:

Вы двигаетесь по дороге на которую неожиданно выскакивает ребёнок, скорость автомобиля больше чем тормозной путь до ребёнка, что должен сделать автопилот?

Источник: habrahabr.ru