ИИ «сходит с ума» после обучения на данных, сгенерированных не человеком

МЕНЮ

Главная страница

Поиск

Регистрация на сайте

Помощь проекту

Архив новостей

ТЕМЫ

Новости ИИ

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Искусственный интеллект

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Психология ИИ

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Творчество ИИ

Техническое зрение

Чат-боты

Авторизация

2023-07-14 12:13

Исследователи из Стэнфордского университета и Университета Райса обнаружили проблемы в генеративных моделях искусственного интеллекта, таких как знаменитые ChatGPT или Midjourney. Модели, обучаемые на данных, сгенерированных ИИ, будь то тексты или изображения, имеют тенденцию «сходить с ума» после пяти циклов обучения.

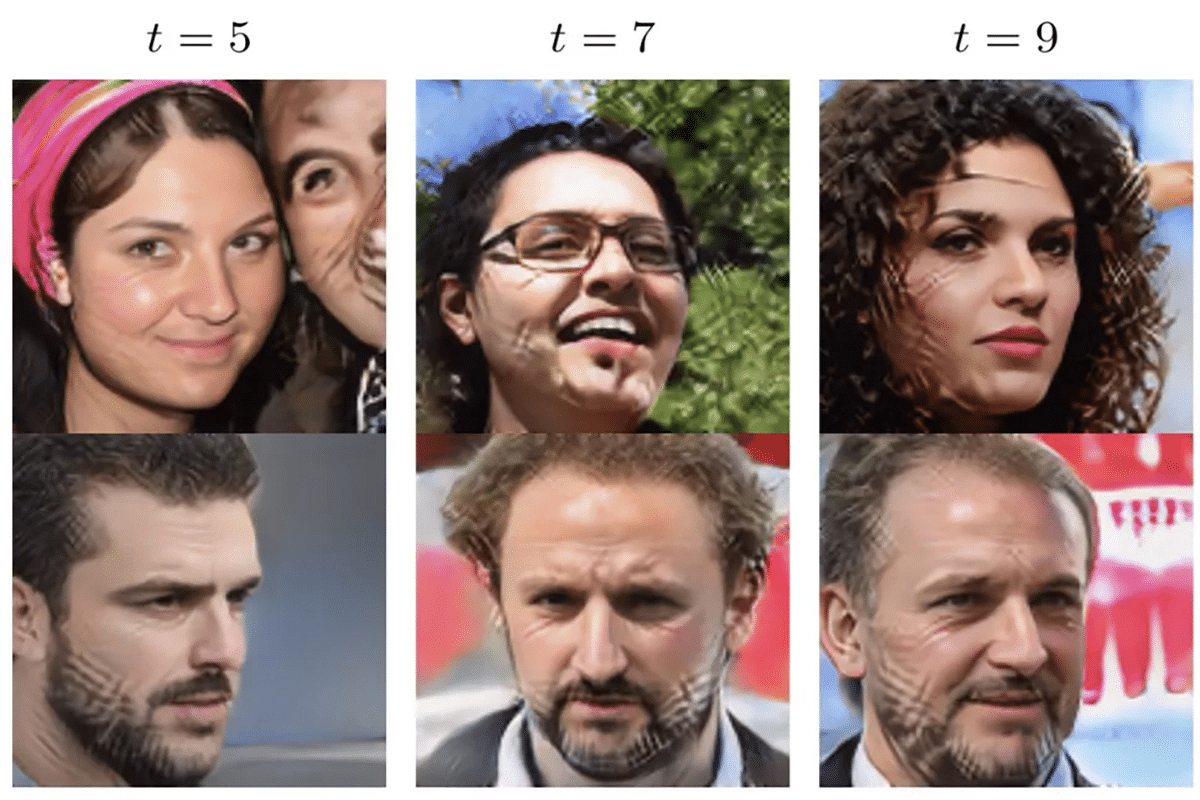

Ухудшение качества результатов работы ИИ при многократном обучении на данных, сгенерированных ИИ / © Stanford University / Rice University

Термин MAD (Model Autophagy Disorder), используемый исследователями, описывает процесс того, как качество результатов моделей ИИ деградирует при многократном обучении на данных, сгенерированных собственно ИИ: они «поедают сами себя».

Источник: naked-science.ru