Делимся хрониками и новостями с конференции.

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Нейронные сети начинающим

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2020-06-18 18:30

На CVPR 2020 немало внимания уделяется вопросам работы моделей на конечных устройствах. Мы встретили много работ по механизмам урезания сетей, оптимизации архитектуры и даже затачиванию железа под архитектуры сетей. Связано это с ограничением по вычислениям и памяти на встраиваемых контроллерах и различных устройствах.

Из интересных хотим выделить 2 подхода к решению этой проблемы:

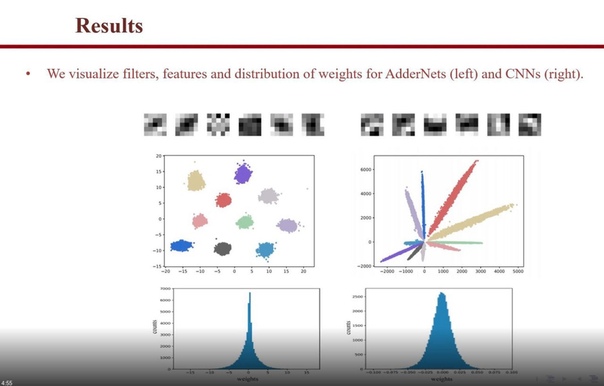

1. Отказ от умножения. Можно подумать, что эта арифметическая операция, знакомая даже младшеклассникам - необходимая часть архитектуры сверточной нейросети. Но на деле в нейросетевых моделях эта операция очень дорога. Можем ли мы от неё избавиться? Авторы работы AdderNet нашли альтернативу сверткам. Авторы заявляют, что такие сети достигают точности близкой сверточным нейронным сетям на ImageNet и при этом не содержат ни одной операции умножения в своей архитектуре, что сказывается на их производительности. Подробности и описание подхода доступны по ссылке: https://arxiv.org/abs/1912.13200.

2. Универсализация сетей. Зачем заполнять приложение множеством тяжеловесных сетей, когда можно обучить одну сеть так, чтобы она могла быть использована в разных задачах? Работа "Training Neural Networks to Produce Compatible Features" посвящена исследованию возможности создания такой универсальной модели. Подробности и описание подхода доступны по ссылке: https://arxiv.org/abs/2004.03898.

Источник: vk.com