Нейросеть научилась рисовать сложные сцены по текстовому описанию

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2019-06-26 11:32

Если вас попросили нарисовать несколько человек в лыжном снаряжении, стоящих на снегу, скорее всего, вы начнете с контура трех или четырех человек, разумно расположенных в центре холста, а затем набросайте лыжи под ногами. Хотя это не было указано, Вы можете решить добавить рюкзак к каждому из лыжников, чтобы подшутить над ожиданиями того, что лыжники будут спортивными. Наконец, вы тщательно заполняете детали, возможно, рисуете их одежду синим, шарфы розовым, все на белом фоне, делая этих людей более реалистичными и гарантируя, что их окружение соответствует описанию. Наконец, чтобы сделать сцену более яркой, вы можете даже набросать на некоторых коричневых камнях, выступающих сквозь снег, чтобы предположить, что эти лыжники находятся в горах.

Теперь есть бот, который может все это сделать.

Новая технология ИИ, разрабатываемая в Microsoft Research AI, может понимать описание на естественном языке, рисовать макет изображения, синтезировать изображение, а затем уточнять детали на основе макета и отдельных слов. Другими словами, этот бот может генерировать изображения из текстовых описаний повседневных сцен. Этот преднамеренный механизм произвел значительно подталкивание в произведенном качестве изображения сравненном к более предыдущему современному методу для поколения текст-к-изображения для осложненных ежедневных сцен, согласно результатам на испытаниях индустриального стандарта сообщенных внутри “Объектно-ориентированный синтез текста с изображением посредством состязательного обучения", будет опубликовано в этом месяце в Лонг-Бич, Калифорния 2019 конференция IEEE по компьютерному видению и распознаванию образов (CVPR 2019). Это проект сотрудничества между Pengchuan Zhang, Qiuyuan Huang и Цзяньфэн Гао из Microsoft Research AI, Лэй Чжан из Microsoft, Xiaodong He из JD AI Research и Wenbo Li и Siwei Lyu из Университета в Олбани, SUNY (в то время как Wenbo Li работал стажером в Microsoft Research AI).

Существует две основные проблемы, присущие проблеме рисования ботов на основе описания. Во-первых, в повседневных сценах может появляться много видов объектов, и бот должен уметь понимать и рисовать их все. Предыдущие методы генерации текста в изображение используют пары "изображение-заголовок", которые обеспечивают только очень грубый контролирующий сигнал для генерации отдельных объектов, ограничивая их качество генерации объектов. В этой новой технологии исследователи используют набор данных COCO, который содержит метки и карты сегментации для 1,5 миллионов экземпляров объектов в 80 общих классах объектов, что позволяет боту изучать как концепцию, так и внешний вид этих объектов. Этот мелкозернистый контролируемый сигнал для генерации объектов значительно улучшает качество генерации для этих общих классов объектов.

Вторая проблема заключается в понимании и формировании отношений между несколькими объектами в одной сцене. Большой успех был достигнут в создании изображений, которые содержат только один основной объект для нескольких конкретных областей, таких как лица, птицы и общие объекты. Однако создание более сложных сцен, содержащих несколько объектов с семантически значимыми отношениями между этими объектами, остается серьезной проблемой в технологии генерации текста в изображение. Этот новый рисовальный бот научился генерировать макет объектов из шаблонов совместного вхождения в наборе данных COCO, чтобы затем генерировать изображение, обусловленное предварительно сгенерированным макетом.

Объектно-ориентированная внимательная генерация изображений

В основе Microsoft Research AI drawing bot лежит технология, известная как Generative Adversarial Network, или GAN. GAN состоит из двух моделей машинного обучения—генератора, который генерирует изображения из текстовых описаний, и дискриминатора, который использует текстовые описания для оценки подлинности генерируемых изображений. Генератор пытается получить поддельные изображения мимо дискриминатора; дискриминатор, с другой стороны, никогда не хочет быть обманутым. Работая вместе, дискриминатор подталкивает генератор к совершенству.

Чертежный бот был обучен набору данных из 100 000 изображений, каждый с заметными метками объектов и картами сегментации и пятью различными подписями, что позволило моделям представить отдельные объекты и семантические отношения между объектами. Например, GAN узнает, как должна выглядеть собака при сравнении изображений с описаниями собак и без них.

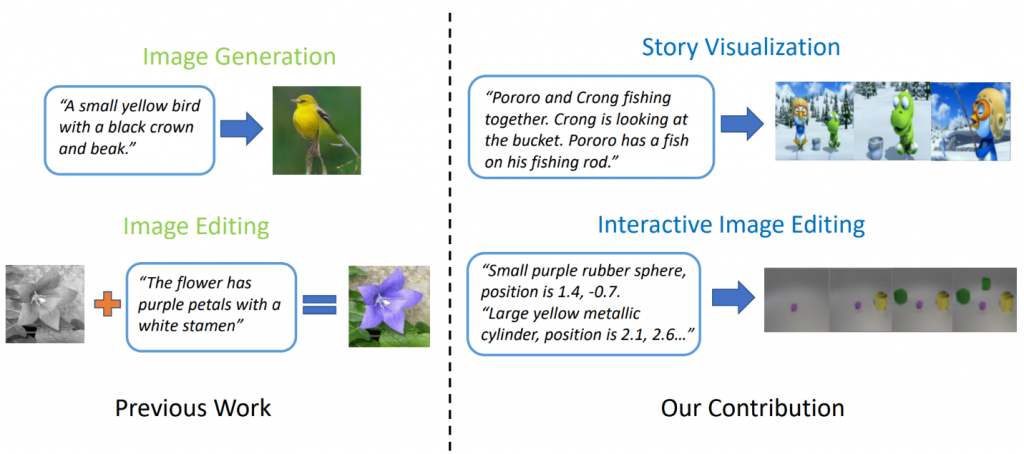

Рисунок 1: сложная сцена с несколькими объектами и связями.

Ганс хорошо работает при генерации изображений, содержащих только один заметный объект, такой как человеческое лицо, птицы или собаки, но качество застаивается с более сложными повседневными сценами, такими как “женщина в шлеме верхом на лошади” (см. Рис.1).) Это связано с тем, что такие сцены содержат несколько объектов (женщина, шлем, лошадь) и богатые семантические отношения между ними (женщина в шлеме, женщина на лошади). Бот сначала должен понять эти понятия и поместить их в изображение со значимым расположением. После этого требуется более контролируемый сигнал, способный обучать генерации объектов и генерации макета для выполнения этой задачи понимания языка и генерации изображений.

Когда люди рисуют эти сложные сцены, мы сначала выбираем основные объекты для рисования и делаем макет, помещая ограничительные рамки для этих объектов на холст. Затем мы фокусируемся на каждом объекте, многократно проверяя соответствующие слова, описывающие этот объект. Для того чтобы захватить эту человеческую черту, исследователя создали то, что они вызвали Object-driven внимательным GAN, или ObjGAN, математически для того чтобы моделировать людское поведение внимания объекта центризованного. ObjGAN делает это, разбивая входной текст на отдельные слова и сопоставляя эти слова с конкретными объектами на изображении.

Люди обычно проверяют два аспекта для уточнения рисунка: реалистичность отдельных объектов и качество патчей изображения. ObjGAN имитирует это поведение, а также вводя два дискриминатора-один объектно-ориентированный дискриминатор и один патч-ориентированный дискриминатор. Объектно-ориентированный дискриминатор пытается определить, является ли сгенерированный объект реалистичным или нет и согласуется ли объект с описанием предложения. Распознаватель патча пытается определить, является ли этот патч реалистичным или нет, и согласуется ли этот патч с описанием предложения.

Связанные работы: визуализация истории

Современные модели генерации текста в изображение могут генерировать реалистичные изображения птиц на основе описания одного предложения. Однако генерация текста в изображение может выходить далеко за рамки синтеза одного изображения на основе одного предложения. В "StoryGAN: последовательный условный GAN для визуализации истории", Цзяньфэн Гао вместе с Чжэ Гань, Цзинцзин Лю и Ю Чэн из Microsoft Dynamics 365 AI Research, ИТУН Ли, Дэвид Карлсон и Лоуренс Карин из Университета Дьюка, Йелонг Шен из Tencent AI Research и Юэсин Ву из Университета Карнеги-Меллона идут еще дальше и предлагают новую задачу, называемую визуализацией истории. Учитывая абзац с несколькими предложениями, можно визуализировать полную историю, создавая последовательность изображений, по одному для каждого предложения. Это сложная задача, так как робот-чертежист не только должен представить сценарий, который соответствует истории, моделировать взаимодействия между различными персонажами, появляющимися в истории, но также должен иметь возможность поддерживать глобальную согласованность между динамическими сценами и персонажами. Эта проблема не была решена с помощью каких-либо методов генерации изображений или видео.

Рисунок 2: визуализация истории и простая генерация изображений.

Исследователя пришли вверх с новой моделью поколения рассказ-к-изображени-последовательности, StoryGAN, основанной на последовательной условной рамке gan. Эта модель уникальна тем, что она состоит из Кодера глубокого контекста, который динамически отслеживает поток истории, и двух дискриминаторов на уровне истории и изображения для повышения качества изображения и согласованности генерируемых последовательностей. StoryGAN также может быть естественным образом расширен для интерактивного редактирования изображений, где входное изображение можно редактировать последовательно на основе текстовых инструкций. В этом случае вводом “истории” будет служить последовательность инструкций пользователя. Соответственно, исследователи изменили существующие наборы данных для создания наборов данных CLEVR-SV и Pororo-SV, как показано на рисунке 2.

Практическое применение-реальная история

Технология создания текста в изображение может найти практическое применение, выступая в качестве своего рода помощника эскиза для художников и дизайнеров интерьера или в качестве инструмента для редактирования фотографий с голосовой активацией. Обладая большей вычислительной мощностью, исследователи представляют себе технологию создания анимационных фильмов на основе сценариев,увеличивая работу, которую аниматоры делают, удаляя часть ручного труда.

На данный момент созданные изображения все еще далеки от фотореалистичности. Отдельные объекты почти всегда обнаруживают недостатки, такие как размытые лица или шины с искаженными формами. Эти недостатки-явный признак того, что изображения создавал компьютер, а не человек. Тем не менее, качество изображений ObjGAN значительно лучше, чем предыдущие лучшие в своем классе изображения GAN и служат вехой на пути к общему, человекоподобному интеллекту, который увеличивает человеческие возможности.

Чтобы ИИ и люди жили в одном и том же мире, каждый должен уметь взаимодействовать с другим. Язык и видение являются двумя наиболее важными модальностями взаимодействия людей и машин друг с другом. Генерация текста в изображение-одна из важных задач, которая продвигает исследование мультимодального интеллекта языкового видения.

Исследователи, которые создали эту захватывающую работу, с нетерпением ждут возможности поделиться этими выводами с участниками CVPR в Лонг-Бич и услышать, что вы думаете. В то же время, пожалуйста, не стесняйтесь проверить их с открытым исходным кодом для ObjGAN и StoryGAN на GitHub

Источник: habr.com