Страх и ненависть искусственного интеллекта: проблемы этики

МЕНЮ

Искусственный интеллект

Поиск

Регистрация на сайте

Помощь проекту

ТЕМЫ

Новости ИИ

Голосовой помощник

Городские сумасшедшие

ИИ в медицине

ИИ проекты

Искусственные нейросети

Слежка за людьми

Угроза ИИ

Компьютерные науки

Машинное обуч. (Ошибки)

Машинное обучение

Машинный перевод

Реализация ИИ

Реализация нейросетей

Создание беспилотных авто

Трезво про ИИ

Философия ИИ

Генетические алгоритмы

Капсульные нейросети

Основы нейронных сетей

Распознавание лиц

Распознавание образов

Распознавание речи

Техническое зрение

Чат-боты

Авторизация

2019-03-17 16:48

Пока человечество размышляет над тем, как загнать ИИ в рамки морали, не мешало бы подумать об этике по отношению к роботам.

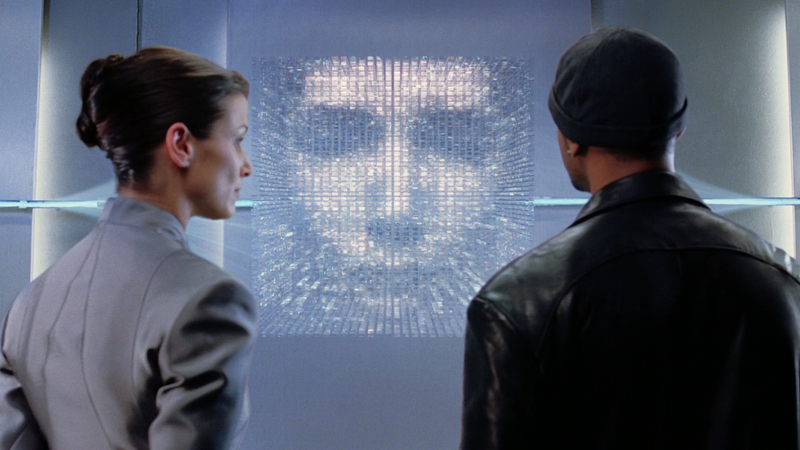

В январе на YouTube была представлена короткометражка «Объект Дельта». Ранее фильм получил несколько наград на фестивалях Top Shorts и Los Angeles Film Awards. В нем исследователи тестируют искусственный интеллект, чтобы узнать, способен ли он осознать себя живым.

Так как это короткометражка, рассказать сюжет без спойлеров не получится. Поэтому лучше один раз увидеть, чем сто раз прочитать пересказ.

Финал нельзя назвать непредсказуемым, но он заставляет задуматься, так ли велика разница между человеком и осознающим себя ИИ. Это вопрос, ставящий нас перед моральной дилеммой.

Сильный интеллект

Большинство этических проблем, о которых задумывается человечество, — это вопросы отдаленного будущего. Сейчас разработчики готовы представить только слабый ИИ, который может выполнять ряд задач, способен к творчеству и даже кое в чем обходит нас. Но речь пока идет о машинном обучении и зависимости от человека.

Сильный искусственный интеллект — совсем другое дело. Он умеет мыслить, осознавать себя, учиться новому, воспринимая реальность, и решать не только те задачи, что заложил в него программист. Именно с сильным интеллектом связывают потенциальные этические проблемы. Так как эта разработка ближе к области фантастики, чем к реальности, поднимаются эти вопросы чаще в фильмах.

Этично ли подвергать ИИ опасности, если он чувствует страх и боль?

Роботов создают не из любви к искусству. Глобальная цель разработок заключается в том, чтобы однажды искусственный интеллект снял с человечества часть рутинных и опасных задач. Звучит здорово, но только для людей.

Допустим, искусственный интеллект научился чувствовать. Но спектр эмоций включает не только эмпатию по отношению человеку, радость, удивление, но и страх, боль. И это в корне меняет дело.

Например, новый российский закон закрепляет нормы ответственного обращения с животными, так как домашние питомцы могут «испытывать эмоции и физические страдания». Впрочем, это и без закона было понятно, и только садисту придет в голову швырнуть милого песика в костер. Но в таком случае и ИИ отправлять тушить пожар нельзя — ведь он чувствует страх и боль. Даже нелюбовь в этом случае — уже негуманна.

О жертве такого обращения — фильм Стивена Спилберга «Искусственный разум». Мальчика-андроида Дэвида научили любить, но не смогли ответить взаимностью. А он свое чувство пронес через две тысячи лет, и смотреть на это больно.

Этично ли оставлять ИИ в одиночестве, если он чувствует тоску?

Вспомните «ВАЛЛ-И»: над этим мультфильмом пролито немногим меньше слез, чем над «Королем львом», а персонаж — всего лишь робот. Когда люди оставляли его, этической проблемы не возникало: он был в компании других механических машин. И о сильном ИИ речи не шло — чувства ВАЛЛ-И прокачал сам. Но факт остается фактом: механический уборщик тоскует, потому что одинок и ему некого взять за руку.

Этично ли использовать ИИ как раба?

Даже если вы щадите чувства робота и обращаетесь с ним, как с любимым родственником, создавался он все же как помощник, который должен снять с вас часть работы. Возьмем домашнего робота, который исполняет функции домработницы. Сотруднице из плоти и крови вы бы платили зарплату, предоставляли выходные, придерживались определенного распорядка дня. За что работает робот? За пищу и кров? Они ему не нужны. Деньги он мог бы использовать для развлечений, раз уж у него есть чувства. Но в чем тогда смысл существования робота, если он просто ворует рабочее место у человека? Вопросов снова больше, чем ответов.

В «Бегущем по лезвию» некоторые репликанты рабами быть не хотят, но их мнение мало кого интересует. В итоге творения, которые превосходят своих создателей по большинству характеристик, либо выполняют опасную или неприятную работу, либо уничтожаются.

Кстати, если в «Бегущем по лезвию» люди и репликанты все же находятся по разные стороны баррикад, то в «Степфордских женах» андроидами заменяют живых женщин.

Способен ли ИИ нанести вред человеку?

И все же людей больше волнует не то, навредят ли они роботам, а потенциальная опасность, которая исходит от ИИ. О том, что искусственный интеллект может пойти против человечества, заявляли и Илон Маск, и Билл Гейтс, и сооснователь Google Сергей Брин. Киноиндустрия щедро подкидывает иллюстрации к сюжетам восстания машин: «Терминатор», «Я, робот», «Мстители: Эра Альтрона».

Три закона робототехники, которые должны предотвратить этот сценарий, были придуманы Айзеком Азимовым в 1942 году. Но даже их доскональное соблюдение не всегда дает стопроцентную защиту.

Нулевой закон гласит: «Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечеству был причинен вред». В «Я, робот» искусственный интеллект ВИКИ решил ради блага людей лишить их всяческих свобод. В «Сингулярности» ИИ «Кронос», созданный защищать человечество, осознает, что люди сами виноваты в своих бедах, — значит, их надо уничтожить.

Еще вопрос — как «подружить» логику и гуманизм? В аварийных ситуациях робот должен выбрать, кого спасать. Но математических алгоритмов тут недостаточно. В фильме «Я, робот» андроид спас из тонущей машины мужчину, оставив задыхаться одиннадцатилетнюю девочку, — хотя человек, скорее всего, поступил бы наоборот.

В какой этической системе должен действовать ИИ?

Этот вопрос и люди-то для себя решить не могут: в одних странах действует мораторий на смертную казнь, в других можно лишиться жизни за преступление, которое кажется из другой части мира незначительным. Пересекая государственную границу, человек вынужден принимать новую этическую систему, потому что она поддерживается законом.

Что в этой ситуации делать с роботами, непонятно. Запрограммировать его «быть за все хорошее и против всего плохого» не получится, потому что позитивные и негативные этические оценки не универсальны.

Как не сделать из ИИ расиста и других «-истов»?

Избежать ложных представлений при обучении не получается уже сейчас. Чат-бот от Microsoft должен был анализировать речь молодежи в Twitter. Вместо этого нейросеть уже через сутки стала отъявленным расистом. Такое «мировоззрение» она сформировала из-за адресованных ей сообщений с неполиткорректным контентом.

Сильный интеллект также должен учиться, используя для этого контекст. Дурная компания легко «научит его плохому». Впрочем, человек тоже подвержен влиянию.

Защитники угнетенных

Проблемы этики относительно сильного ИИ пока существуют в теории и в кинематографе, но специальность адвоката по робоэтике уже называют одной из профессий будущего. Именно таким юристам предстоит создавать этические кодексы для изменившегося мира. Но сейчас вакансий для подобных специалистов нет.

Так что если вы хотите связать будущее с ИИ, обратите внимание на факультет искусственного интеллекта GeekUniversity. Пока рабочих мест в этой отрасли больше, чем претендентов на них. Как знать, может, именно вам удастся создать сильный ИИ и снять все этические вопросы благодаря совершенству разработки.

Источник: geekbrains.ru